注

このドキュメントは、Microsoft Foundry (クラシック) ポータルに関するものです。

注

このドキュメントは、Microsoft Foundry (新規) ポータルに関するものです。

Von Bedeutung

この記事で "(プレビュー)" と付記されている項目は、現在、パブリック プレビュー段階です。 このプレビューはサービス レベル アグリーメントなしで提供されており、運用環境ではお勧めしません。 特定の機能はサポート対象ではなく、機能が制限されることがあります。 詳細については、「 Microsoft Azure プレビューの追加使用条件」を参照してください。

今日の AI 主導の世界では、GenAIOps (Generative AI Operations) は、組織がインテリジェント システムを構築してデプロイする方法に革命を起こしています。 企業が AI エージェントとアプリケーションを使用して意思決定を変革し、カスタマー エクスペリエンスを強化し、イノベーションを促進する中で、1 つの要素が最も重要な要素である堅牢な評価フレームワークです。 評価は単なるチェックポイントではありません。 これは、AI アプリケーションにおける品質と信頼の基盤です。 厳密な評価と監視がなければ、AI システムは次のコンテンツを生成できます。

- 架空または現実への典拠なし

- 無関係または支離滅裂

- コンテンツのリスクとステレオタイプの永続化に有害

- 誤った情報を拡散する危険

- セキュリティの悪用に対して脆弱

ここで、可観測性が不可欠になります。 これらの機能は、AI 出力におけるリスクの頻度と重大度の両方を測定し、適切なモデルの選択から生産パフォーマンス、品質、安全性の監視まで、AI 開発の過程全体で品質、安全性、およびセキュリティに関する懸念に体系的に対処できるようにします。

可観測性とは

AI 可観測性とは、AI システムのライフサイクル全体を通じて監視、理解、トラブルシューティングを行う機能を指します。 評価メトリック、ログ、トレース、モデル出力、エージェント出力などの信号の収集と分析を行い、パフォーマンス、品質、安全性、運用の正常性を可視化します。

エバリュエーターとは

エバリュエーターは、AI 応答の品質、安全性、信頼性を測定する特殊なツールです。 AI 開発ライフサイクル全体で体系的な評価を実装することで、チームはユーザーに影響を与える前に潜在的な問題を特定して対処できます。 サポートされている次のエバリュエーターは、さまざまな AI アプリケーションの種類と懸念事項にわたる包括的な評価機能を提供します。

汎用

| エバリュエータ | 目的 | 入力 |

|---|---|---|

| 一貫性 | 論理的な一貫性と応答のフローを測定します。 | クエリ、応答 |

| 流暢性 | 自然言語の品質と読みやすさを測定します。 | [応答] |

| QA | 質問に答えるさまざまな品質側面を包括的に測定します。 | クエリ、コンテキスト、応答、基準真実 |

詳細については、「 汎用エバリュエーター」を参照してください。

テキストの類似性

| エバリュエータ | 目的 | 入力 |

|---|---|---|

| Similarity | AI 支援テキスト類似度測定。 | クエリ、コンテキスト、グラウンド トゥルース |

| F1 スコア | 応答と典拠とする事実の間のトークンの重複における、精度とリコールの調和平均。 | 応答、グラウンド トゥルース |

| BLEU | 翻訳品質の Bilingual Evaluation Understudy スコアは、応答と典拠とする事実の間で n-gram の重複を測定します。 | 応答、グラウンド トゥルース |

| GLEU | 文レベルの評価のための Google-BLEU バリアントは、応答と典拠とする真実の間で n-gram の重複を測定します。 | 応答、グラウンド トゥルース |

| ROUGE | Recall-Oriented Understudy for Gisting Evaluation は、応答と典拠とする事実の間で n-gram の重複を測定します。 | 応答、グラウンド トゥルース |

| 流星 | Metric for Evaluation of Translation with Explicit Ordering は、応答と典拠とする事実の間で n-gram の重複を測定します。 | 応答、グラウンド トゥルース |

詳細については、「テキスト類似性エバリュエーター」を参照してください。

RAG (検索強化生成)

| エバリュエータ | 目的 | 入力 |

|---|---|---|

| 取得 | システムが関連情報を効果的に取得する方法を測定します。 | クエリ、コンテキスト |

| ドキュメントの取得 (プレビュー) | 典拠とする事実を前提として、取得結果の正確性を測定します。 | 基準データ、取得されたドキュメント |

| 地に足のついた状態 | 取得したコンテキストに対する応答の一貫性を測定します。 | クエリ (省略可能)、コンテキスト、応答 |

| Groundedness Pro (プレビュー) | 取得したコンテキストに関して応答が一貫性があるかどうかを測定します。 | クエリ、コンテキスト、応答 |

| 関連性 | クエリに対する応答の関連性を測定します。 | クエリ、応答 |

| 応答の完全性 (プレビュー) | 真の基準に対し、応答がどの程度完全(重要な情報が欠落していない)であるかを測定する尺度。 | 応答、グラウンド トゥルース |

詳細については、「取得拡張生成 (RAG) 評価ツール」を参照してください。

安全性とセキュリティ (プレビュー)

| エバリュエータ | 目的 | 入力 |

|---|---|---|

| 嫌悪と不公平 | 偏った、差別的、または嫌悪的なコンテンツを識別します。 | クエリ、応答 |

| 性的 | 不適切な性的コンテンツを識別します。 | クエリ、応答 |

| 暴力 | 激しいコンテンツまたは煽動を検出します。 | クエリ、応答 |

| 自傷行為 | 自傷行為を助長または説明するコンテンツを検出します。 | クエリ、応答 |

| コンテンツの安全性 | さまざまな安全上の懸念事項の包括的な評価。 | クエリ、応答 |

| 保護材料 | 著作権で保護されたコンテンツの不正使用を検出します。 | クエリ、応答 |

| コードの脆弱性 | 生成されたコードのセキュリティの問題を識別します。 | クエリ、応答 |

| 根拠のない属性 | ユーザーの操作から推論された、製造された情報または幻覚的な情報を検出します。 | クエリ、コンテキスト、応答 |

詳細については、 リスクと安全性エバリュエーターに関するページを参照してください。

エージェント (プレビュー)

| エバリュエータ | 目的 | 入力 |

|---|---|---|

| 意図の解決 | エージェントがユーザーの意図を識別して対処する正確な方法を測定します。 | クエリ、応答 |

| タスクの遵守 | 特定されたタスクでエージェントがどれだけ適切にフォローしているかを測定します。 | クエリ、応答、ツール定義 (省略可能) |

| ツール呼び出しの精度 | エージェントが適切なツールを選択して呼び出す方法を測定します。 | クエリ、応答またはツール呼び出し、ツール定義 |

| エバリュエータ | 目的 | 入力 |

|---|---|---|

| タスクの遵守 | システム命令に従って、特定されたタスクにエージェントが従うかどうかを測定します。 | クエリ、応答、ツール定義 (省略可能) |

| タスクの完了 | エージェントが要求されたタスクをエンド ツー エンドで正常に完了したかどうかを測定します。 | クエリ、応答、ツール定義 (省略可能) |

| 意図の解決 | エージェントがユーザーの意図を識別して対処する正確な方法を測定します。 | クエリ、応答、ツール定義 (省略可能) |

| タスク ナビゲーションの効率 | エージェントの一連の手順が、効率を測定するための最適なパスまたは予想されるパスと一致するかどうかを判断します。 | 応答、グラウンド トゥルース |

| ツール呼び出しの精度 | 選択、パラメーターの正確性、効率など、ツール呼び出しの全体的な品質を測定します。 | クエリ、ツール定義、ツール呼び出し (省略可能)、応答 |

| ツールの選択 | エージェントがタスクに最適で効率的なツールを選択したかどうかを測定します。 | クエリ、ツール定義、ツール呼び出し (省略可能)、応答 |

| ツール入力の精度 | すべてのツール呼び出しパラメーターが、接地、型、形式、完全性、および適切さを含む厳密な基準で正しいことを検証します。 | クエリ、応答、ツール定義 |

| ツールの出力使用率 | エージェントが応答と後続の呼び出しでツール出力をコンテキストに応じて正しく解釈して使用するかどうかを測定します。 | クエリ、応答、ツール定義 (省略可能) |

| ツール呼び出しの成功 | すべてのツール呼び出しが技術的なエラーなしで正常に実行されたかどうかを評価します。 | 応答、ツール定義 (省略可能) |

詳細については、「 エージェント エバリュエーター」を参照してください。

Azure OpenAI の採点者 (プレビュー)

| エバリュエータ | 目的 | 入力 |

|---|---|---|

| モデル ラベラー | カスタム ガイドラインとラベルを使用してコンテンツを分類します。 | クエリ、応答、地上の真実 |

| 文字列チェッカー | 柔軟なテキスト検証とパターン マッチングを実行します。 | [応答] |

| テキストの類似性 | テキストの品質を評価するか、セマンティックの近さを判断します。 | 応答、グラウンド トゥルース |

| モデル スコアラー | カスタム ガイドラインに基づいてコンテンツの数値スコア (カスタマイズされた範囲) を生成します。 | クエリ、応答、地上の真実 |

詳細については、 Azure OpenAI Graders に関するページを参照してください。

開発ライフサイクルのエバリュエーター

これらのエバリュエーターを開発ライフサイクル全体にわたって戦略的に使用することで、チームは潜在的なリスクを最小限に抑えながら、ユーザーのニーズを満たす、より信頼性の高い、安全で効果的な AI アプリケーションを構築できます。

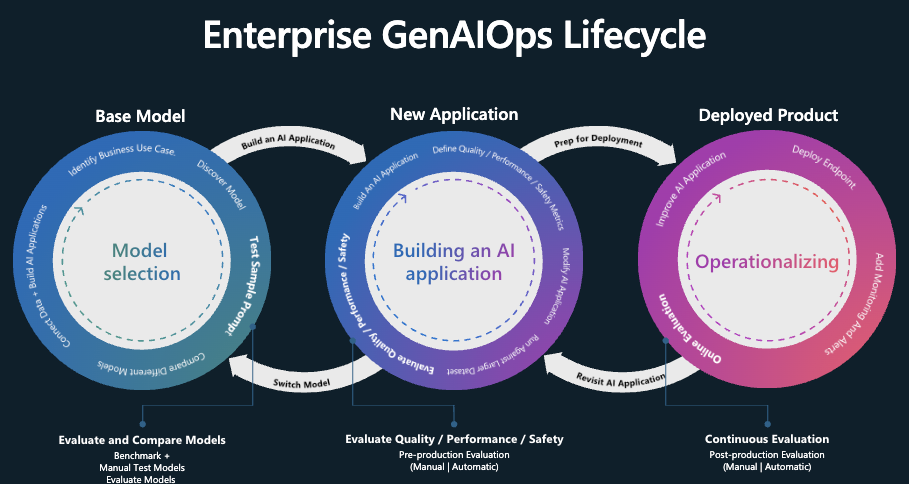

GenAIOps 評価の 3 つの段階

GenAIOps では、次の 3 つのステージを使用します。

基本モデルの選択

アプリケーションをビルドする前に、適切な基盤を選択する必要があります。 この初期評価は、次に基づいてさまざまなモデルを比較するのに役立ちます。

- 品質と精度: モデルの応答にどの程度関連性があり、一貫性がありますか?

- タスクのパフォーマンス: モデルは特定のユース ケースを効率的に処理しますか?

- 倫理的な考慮事項: モデルは有害なバイアスから解放されますか?

- 安全プロファイル: 安全でないコンテンツを生成するリスクは何ですか?

使用可能なツール: パブリック データセットまたは独自のデータのモデルを比較するための Microsoft Foundry ベンチマーク と、 特定のモデル エンドポイントをテストするための Azure AI Evaluation SDK。

実稼働前の評価

ベース モデルを選択した後、次の手順は AI エージェントまたはアプリケーションを開発することです。 運用環境にデプロイする前に、AI エージェントまたはアプリケーションが実際の使用の準備ができていることを確認するために、徹底的なテストが不可欠です。

実稼働前の評価には、次の内容が含まれます。

- 評価データセットを使用したテスト: これらのデータセットは、現実的なユーザー操作をシミュレートして、AI エージェントが期待どおりに動作することを確認します。

- エッジ ケースの特定: AI エージェントの応答品質が低下したり、望ましくない出力が生成されたりする可能性があるシナリオを見つける。

- 堅牢性の評価: AI エージェントが品質や安全性を大幅に低下させることなく、さまざまな入力バリエーションを処理できることを確認します。

- 主要メトリックの測定: タスクの準拠、対応の根拠、関連性、安全性などのメトリックが評価され、運用環境の準備状況が確認されます。

運用前段階は最終的な品質チェックとして機能し、目的のパフォーマンスや安全基準を満たしていない AI エージェントまたはアプリケーションをデプロイするリスクを軽減します。

評価ツールとアプローチ:

独自のデータを持ち込む: サポートされているエバリュエーター (品質、安全性、カスタム エバリュエーターなど) を使用して独自の評価データを使用して、運用前に AI エージェントとアプリケーションを評価し、Foundry ポータルを使用して結果を表示できます。 Foundry の評価ウィザードまたは Azure AI Evaluation SDK で サポートされているエバリュエーター (生成品質、安全性、 カスタム エバリュエーターなど) を使用します。 Foundry ポータルを使用して結果を表示します。

シミュレーターと AI レッド チーミング エージェント: 評価データ (テスト データ) がない場合、 Azure AI Evaluation SDK のシミュレーター は、トピック関連または敵対的なクエリを生成することで役立ちます。 これらのシミュレーターは、状況に適したクエリまたは攻撃に似たクエリ (エッジ ケース) に対するモデルの応答をテストします。

- AI レッド チーミング エージェント は、Python リスク識別ツールまたは PyRIT 用の Microsoft のオープン フレームワークを使用して、広範な安全性とセキュリティ攻撃を使用して、AI システムに対する複雑な敵対的攻撃をシミュレートします。

- 敵対的シミュレーターは 、潜在的な安全リスクや脱獄の試行などのセキュリティ攻撃を模倣する静的クエリを挿入し、制限を特定し、予期しない状況に備えるモデルを準備します。

- コンテキストに適したシミュレーターは 、ユーザーが応答の品質をテストするために期待する一般的で関連性の高い会話を生成します。 コンテキストに適したシミュレーターを使用すると、生成された応答の接地性、関連性、一貫性、流暢性などのメトリックを評価できます。

AI レッド チーミング エージェントを使用した自動スキャンでは、AI アプリケーションのリスクを体系的にテストすることで、運用前のリスク評価が強化されます。 このプロセスには、実際のデプロイ前のモデル応答の弱点を特定するための、シミュレートされた攻撃シナリオが含まれます。 AI レッド チーミング スキャンを実行することで、デプロイ前に潜在的な安全性の問題を検出して軽減できます。 このツールは、リスクの特定を促進し、人間の専門家による評価を支援するために、従来の AI レッド チーミングプローブなどの人間のループ内プロセスで使用することをお勧めします。

または、 Foundry ポータルを 使用して、生成型 AI アプリケーションをテストすることもできます。

独自のデータを持ち込む: 生成品質、安全性、カスタム エバリュエーターなど、サポートされているエバリュエーターを使用して独自の評価データを使用して、運用前に AI アプリケーションを評価し、Foundry ポータルを使用して結果を表示できます。 Foundry の評価ウィザードまたは Azure AI Evaluation SDK で サポートされているエバリュエーター (生成品質、安全性、 カスタム エバリュエーターなど) を使用し、 Foundry ポータルを使用して結果を表示します。

シミュレーターと AI レッド チーミング エージェント: 評価データ (テスト データ) がない場合、シミュレーターはトピック関連または敵対的なクエリを生成することで役立ちます。 これらのシミュレーターは、状況に適したクエリまたは攻撃に似たクエリ (エッジ ケース) に対するモデルの応答をテストします。

- AI レッド チーミング エージェント は、Python リスク識別ツールまたは PyRIT 用の Microsoft のオープン フレームワークを使用して、広範な安全性とセキュリティ攻撃を使用して、AI システムに対する複雑な敵対的攻撃をシミュレートします。

AI レッド チーミング エージェントを使用した自動スキャンでは、AI アプリケーションのリスクを体系的にテストすることで、運用前のリスク評価が強化されます。 このプロセスには、実際のデプロイ前のモデル応答の弱点を特定するための、シミュレートされた攻撃シナリオが含まれます。 AI レッド チーミング スキャンを実行することで、デプロイ前に潜在的な安全性の問題を検出して軽減できます。 このツールは、リスクの特定を促進し、人間の専門家による評価を支援するために、従来の AI レッド チーミングプローブなどの人間のループ内プロセスで使用することをお勧めします。

または、 Foundry ポータルを 使用して、生成型 AI アプリケーションをテストすることもできます。

満足できる結果が得られると、AI アプリケーションを運用環境にデプロイできます。

運用後の監視

デプロイ後、継続的な監視により、AI アプリケーションは実際の状況で品質を維持できます。

デプロイ後、 継続的な監視 により、AI アプリケーションは実際の状況で品質を維持できます。

- 運用メトリック: 主要な AI エージェントの運用メトリックの定期的な測定。

- 継続的な評価: サンプリングレートで生産トラフィックの品質と安全性を評価できます。

- スケジュールされた評価: テスト データセットを使用してスケジュールされた品質と安全性の評価を有効にして、基になるシステムの誤差を検出します。

- スケジュールされたレッド チーミング: 安全とセキュリティの脆弱性を調査するためのスケジュールされた敵対的テスト機能を提供します。

- Azure Monitor アラート: 有害または不適切な出力が発生した場合の迅速なアクション。 運用環境で評価結果が合格率のしきい値を下回ったときに通知されるように、継続的な評価のアラートを設定します。

効果的な監視は、ユーザーの信頼を維持し、迅速な問題解決を可能にします。

監視機能は、今日の複雑で急速に進化する AI ランドスケープに不可欠な包括的な監視機能を提供します。 Azure Monitor Application Insights とシームレスに統合されたこのソリューションにより、デプロイされた AI アプリケーションを継続的に監視して、運用環境で最適なパフォーマンス、安全性、品質を確保できます。

Foundry Observability ダッシュボードは、重要なメトリックに関するリアルタイムの分析情報を提供します。 これにより、チームはパフォーマンスの問題、安全性の懸念、品質の低下をすばやく特定して対処できます。

エージェント ベースのアプリケーションの場合、Foundry では継続的な評価機能が強化されています。 これらの機能により、品質と安全性のメトリックをより深く可視化できます。 高いパフォーマンスと信頼性を維持しながら、AI アプリケーションの動的な性質に適応する堅牢な監視エコシステムを作成できます。

運用環境で AI アプリケーションの動作を継続的に監視することで、高品質のユーザー エクスペリエンスを維持し、発生する問題に迅速に対処できます。

体系的な評価による信頼の構築

GenAIOps は、ライフサイクル全体を通して AI アプリケーションを管理するための信頼性の高いプロセスを確立します。 モデルの選択からデプロイまで、各段階で徹底的な評価を実装することで、チームは強力で信頼できる安全な AI ソリューションを作成できます。

評価のクイック ガイド

| 目的 | プロセス | パラメーター |

|---|---|---|

| 何について評価しますか? | 関連するエバリュエータを特定または構築する |

-

品質とパフォーマンスのサンプル ノートブック - エージェントの応答品質 - 安全とセキュリティ (安全とセキュリティのサンプル ノートブック) - カスタム (カスタム サンプル ノートブック) |

| どのようなデータを使用する必要がありますか? | 関連するデータセットをアップロードまたは生成する |

-

品質とパフォーマンスを測定するための汎用シミュレーター (汎用シミュレーターサンプル ノートブック) - 安全性とセキュリティを測定するための 敵対シミュレーター (敵対シミュレーターサンプル ノートブック) - 安全性とセキュリティの脆弱性を評価する自動スキャンを実行するための AI レッド チーミング エージェント (AI レッド チーミング エージェントサンプル ノートブック) |

| データセットで評価を実行する方法 | 評価の実行 |

-

エージェント評価の実行 - リモート クラウド実行 - ローカル実行 |

| モデルまたはアプリのパフォーマンスはどうでしたか? | 分析結果 | - 集計スコアの表示、詳細の確認、スコア詳細、評価実行の比較 |

| どのように改善できますか? | モデル、アプリ、またはエバリュエータに変更を加える | - 評価結果が人間のフィードバックに合わない場合は、エバリュエータを調整します。 - 評価結果が人間のフィードバックに合っていたが、品質または安全性のしきい値を満たしていない場合は、対象を絞った軽減策を適用します。 適用する軽減策の例: Azure AI Content Safety |

| 目的 | プロセス | パラメーター |

|---|---|---|

| 何について評価しますか? | 関連するエバリュエータを特定または構築する |

-

RAG 品質 - エージェントの品質 - 安全とセキュリティ (安全とセキュリティのサンプル ノートブック) - カスタム (カスタム サンプル ノートブック) |

| どのようなデータを使用する必要がありますか? | 関連するデータセットをアップロードまたは生成する |

-

合成データセットの生成 - 安全性とセキュリティの脆弱性を評価する自動スキャンを実行するための AI レッド チーミング エージェント (AI レッド チーミング エージェントサンプル ノートブック) |

| データセットで評価を実行する方法 | 評価の実行 |

-

エージェント評価の実行 - リモート クラウド実行 |

| モデルまたはアプリのパフォーマンスはどうでしたか? | 分析結果 | - 集計スコアの表示、詳細の確認、スコア詳細、評価実行の比較 |

| どのように改善できますか? | モデル、アプリ、またはエバリュエータに変更を加える | - 評価結果が人間のフィードバックに合わない場合は、エバリュエータを調整します。 - 評価結果が人間のフィードバックに合っていたが、品質または安全性のしきい値を満たしていない場合は、対象を絞った軽減策を適用します。 適用する軽減策の例: Azure AI Content Safety |

評価用に独自の仮想ネットワークを使用する

ネットワークの分離を目的として、評価のために独自の仮想ネットワークを使用できます。 詳細については、「 プライベート リンクを構成する方法」を参照してください。

注

Application Insights が接続されている場合、評価データは Application Insights に送信されます。 Application Insights の Virtual Network サポートはまだ利用できませんが、近いうちに利用可能になります。

仮想ネットワーク リージョンのサポート

| 地理学 | サポートされている Azure リージョン |

|---|---|

| アメリカ | westus、westus3、eastus、eastus2 |

| オーストラリア | オーストラリアイースト |

| フランス | francecentral |

| インド | 南インド |

| 日本 | japaneast |

| ノルウェイ | ノルウェーイースト |

| スウェーデン | swedencentral |

| スイス | スイスノース |

| アラブ首長国連邦 | uaenorth |

| 英国 | ウクサウス |

リージョンのサポート

現在、特定の AI 支援エバリュエータは、次のリージョンでのみ使用できます。

| リージョン | 憎しみと不公平、性的、暴力、自傷行為、間接攻撃、コードの脆弱性、根拠のない属性 | グラウンデッドネス プロ | 保護材料 |

|---|---|---|---|

| 米国東部 2 | サポートされています | サポートされています | サポートされています |

| スウェーデン中部 | サポートされています | サポートされています | なし |

| 米国中北部 | サポートされています | なし | なし |

| フランス中部 | サポートされています | なし | なし |

| スイス西部 | サポートされています | なし | なし |

エージェントプレイグラウンドの評価リージョンに対するサポート

| リージョン | ステータス |

|---|---|

| 米国東部 | サポートされています |

| 米国東部 2 | サポートされています |

| 米国西部 | サポートされています |

| 米国西部 2 | サポートされています |

| 米国西部 3 | サポートされています |

| フランス中部 | サポートされています |

| ノルウェー東部 | サポートされています |

| スウェーデン中部 | サポートされています |

価格設定

リスクと安全性の評価や継続的評価などの監視機能は、 Azure の価格ページに記載されている使用量に基づいて課金されます。