Azure AI Foundry に既に AI プロジェクトがある場合、モデルカタログは、既定でサードパーティ モデル プロバイダーのモデルをスタンドアロン エンドポイントとしてプロジェクトにデプロイします。 各モデル デプロイには、それにアクセスするための独自の URI と資格情報のセットがあります。 一方、Azure OpenAI モデルは、Azure AI Services リソースまたは Azure AI Foundry Models リソースの Azure OpenAI にデプロイされます。

この動作を変更し、両方の種類のモデルを Azure AI Foundry Services (旧称 Azure AI Services) にデプロイできます。 構成が完了すると、 サーバーレス API デプロイとしてのモデルのデプロイは、接続されている Azure AI Services リソース ではなくプロジェクト自体に対して行われ、Azure AI Foundry にデプロイされているすべてのモデルにアクセスするためのエンドポイントと資格情報のセットが 1 つ与えられます。 Azure OpenAI とサード パーティのモデル プロバイダーのモデルを、同じ方法で管理できます。

さらに、Azure AI Foundry Models にモデルをデプロイすると、次のような利点があります。

- ルーティング機能。

- カスタム コンテンツ フィルター。

- グローバルな容量のデプロイの種類。

- ロールベースのアクセス制御によるキーレス認証。

この記事では、Foundry Models デプロイを使用するようにプロジェクトを構成する方法について説明します。

[前提条件]

このチュートリアルを完了するには、次のものが必要です。

Azure サブスクリプション。 GitHub モデルを使用している場合は、エクスペリエンスをアップグレードし、プロセスで Azure サブスクリプションを作成できます。 お客様の場合は、 GitHub モデルから Foundry モデルへのアップグレード をお読みください。

Azure AI サービス リソース。 詳細については、「Azure AI サービス リソースを作成する」を参照してください。

Azure AI プロジェクトと Azure AI ハブ。

ヒント

AI ハブがプロビジョニングされると、それとともに Azure AI サービス リソースが作成され、それら 2 つのリソースは接続されます。 プロジェクトに接続されている Azure AI サービス リソースを確認するには、Azure AI Foundry ポータル>[管理センター]>[接続されたリソース] に移動して、[AI サービス] の種類の接続を見つけてください。

Foundry モデルを使用するようにプロジェクトを構成する

Azure AI Foundry Services で Foundry Models 機能を使用するようにプロジェクトを構成するには、次の手順に従います。

Azure AI Foundry ポータルに移動します。

上部のナビゲーション バーで、右上隅にあるプレビュー機能アイコンを選択します。 画面の右側にコンテキスト ブレードが表示されます。

Azure AI モデル推論サービスへのモデルのデプロイ機能を有効にします。

そのパネルを閉じます。

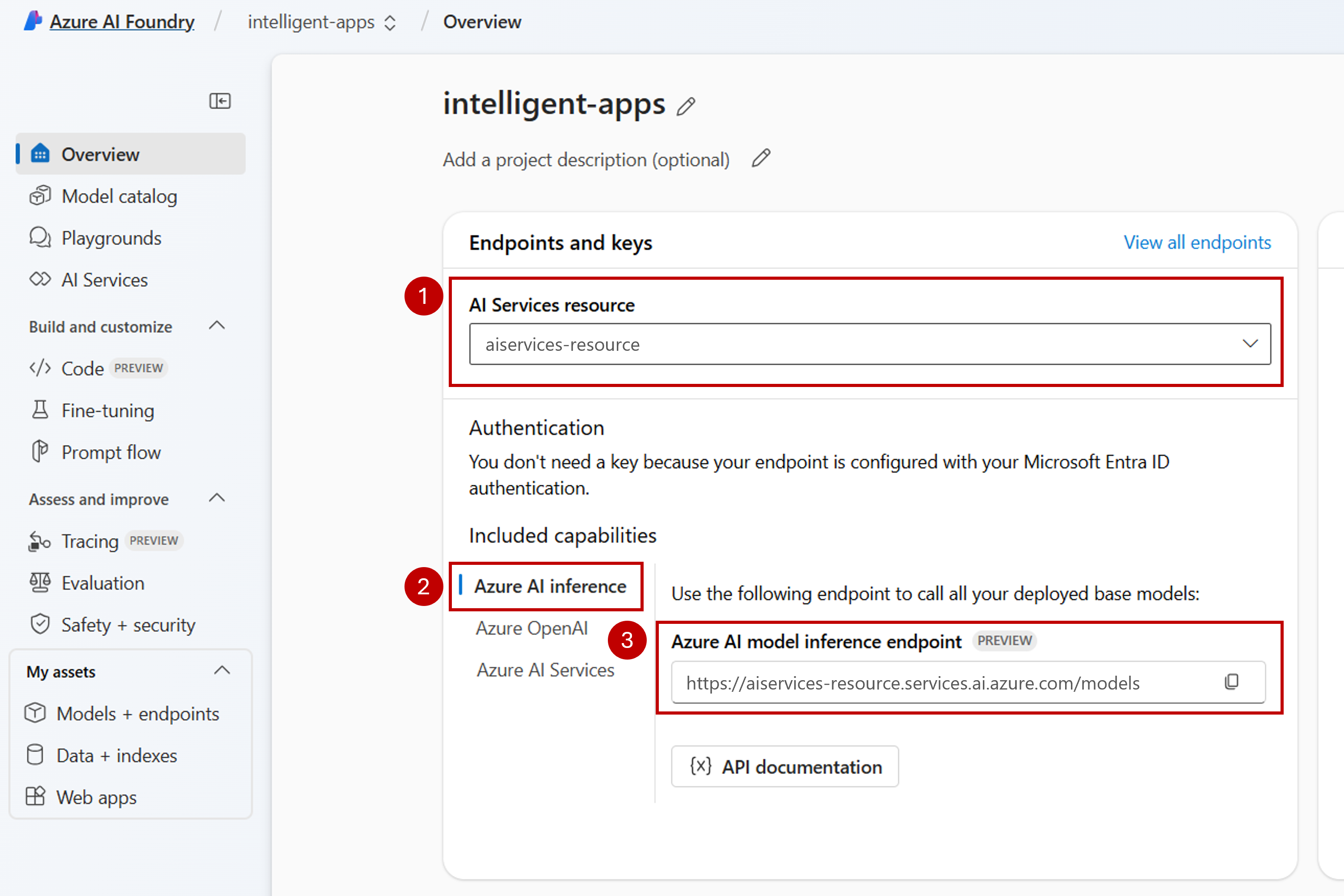

プロジェクトのランディング ページ内で、プロジェクトに接続されている Azure AI サービス リソースを特定します。 必要に応じて、ドロップダウンを使用して接続されているリソースを変更します。

ドロップダウンの中にリソースが一覧表示されていない場合は、AI ハブに Azure AI サービス リソースが接続されていません。 新しい接続を次のように作成します。

画面の左下隅にある [管理センター] を選択します。

[接続] セクション内で [新しい接続] を選択します。

[Azure AI サービス] を選択します。

ブラウザーで、サブスクリプション内の既存 Azure AI サービス リソースを探します。

[接続の追加] を選択します。

新しい接続がハブに追加されます。

プロジェクトのランディング ページに戻って続行し、ここで新しく作成された接続を選択します。 ページがすぐに表示されない場合は更新してください。

[含まれる機能] の下で、確実に [Azure AI 推論] を選択してください。 Foundry Models エンドポイント URI が、アクセスするための資格情報と共に表示されます。

ヒント

各 Azure AI Foundry Services リソースには、その上の任意のモデル デプロイにアクセスするために使用できる単一 の Foundry Models エンドポイント があります。 同じエンドポイントが、構成されているものに応じて複数のモデルに対応します。 エンドポイントのしくみを確認してください。

エンドポイントの URL と資格情報をメモしてください。

Foundry Models でモデルデプロイを作成する

Foundry Models の下にデプロイするモデルごとに、次の手順に従います。

Azure AI Foundry ポータル内の [モデルカタログ] セクションに移動します。

関心のあるモデルまでスクロールして選択します。

モデル カードでモデルの詳細を確認できます。

[デプロイ] を選択します。

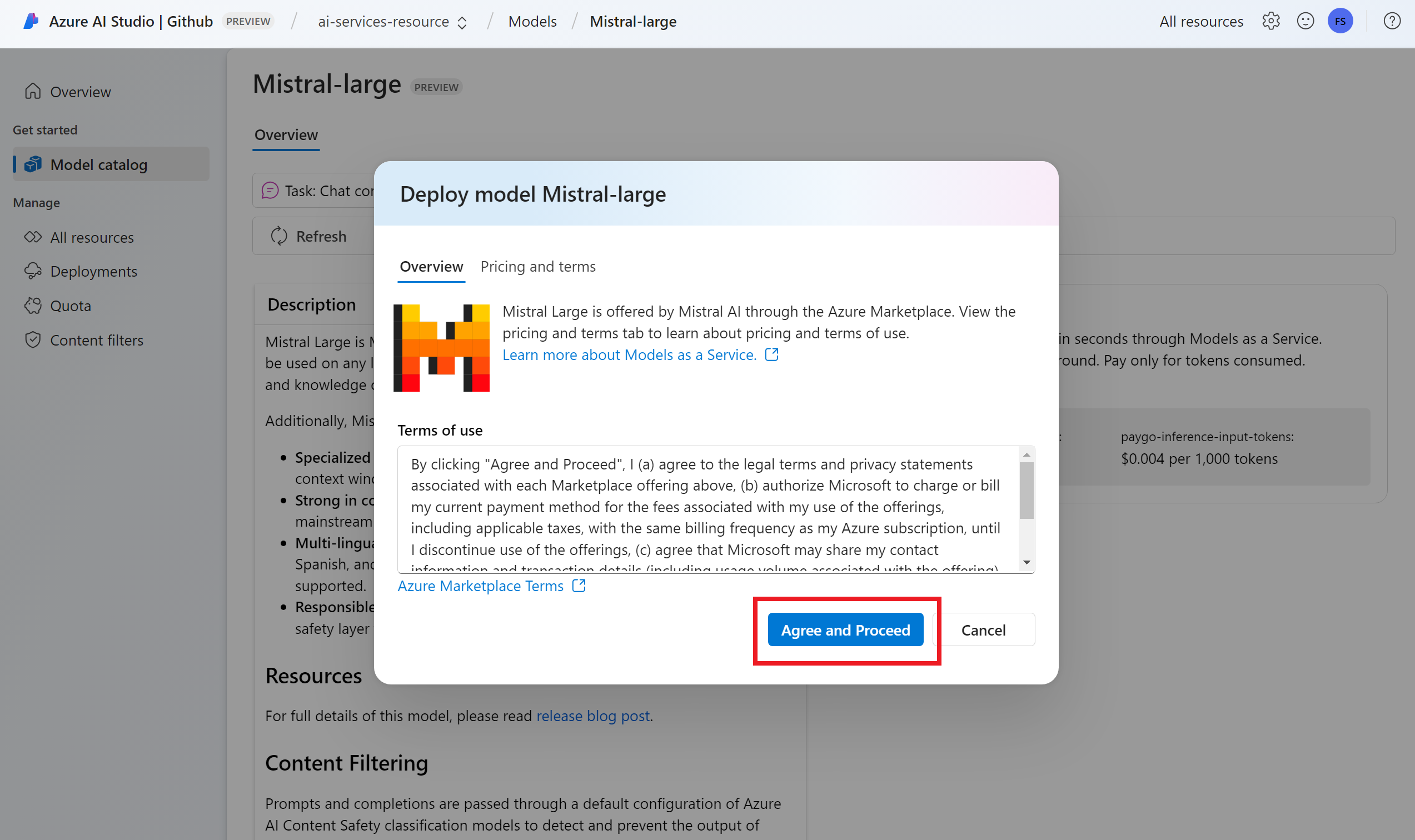

追加の契約条件が必要なモデル プロバイダーの場合は、それらの条件に同意するように求められます。 [サブスクリプションとデプロイ] を選択して、これらのケースの使用条件に同意します。

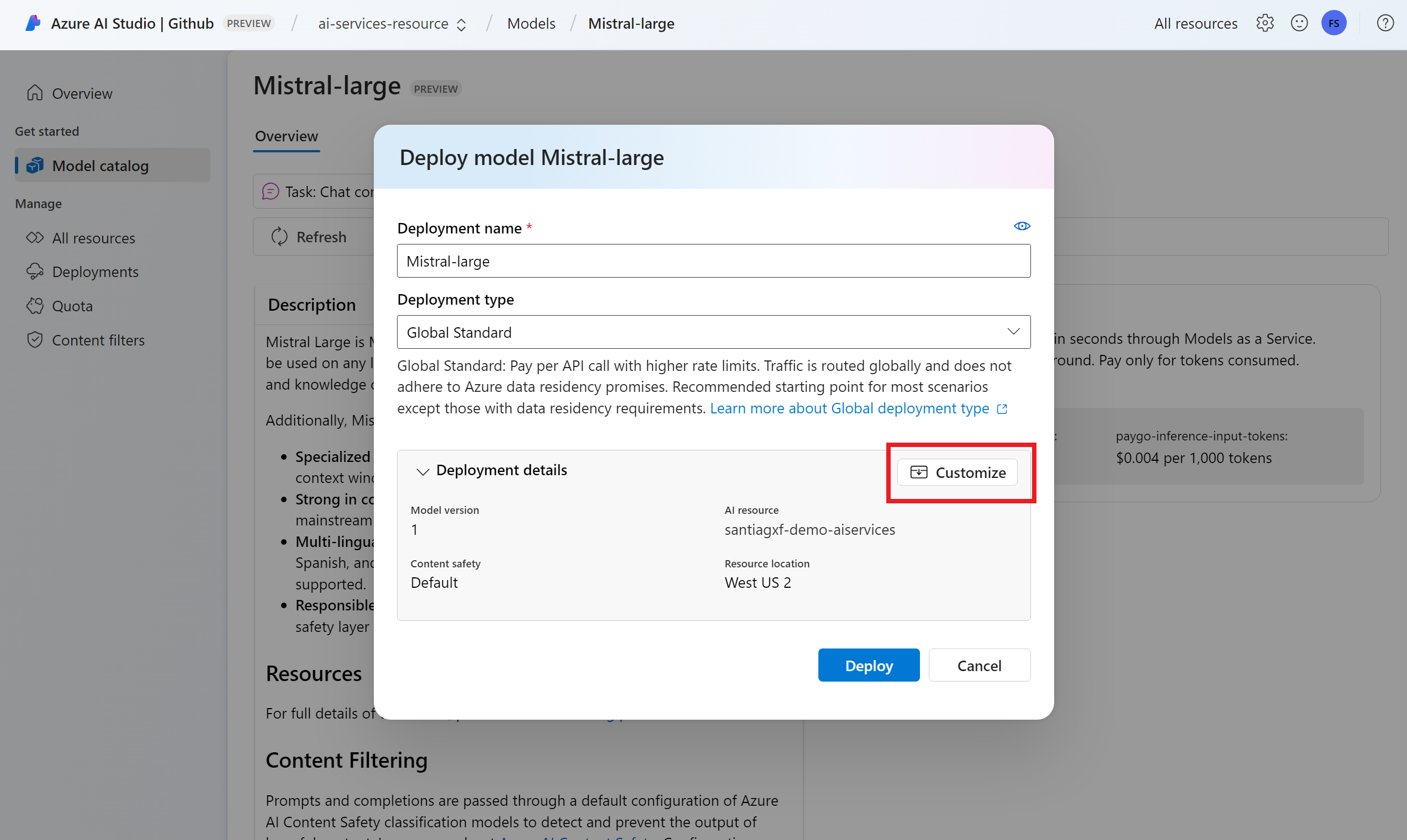

この時点でデプロイ設定を構成できます。 既定では、デプロイはデプロイするモデルの名前を受け取ります。 デプロイ名は、この特定のモデル デプロイにルーティングする要求の

modelパラメーターで使用されます。 これにより、特定の構成をアタッチする際に、モデルに特定の名前を構成できます。 たとえば、厳密なコンテンツフィルターを使用するモデルの場合、o1-preview-safe。[Azure AI モデル推論サービスにモデルをデプロイする] の機能を有効にしたため、プロジェクトに応じて Azure AI サービス接続が自動的に選択されます。 [カスタマイズ] オプションを使用し、ニーズに基づいて接続を変更します。 サーバーレス API デプロイの種類でデプロイする場合は、Azure AI Services リソースのリージョンでモデルを使用できる必要があります。

[デプロイ] を選択します。

デプロイが完了すると、そのモデルにアクセスするためのエンドポイント URL と資格情報が表示されます。 これで、指定された URL と資格情報が Foundry Models エンドポイントのプロジェクトのランディング ページに表示されるのと同じになります。

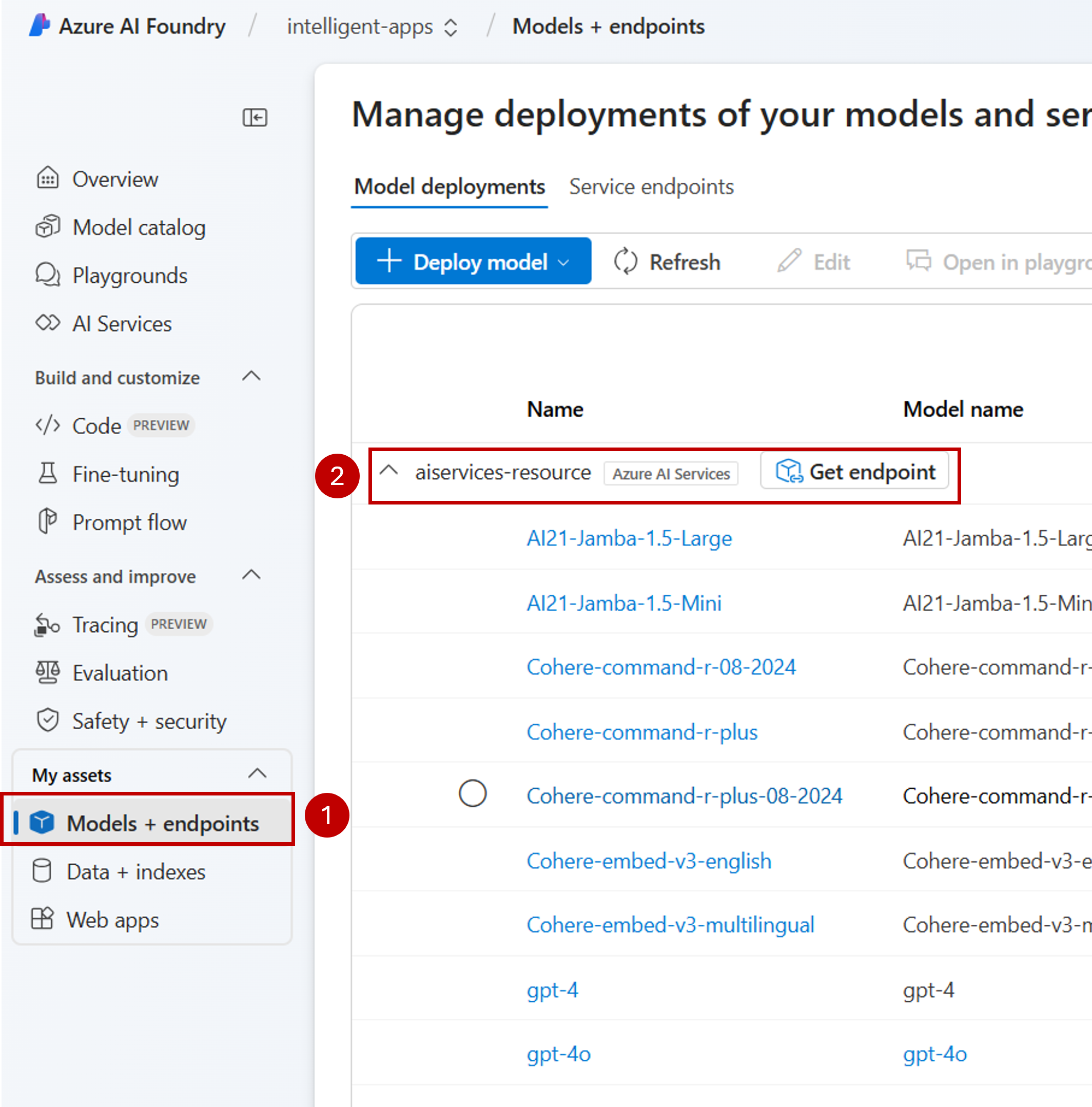

[モデル + エンドポイント] セクションに移動し、AI サービス リソースへの接続のグループを見つけると、そのリソースのもとで使用可能なすべてのモデルを表示できます。

新しいエンドポイントを使用してコードをアップグレードする

Azure AI サービス リソースが構成されたら、コードからそのリソースの使用を開始できます。 エンドポイント URL とそのキーが必要です。これは、[概要] セクションで確認できます。

サポートされている SDK のいずれかを使用して、エンドポイントから予測を取得できます。 次の SDK が正式にサポートされています。

- OpenAI SDK

- Azure OpenAI SDK

- Azure AI 推論パッケージ

- Azure AI Projects パッケージ

詳細と例については、サポートされている言語と SDK のセクションを参照してください。 次の例は、新しくデプロイされたモデルで Azure AI 推論パッケージを使用する方法を示しています。

pip のように、パッケージ マネージャーを使用してパッケージ azure-ai-inference をインストールします。

pip install azure-ai-inference

その後、パッケージを使用してモデルを使用できます。 次の例では、チャット入力候補を使用してクライアントを作成する方法を示します。

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

client = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZURE_INFERENCE_CREDENTIAL"]),

)

サンプルを確認し、API リファレンス ドキュメントを参照して、作業を開始してください。

最初のチャット入力候補を生成します。

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

パラメーター model="<deployment-name> を使用して、要求をこのデプロイにルーティングします。 デプロイは、特定の構成下で特定のモデルのエイリアスとして機能します。 Azure AI Foundry Models がデプロイをルーティングする方法については、「 ルーティング 」ページを参照してください。

サーバーレス API デプロイから Foundry モデルへの移行

Foundry Models を使用するようにプロジェクトを構成しましたが、既存のモデルデプロイはサーバーレス API デプロイとしてプロジェクト内に引き続き存在します。 それらのデプロイは移動されません。 そのため、以前のモデル デプロイを参照する既存コードを、段階的にアップグレードすることができます。 モデル デプロイの移行を開始するには、次のワークフローをお勧めします。

Foundry Models でモデルのデプロイを再作成します。 このモデル デプロイには、 Foundry Models エンドポイントでアクセスできます。

新しいエンドポイントを使用するようにコードをアップグレードします。

サーバーレス API デプロイを削除して、プロジェクトをクリーンアップします。

新しいエンドポイントを使用してコードをアップグレードする

モデルが Azure AI Foundry Services にデプロイされたら、Foundry Models エンドポイントを使用するようにコードをアップグレードできます。 サーバーレス API デプロイと Foundry Models のしくみの主な違いは、エンドポイント URL とモデル パラメーターにあります。 サーバーレス API デプロイには、各モデル のデプロイごとに URI とキーのセットが用意されていますが、Foundry Models には、それらすべてに対して 1 つだけがあります。

次の表は、導入する必要がある変更をまとめたものです。

| プロパティ | サーバーレス API のデプロイ | 鋳造所モデル |

|---|---|---|

| エンドポイント | https://<endpoint-name>.<region>.inference.ai.azure.com |

https://<ai-resource>.services.ai.azure.com/models |

| 資格情報 | モデル/エンドポイントごとに 1 つ。 | Azure AI サービス リソースごとに 1 つ。 Microsoft Entra ID も使用できます。 |

| モデル パラメーター | なし。 | 必須。 モデル デプロイの名前を使用します。 |

プロジェクトから既存のサーバーレス API デプロイをクリーンアップする

コードをリファクタリングした後、プロジェクト内の既存のサーバーレス API デプロイ (存在する場合) を削除できます。

サーバーレス API デプロイとしてデプロイされたモデルごとに、次の手順に従います。

Azure AI Foundry ポータルに移動します。

[モデル + エンドポイント] を選択します。

サーバーレス API デプロイの種類のエンドポイントを特定し、削除するエンドポイントを選択します。

[削除] オプションを選択します。

Warnung

この操作を元に戻すことはできません。 そのエンドポイントが現在、他のユーザーまたはコードの一部によって使用されていないことを確認してください。

[削除] を選択して操作を確認します。

他のプロジェクトからこのエンドポイントへの サーバーレス API デプロイ接続 を作成した場合、そのような接続は削除されず、既存のエンドポイントを指し続けます。 エラーを回避するために、それらの接続をすべて削除してください。

制限事項

Foundry モデルを使用するようにプロジェクトを構成する場合は、次の制限事項を考慮してください。

- Foundry Models へのデプロイには、サーバーレス API デプロイをサポートするモデルのみを使用できます。 カスタム モデルを含め、サブスクリプション (マネージド コンピューティング) からのコンピューティング クォータを必要とするモデルは、指定されたプロジェクト内でのみマネージド オンライン エンドポイントとしてデプロイでき、独自のエンドポイント URI と資格情報のセットを使用して引き続きアクセスできます。

- サーバーレス API デプロイとマネージド コンピューティング オファリングの両方として使用できるモデルは、既定では Azure AI Foundry Services リソースの Foundry Models にデプロイされます。 Azure AI Foundry ポータルには、マネージド オンライン エンドポイントにデプロイする方法はありません。 「 Foundry Models を使用するようにプロジェクトを構成 する」で説明されている機能をオフにするか、Azure CLI/Azure ML SDK/ARM テンプレートを使用してデプロイを実行する必要があります。

次のステップ

- エンドポイントにさらにモデルを追加します。

![Azure AI Foundry ポータルにおいて [Azure AI モデル推論サービスにモデルをデプロイする] 機能を有効にする方法を示すアニメーション。](../media/quickstart-ai-project/ai-project-inference-endpoint.gif)