Azure AI Foundry Models は、カスタム の副操縦士の構築、エージェントの構築、既存のアプリケーションの強化、新しい AI 機能の探索など、強力な AI モデルを検出、評価、デプロイするためのワンストップの場所です。

Foundry モデルを使用すると、次のことができます。

- Microsoft、OpenAI、DeepSeek、Hugging Face、Meta などの最先端モデルの豊富なカタログをご覧ください。

- 実際のタスクと独自のデータを使用して、モデルを並べて比較および評価します。

- 微調整、可観測性、責任ある AI 用の組み込みツールにより、自信を持ってデプロイできます。

- 独自のモデルを導入するか、ホストされているモデルを使用するか、Azure サービスとシームレスに統合するか、パスを選択します。

- Foundry Models は、開発者、データ サイエンティスト、エンタープライズ アーキテクトのいずれであっても、安全かつ責任を持って迅速にスケーリングする AI ソリューションを構築するための柔軟性と制御を提供します。

Azure AI Foundry には、AI モデルの包括的なカタログが用意されています。 基盤モデル、推論モデル、小言語モデル、マルチモーダルモデル、ドメイン固有モデル、業界標準など、1900以上のモデルがあります。

カタログは、次の 2 つの主要なカテゴリに分類されています。

これらのカテゴリの違いを理解することは、特定の要件と戦略的目標に基づいて適切なモデルを選択するのに役立ちます。

Azure によって直接販売されるモデル

これらは、Microsoft 製品使用条件に基づき Microsoft によってホストおよび販売されるモデルです。 これらのモデルは厳格な評価を受け、Azure の AI エコシステムに深く統合されています。 モデルはさまざまなトップ プロバイダーから提供されており、強化された統合、最適化されたパフォーマンス、エンタープライズ レベルのサービス レベル アグリーメント (SLA) を含む Microsoft の直接サポートを提供します。

これらの直接モデルの特性:

- Microsoft からの公式ファースト パーティ サポート

- Azure サービスとインフラストラクチャとの高度な統合

- 広範なパフォーマンス ベンチマークと検証

- Microsoft の責任ある AI 標準への準拠

- エンタープライズ レベルのスケーラビリティ、信頼性、およびセキュリティ

これらのモデルには、代替可能なプロビジョニングスループットの利点もあります。つまり、これらのモデルのいずれかでクォータと予約を柔軟に使用できます。

パートナーとコミュニティのモデル

これらのモデルは、Azure AI Foundry モデルの大部分を構成します。 これらのモデルは、信頼できるサード パーティの組織、パートナー、リサーチ ラボ、コミュニティ共同作成者によって提供されます。 これらのモデルは、さまざまなシナリオ、業界、イノベーションをカバーする、特殊で多様な AI 機能を提供します。

パートナーとコミュニティのモデルの特性:

- 外部パートナーおよびコミュニティ共同作成者によって開発およびサポートされている

- ニッチまたは広範なユース ケースに対応するさまざまな特殊なモデル

- 通常、Azure によって提供される統合ガイドラインを使用して、プロバイダー自体によって検証されます

- コミュニティ主導のイノベーションと最先端モデルの迅速な可用性

- それぞれのプロバイダーによって管理されるサポートとメンテナンスを備えた標準の Azure AI 統合

モデルは、マネージド コンピューティングまたは Standard (従量課金制) デプロイ オプションとしてデプロイできます。 モデル プロバイダーは、モデルのデプロイ方法を選択します。

直接モデルとパートナーモデルとコミュニティモデルの選択

Azure AI Foundry モデルからモデルを選択する場合は、次の点を考慮してください。

- ユース ケースと要件: Azure によって直接販売されるモデルは、Azure の深い統合、保証されたサポート、エンタープライズ SLA を必要とするシナリオに最適です。 Azure エコシステム モデルは、特殊なユース ケースとイノベーション主導のシナリオに優れています。

- サポートの期待: Azure によって直接販売されるモデルには、Microsoft が提供する堅牢なサポートとメンテナンスが付属しています。 これらのモデルは、さまざまなレベルの SLA とサポート構造で、プロバイダーによってサポートされています。

- イノベーションと特殊化: パートナーとコミュニティのモデルは、一流の研究所や新しい AI プロバイダーによって開発されることが多い特殊なイノベーションとニッチ機能に迅速にアクセスできます。

モデル コレクション

モデル カタログでは、モデルがさまざまなコレクションに編成されています。

Azure で排他的に利用できる Azure OpenAI モデル: Azure AI Foundry モデルの Azure OpenAI との統合を通じて利用できるフラグシップ Azure OpenAI モデル。 Microsoft では、Azure AI Foundry モデルの Azure OpenAI の製品条件と SLA に従って、これらのモデルとその使用をサポートしています。

Hugging Face ハブのオープン モデル: マネージド コンピューティングによるリアルタイム推論のための Hugging Face ハブの数百のモデル。 Hugging Face は、このコレクションに掲載されているモデルを作成および維持しています。 サポートが必要な場合は、Hugging Face フォーラムまたは Hugging Face サポートを利用してください。 詳細については、Azure AI Foundry を使用したオープン モデルのデプロイに関するページを参照してください。

このフォームを使用して、モデルカタログにモデルを追加する要求を送信できます。

モデル カタログ機能の概要

Azure AI Foundry ポータルのモデルカタログは、生成 AI アプリケーションを構築するための幅広いモデルを検索して使用するためのハブです。 モデル カタログには、Microsoft がトレーニングしたモデルを含め、Azure OpenAI、Mistral、Meta、Cohere、NVIDIA、Hugging Face などのモデル プロバイダー間で数百のモデルが用意されています。 Microsoft 以外のプロバイダーのモデルは、Microsoft 製品使用条件で定義されている、Microsoft 以外の製品であり、モデルに付属される条件に従います。

キーワード検索とフィルターを使用して、ニーズを満たすモデルを検索および検出できます。 モデル カタログには、選択したモデルのモデル パフォーマンス ランキングとベンチマーク メトリックも用意されています。 [ ランキングの参照 ] と [ モデルの比較] を選択してアクセスできます。 ベンチマーク データには、モデル カードの [ベンチマーク] タブからもアクセスできます。

モデル カタログ フィルターでは、次の情報が表示されます。

- コレクション: モデル プロバイダー コレクションに基づいてモデルをフィルター処理できます。

- 業界: 業界固有のデータセットでトレーニングされたモデルをフィルター処理できます。

- 機能: 推論やツールの呼び出しなど、一意のモデル機能をフィルター処理できます。

- デプロイ オプション: 特定のデプロイ オプションをサポートするモデルをフィルター処理できます。

- Standard: このオプションを使用すると、API 呼び出しごとに支払うことができます。

- プロビジョニング済み: 大きくて一貫性のあるボリュームのリアルタイム スコアリングに最適です。

- Batch: レイテンシではなく、コスト最適化されたバッチジョブに最適です。 バッチデプロイでは、プレイグラウンドのサポートは提供されません。

- マネージド コンピューティング: このオプションを使用すると、Azure 仮想マシンにモデルをデプロイできます。 ホスティングと推論処理に対して課金されます。

- 推論タスク: 推論タスクの種類に基づいてモデルをフィルター処理できます。

- タスクの微調整: 微調整タスクの種類に基づいてモデルをフィルター処理できます。

- ライセンス: ライセンスの種類に基づいてモデルをフィルター処理できます。

モデル カードには、次が表示されます。

- 簡単な事実: モデルに関する重要な情報が一目でわかります。

- 詳細: このページには、説明、バージョン情報、サポートされているデータ型など、モデルに関する詳細情報が含まれています。

- ベンチマーク: 選択したモデルのパフォーマンス ベンチマーク メトリックが表示されます。

- 既存のデプロイ: モデルを既にデプロイしている場合は、[既存のデプロイ] タブで見つけることができます。

- ライセンス: モデル ライセンスに関連する法的情報が表示されます。

- 成果物: このタブは、開いているモデルに対してのみ表示されます。 モデル資産を表示し、ユーザー インターフェイスを使用してダウンロードできます。

モデルデプロイ: マネージド コンピューティングと標準デプロイ

モデル カタログには、Azure OpenAI モデルに加えて、使用するモデルをデプロイするための 2 つの異なる方法 (マネージド コンピューティングと標準デプロイ) が用意されています。

次の表に示すように、モデルごとに使用できるデプロイ オプションと機能は異なります。 デプロイ オプションを使用したデータ処理の詳細を確認してください。

モデル デプロイ オプションの機能

| 特徴 | マネージド コンピューティング | Standard デプロイ |

|---|---|---|

| デプロイ エクスペリエンスと課金 | モデルの重みは、マネージド コンピューティングを備えた専用の仮想マシンにデプロイされます。 マネージド コンピューティングは、1 つ以上のデプロイを持つことができ、推論に REST API が利用可能になります。 デプロイで使用される仮想マシンのコア時間に対して課金されます。 | モデルへのアクセスは、モデルにアクセスするための API をプロビジョニングするデプロイを通じて行われます。 この API は、推論のために Microsoft がホストおよび管理するモデルへのアクセスを提供します。 API への入力と出力に対して (通常はトークンで) 課金されます。 デプロイする前に価格情報が提供されます。 |

| API 認証 | キーと Microsoft Entra 認証。 | キーのみ。 |

| コンテンツの安全性 | Azure AI Content Safety サービス API を使用します。 | Azure AI Content Safety フィルターを、推論 API と統合して使用できます。 Azure AI Content Safety フィルターは、個別に課金されます。 |

| ネットワークの分離 | Azure AI Foundry ハブ用にマネージド ネットワークを構成します。 | マネージド コンピューティングは、使用しているハブの公衆ネットワーク アクセス (PNA) のフラグ設定に従います。 詳細については、この記事で後述する「 標準デプロイを使用してデプロイされるモデルのネットワーク分離 」セクションを参照してください。 |

サポートされているデプロイ オプションで使用可能なモデル

モデル カタログには、使用するためにカタログからモデルをデプロイする方法として、マネージド コンピューティングと標準デプロイの 2 つの異なる方法が用意されています。 モデルごとに使用可能なデプロイ オプションは異なります。デプロイ オプションの機能と、特定のモデルで使用できるオプションの詳細については、次の表を参照してください。 デプロイ オプションでのデータ処理の詳細をご確認ください。

| 特徴 | マネージド コンピューティング | Standard デプロイ |

|---|---|---|

| デプロイ エクスペリエンスと課金 | モデルの重みは、マネージド オンライン エンドポイントのある専用の Virtual Machines にデプロイされます。 マネージド オンライン エンドポイントは、1 つ以上のデプロイを持つことができ、推論に REST API を使用できます。 利用者は、デプロイに使用された仮想マシン コア時間に対して課金されます。 | モデルへのアクセスは、モデルにアクセスするための API をプロビジョニングするデプロイを通じて行われます。 この API は、推論のために Microsoft によって管理される中央 GPU プールでホストされているモデルへのアクセスを提供します。 このアクセス モードは、"サービスとしてのモデル" と呼ばれます。 利用者は、API への入力と出力 (通常はトークン数) に対して課金されます。この価格情報は、デプロイする前に提供されます。 |

| API 認証 | キーと Microsoft Entra ID 認証。 詳細を参照してください。 | キーのみ。 |

| コンテンツの安全性 | Azure Content Safety サービス API を使用します。 | Azure AI Content Safety フィルターを、推論 API と統合して使用できます。 Azure AI Content Safety フィルターは、個別に課金される場合があります。 |

| ネットワークの分離 | オンライン エンドポイントを使用したマネージド仮想ネットワーク。 詳細を参照してください。 |

マネージド コンピューティング

モデルをマネージド コンピューティングとしてデプロイする機能は、Azure Machine Learning のプラットフォーム機能に基づいて構築され、モデルカタログの幅広いモデル コレクションの GenAIOps (LLMOps とも呼ばれる) ライフサイクル全体においてシームレスな統合を実現します。

マネージド コンピューティングとしてデプロイするためのモデルの可用性

モデルは、Azure Machine Learning レジストリを介して利用可能にできます。これは、機械学習資産のホスティングおよび配布のための ML ファーストの方法を有効にするためのものであり、このような資産には、モデルの重み付け、モデルを実行するためのコンテナー ランタイム、ベンチマークとサンプルのモデルとデータセットを評価および微調整するためのパイプラインなどがあります。 これらの ML レジストリは、高度にスケーラブルでエンタープライズ対応のインフラストラクチャの上に構築されます。

geo レプリケーションが組み込まれているすべての Azure リージョンに、待機時間の短いアクセス モデル成果物を提供します。

Azure Policy を使用したモデルへのアクセス制限およびマネージド仮想ネットワークを使用したデプロイのセキュリティ保護として、エンタープライズ セキュリティ要件をサポートします。

マネージド コンピューティングを使用した推論用モデルのデプロイ

マネージド コンピューティングでのデプロイに使用できるモデルは、リアルタイム推論のために Azure Machine Learning のオンライン エンドポイントにデプロイすることも、Azure Machine Learning のバッチ推論でデータをバッチ処理するために使用することもできます。 マネージド コンピューティングにデプロイするには、モデルの最適な実行に必要な特定の SKU のための仮想マシン クォータが Azure サブスクリプションに必要です。 一部のモデルでは、モデルをテストするための一時的な共有クォータへのデプロイが可能です。 モデルのデプロイの詳細については、次を参照してください。

マネージド コンピューティングを使用した生成 AI アプリの構築

プロンプト フローには、AI アプリケーションのプロトタイプ作成、実験、反復処理、デプロイのための機能が用意されています。 プロンプト フローでマネージド コンピューティングでデプロイされたモデルは Open Model LLM ツールで使用できます。 また、Azure Machine Learning 拡張機能を使用して、LangChain などの一般的な LLM ツールでマネージド コンピューティングによって公開される REST API を使用することもできます。

マネージド コンピューティングとしてデプロイされたモデルのコンテンツの安全性

Azure AI Content Safety (AACS) サービスは、マネージド コンピューティングででプロしたモデルで使用し、性的コンテンツ、暴力、ヘイト、自傷行為、高度な脅威 (脱獄リスク検出や保護済み素材テキスト検出など) などのさまざまなカテゴリの有害なコンテンツをスクリーニングするために利用できます。 このノートブックを参照して、AACS for Llama 2 とのリファレンス統合を参照するか、プロンプト フローでの Content Safety (テキスト) ツールを使用して、モデルから AACS に応答を渡してスクリーニングを行えます。 このような使用については、AACS の価格に従って個別に課金されます。

Standard 請求を使用した標準の展開

モデル カタログ内の特定のモデルは、Standard 課金を使用して標準デプロイとしてデプロイできます。このデプロイ方法は、標準デプロイと呼ばれます。 MaaS を介して使用できるモデルは、Microsoft によって管理されるインフラストラクチャでホストされます。これにより、モデル プロバイダーのモデルへの API ベースのアクセスが可能になります。 API ベースのアクセスにより、モデルへのアクセス コストが大幅に削減され、プロビジョニング エクスペリエンスは大変、シンプルなものになります。 ほとんどの MaaS モデルは、トークンベースの価格で使用できます。

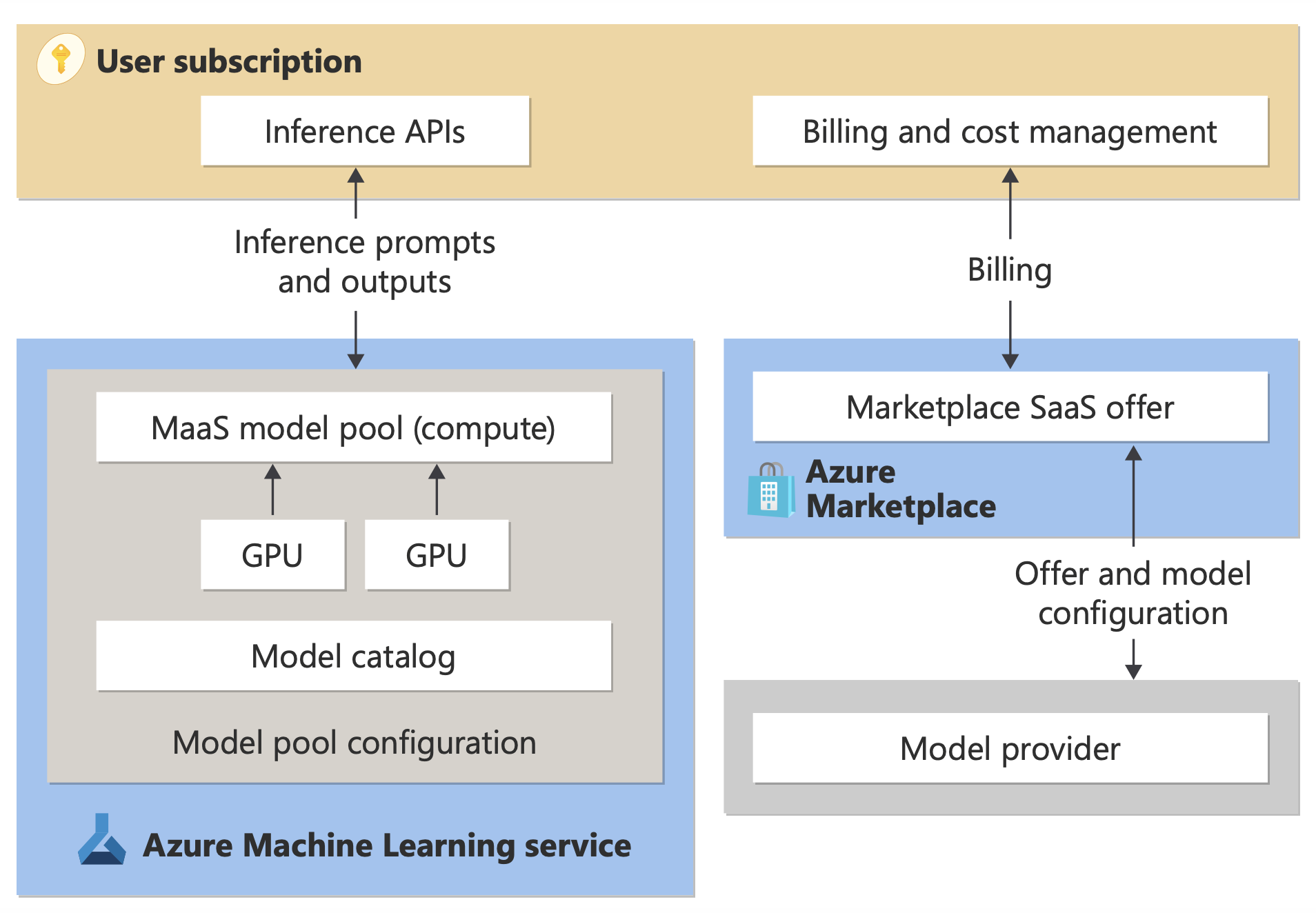

MaaS でサード パーティ製モデルを利用可能にする方法

Standard 課金による標準デプロイとしてデプロイに使用できるモデルは、モデル プロバイダーによって提供されますが、Microsoft が管理する Azure インフラストラクチャでホストされ、API 経由でアクセスされます。 モデル プロバイダーがライセンス条項を定義し、モデルの使用価格を設定する一方、Azure Machine Learning service はホスティング インフラストラクチャを管理し、推論 API を使用できるようにします。また、MaaS 経由でデプロイされたモデルによって送信されるプロンプトとコンテンツ出力のデータ プロセッサとして機能します。 MaaS のデータ処理の詳細については、データのプライバシーに関する記事を参照してください。

注

クラウド ソリューション プロバイダー (CSP) サブスクリプションには、標準のデプロイ モデルを購入する機能がありません。

請求書

MaaS を使用してデプロイされたモデルの検索、サブスクリプション、使用エクスペリエンスは、Azure AI Foundry ポータルと Azure Machine Learning スタジオにあります。 ユーザーはモデルの使用に関するライセンス条項に同意します。 消費のための価格情報はデプロイ時に提供されます。

Microsoft 以外のプロバイダーのモデルは、Microsoft コマーシャル マーケットプレースの利用規約に従って、Azure Marketplace を通じて課金されます。

Microsoft のモデルは、ファースト パーティ従量課金サービスとして Azure メーターを介して課金されます。 製品使用条件に記載されているように、ファースト パーティ従量課金サービスは Azure メーターを使用して購入しますが、Azure サービス使用条件の対象ではありません。 これらのモデルの使用には、提供されているライセンス条項が適用されます。

モデルの微調整

MaaS を通じて利用でき、微調整をサポートするモデルの場合、ユーザーは Standard 課金でホストされている微調整を利用して、提供するデータを使用してモデルを調整できます。 詳細については、Azure AI Foundry ポータルで Llama 2 モデルを微調整する方法に関するページを参照してください。

標準の展開としてデプロイされたモデルを含む RAG

Azure AI Foundry を使用すると、ユーザーはベクトル インデックスと取得拡張生成を利用できます。 標準デプロイとしてデプロイできるモデルを使用して、カスタム データに基づいて埋め込みと推論を生成し、ユース ケースに固有の回答を生成できます。 詳細については、「取得拡張生成とインデックス」を参照してください。

オファーとモデルのリージョン別の利用可能性

標準課金は、モデル プロバイダーによってオファーが利用可能になった国/地域の課金アカウントに Azure サブスクリプションが属しているユーザーのみが利用できます。 関連するリージョンでこのオファーが利用できる場合、ユーザーはモデルのデプロイまたはファインチューニングの内の必要な方が利用できる Azure リージョン内にハブ/プロジェクトを所有している必要があります。 詳細については、 標準デプロイのモデルのリージョンの可用性 に関する記事を参照してください。

標準デプロイを使用してデプロイされたモデルのコンテンツの安全性

Von Bedeutung

現在、この機能はパブリック プレビュー段階にあります。 このプレビュー バージョンはサービス レベル アグリーメントなしで提供されており、運用環境のワークロードに使用することは推奨されません。 特定の機能はサポート対象ではなく、機能が制限されることがあります。

詳細については、「 Microsoft Azure プレビューの追加使用条件」を参照してください。

サーバーレス API を介してデプロイされた言語モデルの場合、Azure AI では、悪意のあるコンテンツ (ヘイト、自傷、性的、暴力など) を検出する Azure AI Content Safety テキスト モデレーション フィルターの既定の構成が実装されます。 コンテンツのフィルター処理の詳細については、「 Azure によって直接販売されるモデルのガードレールとコントロール」を参照してください。

ヒント

コンテンツ フィルタリングは、サーバーレス API を介してデプロイされる特定のモデルの種類では使用できません。 これらのモデルの種類には、埋め込みモデルと時系列モデルが含まれます。

コンテンツのフィルター処理は、サービスがコンテンツの生成を求めるプロンプトを処理すると同期的に行われます。 そのような使用については、「Azure AI Content Safety の価格」に従って別途課金される場合があります。 個々のサーバーレス エンドポイントのコンテンツ フィルター処理は、次のいずれかを無効にすることができます。

- 言語モデルを初めてデプロイした時点で

- 後で、デプロイの詳細ページでコンテンツフィルターを切り替えることによって

モデル推論 API 以外の API を使用して、サーバーレス API 経由でデプロイされたモデルを操作することにしたとします。 このような状況では、Azure AI Content Safety を使用して個別に実装しない限り、コンテンツ フィルタリングは有効になりません。

Azure AI Content Safety の概要については、「クイックスタート: テキスト コンテンツの分析」を参照してください。 サーバーレス API を使用してデプロイされたモデルを操作するときにコンテンツ フィルターを使用しない場合は、有害なコンテンツにユーザーを公開するリスクが高くなります。

標準デプロイを使用してデプロイされたモデルのネットワーク分離

標準デプロイとしてデプロイされたモデルのエンドポイントは、デプロイが存在するワークスペースのパブリック ネットワーク アクセス (PNA) フラグ設定に従います。 MaaS エンドポイントをセキュリティで保護するには、ワークスペースで PNA フラグを無効にします。 ワークスペースのプライベート エンドポイントを使用して、クライアントからエンドポイントへの受信通信をセキュリティで保護できます。

ワークスペースの PNA フラグを設定するには:

- Azure ポータルにアクセスします。

- "Azure Machine Learning " を探し、ワークスペースの一覧からワークスペースを選択します。

- [概要] ページで、左側のウィンドウを使用して >] に移動します。

- [パブリック アクセス] タブで、公衆ネットワーク アクセス フラグの設定を構成できます。

- 変更を保存します。 変更が反映されるまでに最大 5 分かかる場合があります。

制限事項

- 2024 年 7 月 11 日より前に作成されたプライベート エンドポイントを持つワークスペースがある場合、このワークスペースに追加された新しい MaaS エンドポイントは、そのネットワーク構成に従いません。 代わりに、ワークスペースの新しいプライベート エンドポイントを作成し、ワークスペースに新しい標準デプロイを作成して、新しいデプロイがワークスペースのネットワーク構成に従えるようにする必要があります。

- 2024 年 7 月 11 日より前に MaaS デプロイが作成されたワークスペースがあり、このワークスペースでプライベート エンドポイントを有効にしている場合、既存の MaaS デプロイはワークスペースのネットワーク構成に従いません。 ワークスペース内の標準デプロイがワークスペースの構成に従うには、デプロイをもう一度作成する必要があります。

- 現在、プライベート ワークスペースでは PNA フラグが無効になっているため、On Your Data のサポートはプライベート ワークスペースの MaaS デプロイでは使用できません。

- ネットワーク構成の変更 (PNA フラグの有効化または無効化など) が反映されるまでに最大 5 分かかる場合があります。