Microsoft Fabric は、独立系ソフトウェア ベンダー (ISV) が Fabric とシームレスに統合するための 3 つの異なる方法を提供します。 この取り組みから始まる ISV では、これらの各方法で利用可能なさまざまなリソースについて説明したいと思います。

Fabric OneLake との相互運用

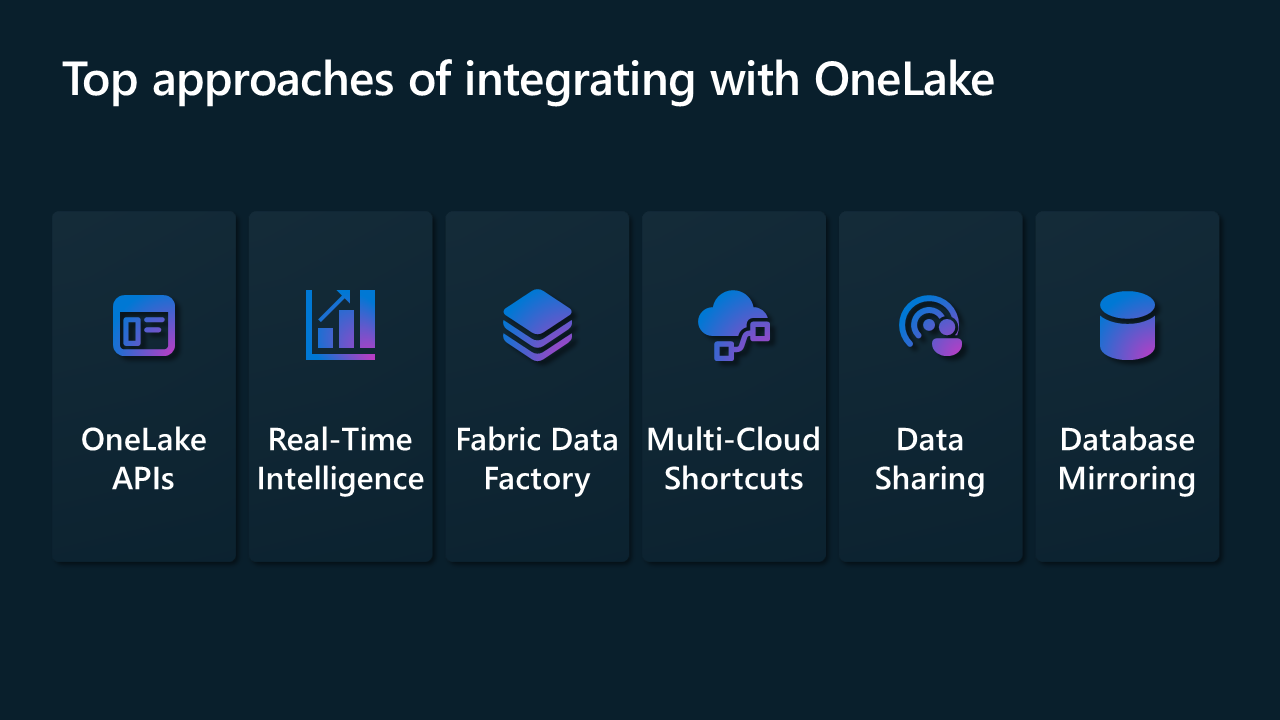

相互運用モデルの主な焦点は、ISV がソリューションを OneLake Foundation と統合できるようにすることです。 Microsoft Fabric と相互運用するために、Data Factory と Real-Time Intelligence の多数のコネクタを使用して統合を提供します。 また、OneLake 用の REST API、OneLake のショートカット、Fabric テナント間のデータ共有、データベース ミラーリングも提供しています。

次のセクションでは、このモデルの使用を開始する方法について、いくつか説明します。

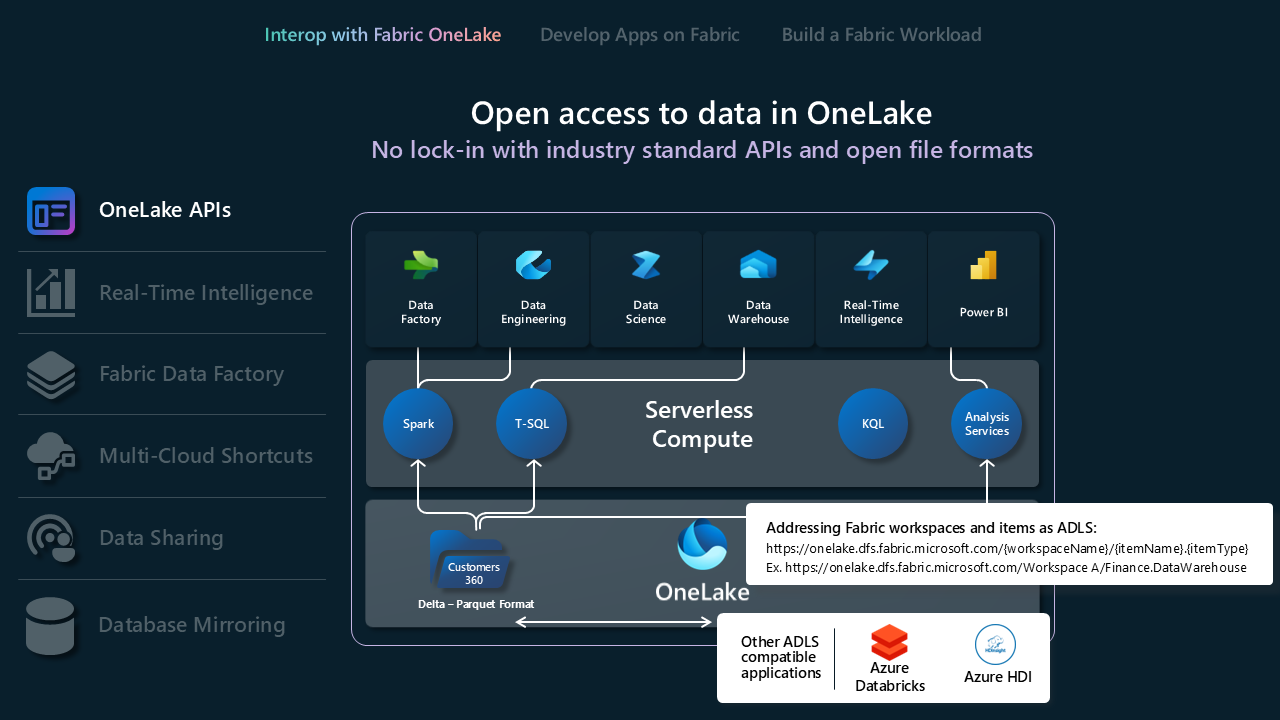

OneLake API

- OneLake では、直接やりとりできるよう既存の Azure Data Lake Storage (ADLS) Gen2 API と SDK がサポートされており、開発者は OneLake でデータの読み取り、書き込み、管理を行えます。 ADLS Gen2 REST API の詳細と、OneLake に接続する方法について説明します。

- ADLS Gen2 のすべての機能が OneLake に直接マップされるわけではないため、OneLake では、Fabric のワークスペースとアイテムをサポートするために、セット フォルダー構造も適用されます。 これらの API を呼び出すときの OneLake と ADLS Gen2 の間のさまざまな動作の完全な一覧については、「OneLake API パリティ」を参照してください。

- Databricks を使用していて、Microsoft Fabric に接続する場合、Databricks は ADLS Gen2 API と連携します。 OneLake と Azure Databricks の統合。

- Delta Lake ストレージ形式でできることを最大限に活用するには、形式、テーブルの最適化、V オーダーを確認して理解します。 Delta Lake テーブルの最適化と V オーダー。

- データが OneLake に入ったら、OneLake ファイル エクスプローラーを使用してローカルで閲覧します。 OneLake ファイル エクスプローラーは、OneLake と Windows ファイル エクスプローラーをシームレスに統合します。 このアプリケーションは、Windows ファイル エクスプローラーでアクセスできるすべての OneLake アイテムを自動的に同期します。 また、Azure Storage Explorer など、ADLS Gen2 と互換性のある他のツールを使用することもできます。

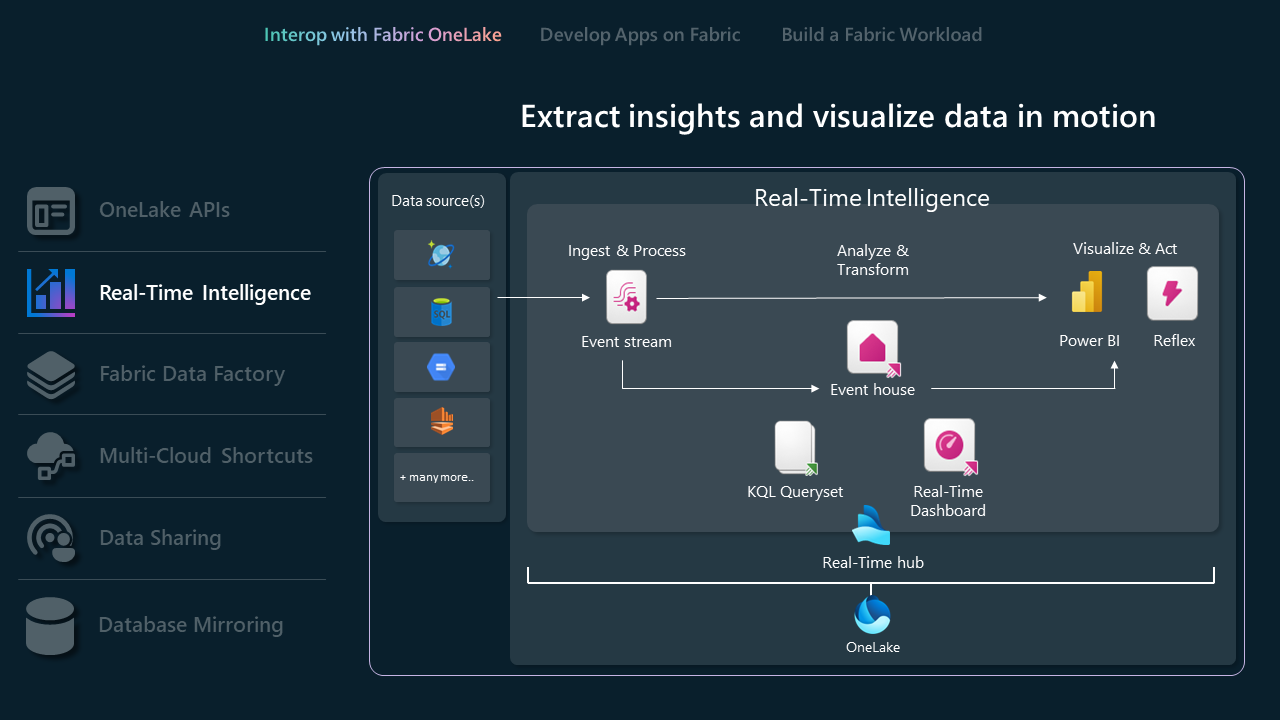

リアルタイム インテリジェンス API群

Fabric Real-Time Intelligence は、インジェストやストリーム処理から分析、視覚化、アクションまで、リアルタイム データのライフサイクル全体をサポートするように設計された包括的なソリューションです。 高スループットのストリーミング データを処理するために構築され、データ インジェスト、変換、クエリ、ストレージに対する堅牢な機能を提供し、組織がタイムリーなデータドリブンの意思決定を行えるようにします。

- Eventstreams を使用すると、さまざまなソースからリアルタイム イベントを取り込み、それらを Lakehouses、Eventhouse の KQL データベース、Fabric Activator などのさまざまな宛先にルーティングできます。 Eventstreams と Eventstreams API の詳細を確認します。

- ストリーミング データは、複数のプロトコルを使用して Eventstreams に取り込むことができます。 Kafka、Event Hubs、AMQP、およびここに記載されているコネクタの増え続ける一覧 。

- コードなしのエクスペリエンスまたは SQL 演算子 (プレビュー) を使用して取り込まれたイベントを処理した後、結果を複数の Fabric の宛先またはカスタム エンドポイントにルーティングできます。 Eventstreams の送信先の詳細については 、こちらをご覧ください。

- Eventhouses は、ストリーミング データ用に設計されており、Real-Time ハブと互換性があり、時間ベースのイベントに最適です。 データはインジェスト時間に基づいて自動的にインデックス付けおよびパーティション分割されるため、OneLake でアクセスできる高粒度データに対する非常に高速で複雑な分析クエリ機能が得られ、Fabric の一連のエクスペリエンスで使用できます。 イベントハウスでは、既存のイベントハウス API と SDK を直接操作できるようにサポートしているため、開発者はイベントハウスでデータの読み取り、書き込み、管理を行えます。 REST API の詳細について説明します。

- Databricks または Jupyter Notebook を使用している場合は、Kusto Python クライアント ライブラリを使用して、Fabric の KQL データベースを操作できます。 Kusto Python SDK の詳細について説明します。

- 既存の Microsoft Logic Apps、Azure Data Factory、または Microsoft Power Automate コネクタを使用して、イベントハウスまたは KQL データベースを操作できます。

- Real-Time Intelligence でのデータベース ショートカットは、ソース データベースに対するイベントハウス内の埋め込み参照です。 ソース データベースには、Real-Time Intelligence の KQL データベースまたは Azure Data Explorer データベースを指定できます。 ショートカットは、同じテナント内またはテナント間でのデータのイン プレース共有に使用できます。 API を使用したデータベース ショートカットの管理の詳細について説明します。

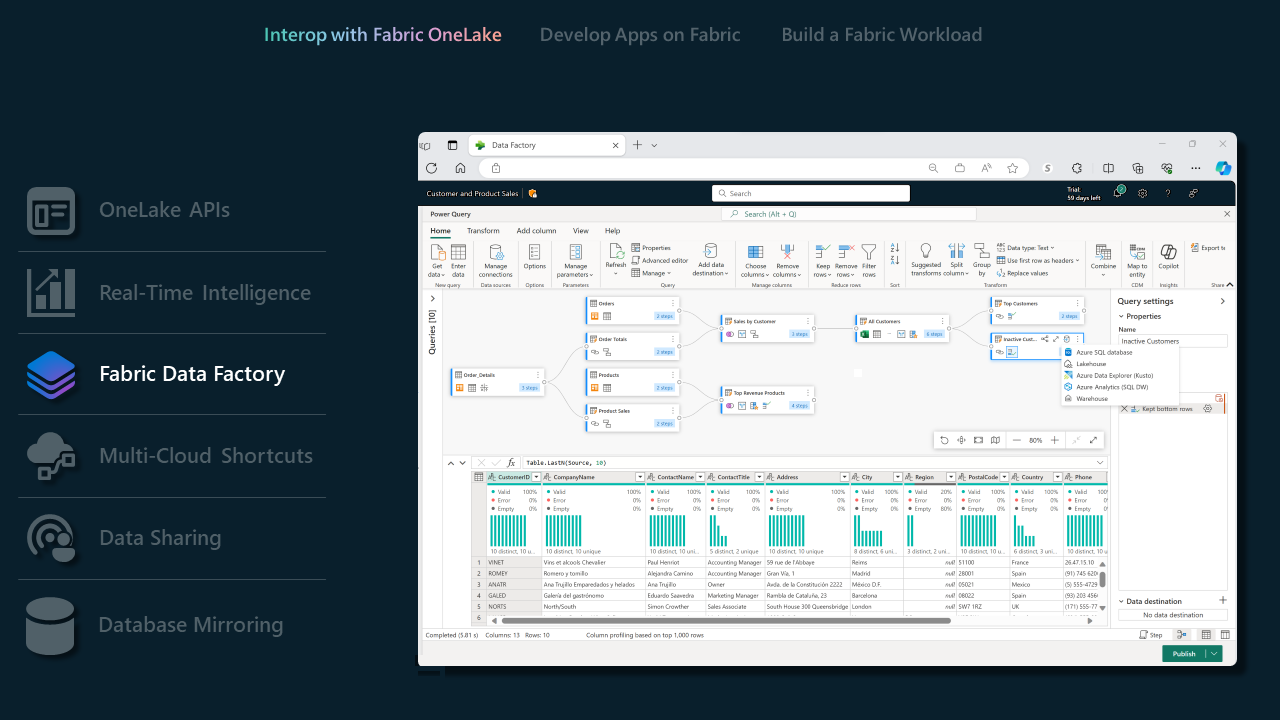

Fabric の Data Factory

- パイプラインには 広範なコネクタセットが用意されており、ISV は無数のデータ ストアに簡単に接続できます。 従来のデータベースと最新のクラウドベースのソリューションのどちらで接続する場合でも、当社のコネクタはスムーズな統合プロセスを実現します。 コネクタの概要。

- サポートされている Dataflow Gen2 コネクタを使用すると、ISV は Fabric Data Factory の機能を利用して複雑なデータ ワークフローを管理できます。 この機能は、ISV でデータ処理と変換のタスクを効率化しようとする場合に特に便利です。 Microsoft Fabric の Dataflow Gen2 コネクタ。

- Fabric の Data Factory でサポートされている機能の完全な一覧については、 Fabric ブログの Data Factory を参照してください。

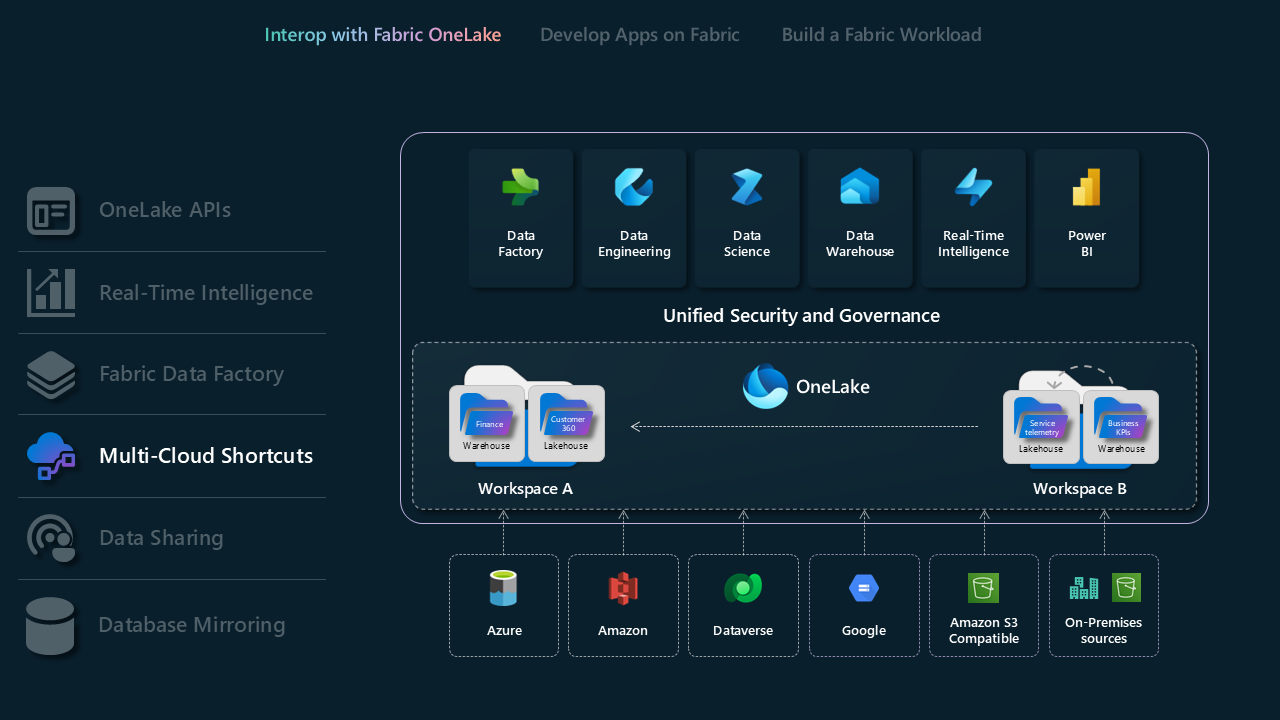

マルチクラウド ショートカット

Microsoft OneLake のショートカットを使用すると、企業全体に対して ひとつの仮想データ レイクを作成することで、ドメイン、クラウド、アカウントにまたがってデータを統合できます。 すべての Fabric エクスペリエンスと分析エンジンは、異なるテナントの OneLake、 Azure Data Lake Storage (ADLS) Gen2、 Amazon S3 ストレージ アカウント、 Google Cloud Storage(GCS)、 S3 互換データ ソース、 Dataverse などの既存のデータ ソースを統合された名前空間を介して直接ポイントできます。 OneLake は、さまざまなドメインとクラウド プラットフォームにわたる統合をシームレスにブリッジする、斬新なデータ アクセス ソリューションを ISV に提供します。

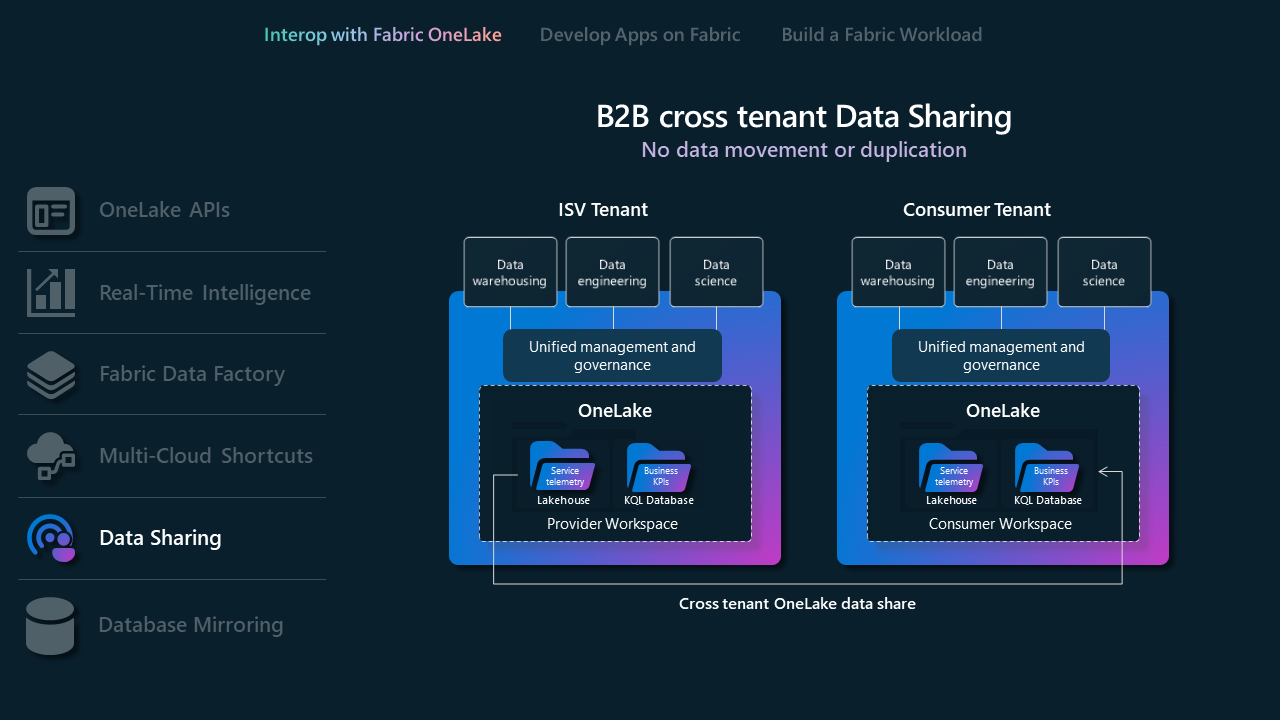

データ共有

データ共有を使用すると、Fabric ユーザーは、データを複製することなく、異なる Fabric テナント間でデータを共有ができます。 この機能は、OneLake ストレージの場所からデータを "インプレース" で共有できるようにすることで、コラボレーションを強化します。 データは読み取り専用として共有され、SQL、Spark、KQL、セマンティック モデルなど、さまざまな Fabric 計算エンジンからアクセスできます。 この機能を使用するために、Fabric 管理者は、共有テナントと受信テナントの両方でこの機能を有効にする必要があります。 このプロセスには、OneLake データ ハブまたはワークスペース内のデータの選択、共有設定の構成、目的の受信者への招待の送信などが含まれます。

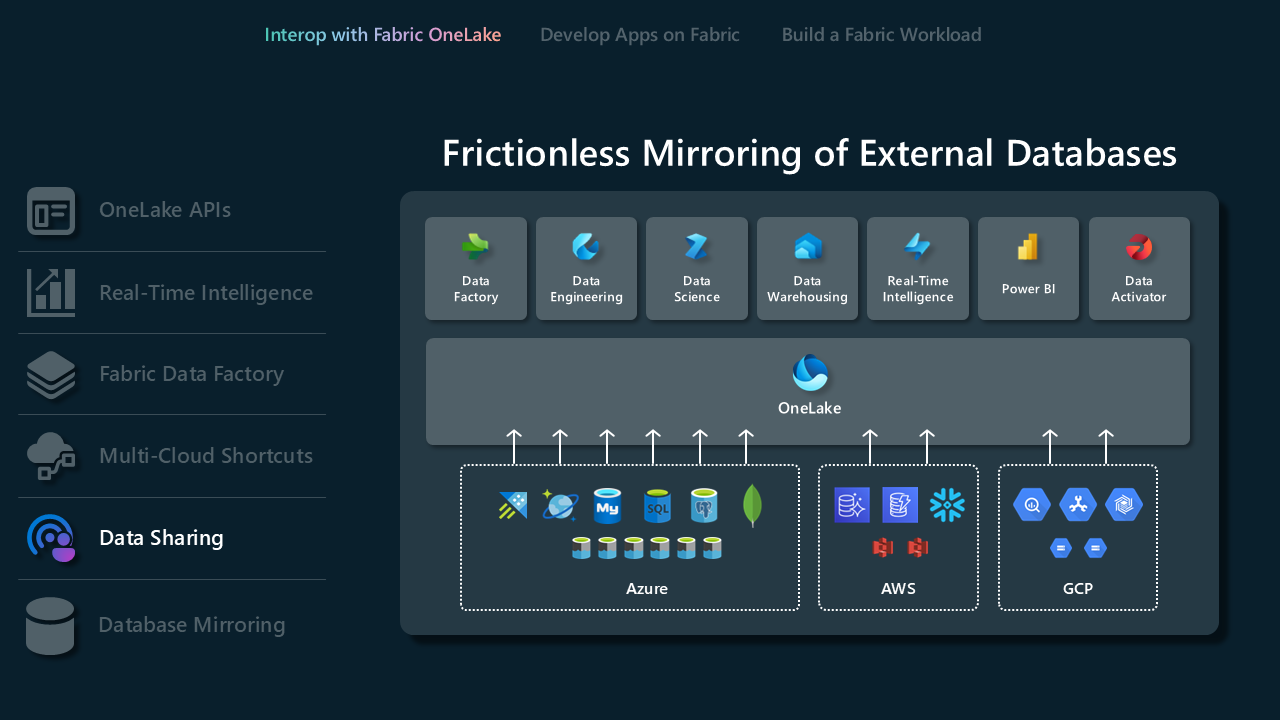

データベース ミラーリング

Fabric でのミラーリングを使用すると、複雑な ETL (変換読み込みの抽出) を回避し、既存のデータを Microsoft Fabric の残りのデータと共に OneLake に統合する簡単なエクスペリエンスが提供されます。 既存のデータを Fabric の OneLake に直接継続してレプリケートできます。 Fabric では、強力なビジネス インテリジェンス、人工知能、データ エンジニアリング、データ サイエンス、データ共有のシナリオのロックを解除できます。

- ミラーリングとサポートされているデータベースについて説明します。

オープン ミラーリングを使用すると、アプリケーション 変更データを Fabric のミラー化されたデータベースに直接書き込みます。 オープン ミラーリングは、拡張可能、カスタマイズ可能、かつオープンに設計されています。 これは、オープン Delta Lake テーブル形式に基づいて Fabric のミラーリングを拡張する強力な機能です。 Fabric の OneLake にデータが到着すると、オープン ミラーリングによって複雑なデータ変更の処理が簡略化され、ミラー化されたすべてのデータが継続的に最新かつ分析に対応した状態に維持されます。

- オープンミラーリング およびその使用タイミングについて詳しく学びましょう。

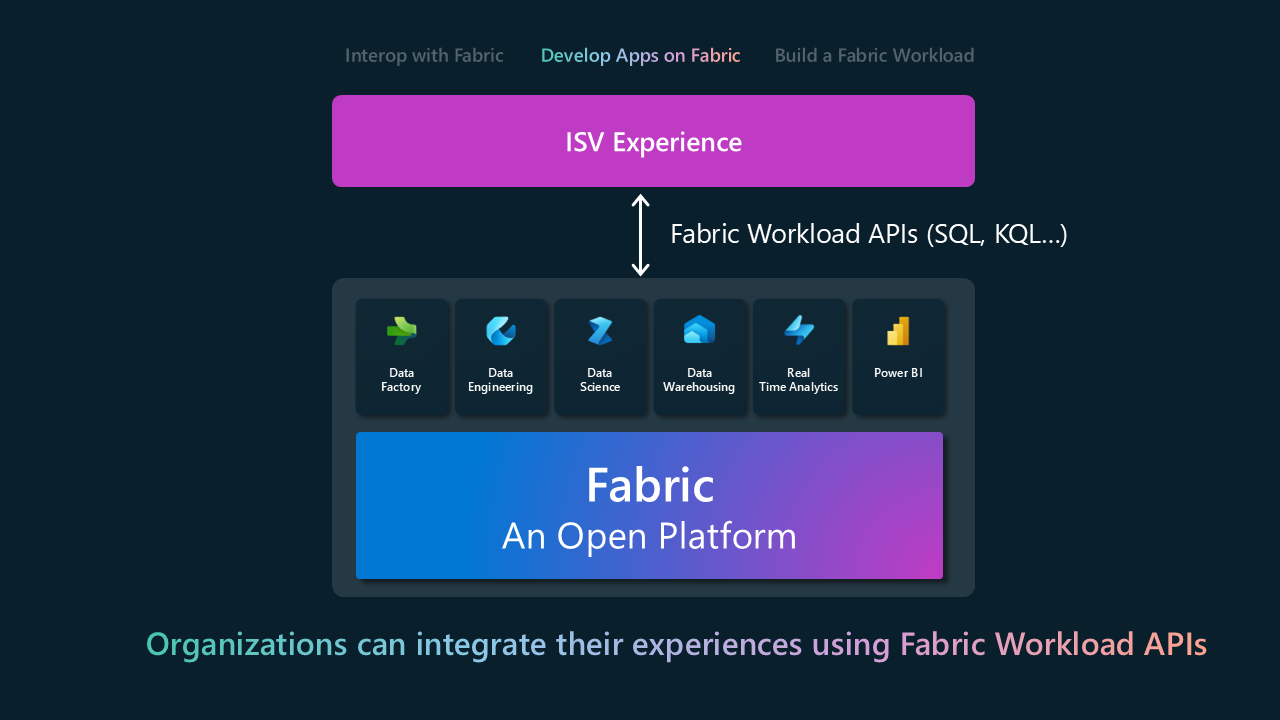

Fabric で開発

"Fabric で開発" モデルを使用すると、ISV は Fabric 上に製品やサービスを構築したり、既存のアプリケーション内に Fabric の機能をシームレスに埋め込んだりできます。 これは、基本的な統合から、Fabric が提供する機能のアクティブな適用への移行です。 主な統合の表面積は、さまざまな Fabric エクスペリエンスを対象とした REST API です。 次の表に、Fabric エクスペリエンス別にグループ化された REST API のサブセットを示します。 完全な一覧については、「Fabric REST API ドキュメント」を参照してください。

| Fabric エクスペリエンス | API |

|---|---|

| Data Warehouse |

-

倉庫 - ミラー化倉庫 |

| Data Engineering |

-

レイクハウス - 火花 - Spark ジョブ定義 - テーブル - 仕事 |

| Data Factory |

-

DataPipeline |

| リアルタイム インテリジェンス |

-

イベントハウス - KQL データベース - KQL クエリセット - Eventstream |

| Data Science |

-

ノートブック - ML 実験 - ML モデル |

| OneLake |

-

[ショートカット] - ADLS Gen2 API |

| Power BI |

-

報告 - ダッシュボード - セマンティック モデル |

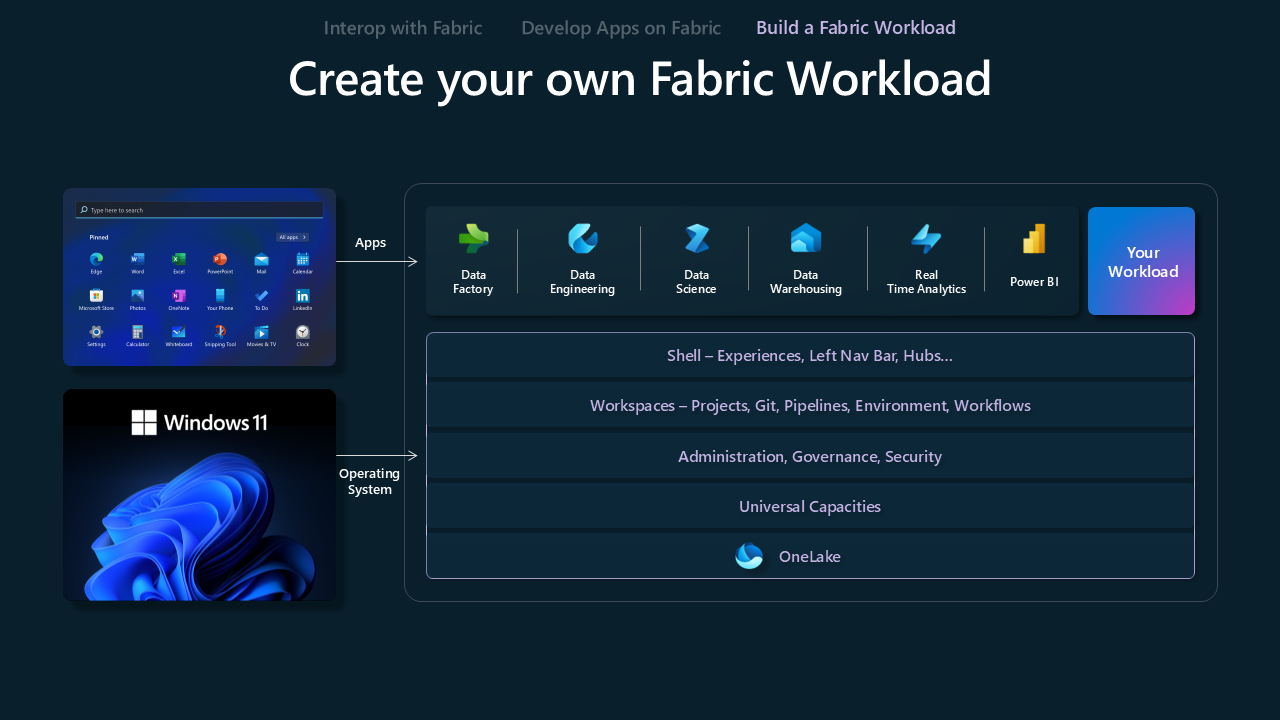

Fabric ワークロードの構築

Fabric ワークロードの構築 モデルは、ISV が Fabric プラットフォームでカスタム エクスペリエンスを作成できるように設計がされています。 ISV には、自社のオファリングを Fabric エコシステムに合わせて調整するために必要なツールと機能が用意されており、独自の価値提案と Fabric の広範な機能の組み合わせの最適化をします。

Microsoft Fabric ワークロード開発キット は、開発者がアプリケーションを Microsoft Fabric ハブに統合するための包括的なツールキットを提供します。 この統合により、Fabric ワークスペース内に新機能を直接追加できるため、ユーザーの分析体験を強化します。 開発者と ISV は、お客様に到達するための新しい手段を提供し、使い慣れたエクスペリエンスと新しいエクスペリエンスの両方を提供し、既存のデータ アプリケーションの活用をします。 ファブリック管理者は、組織内でワークロードを追加できるユーザーを管理できます。

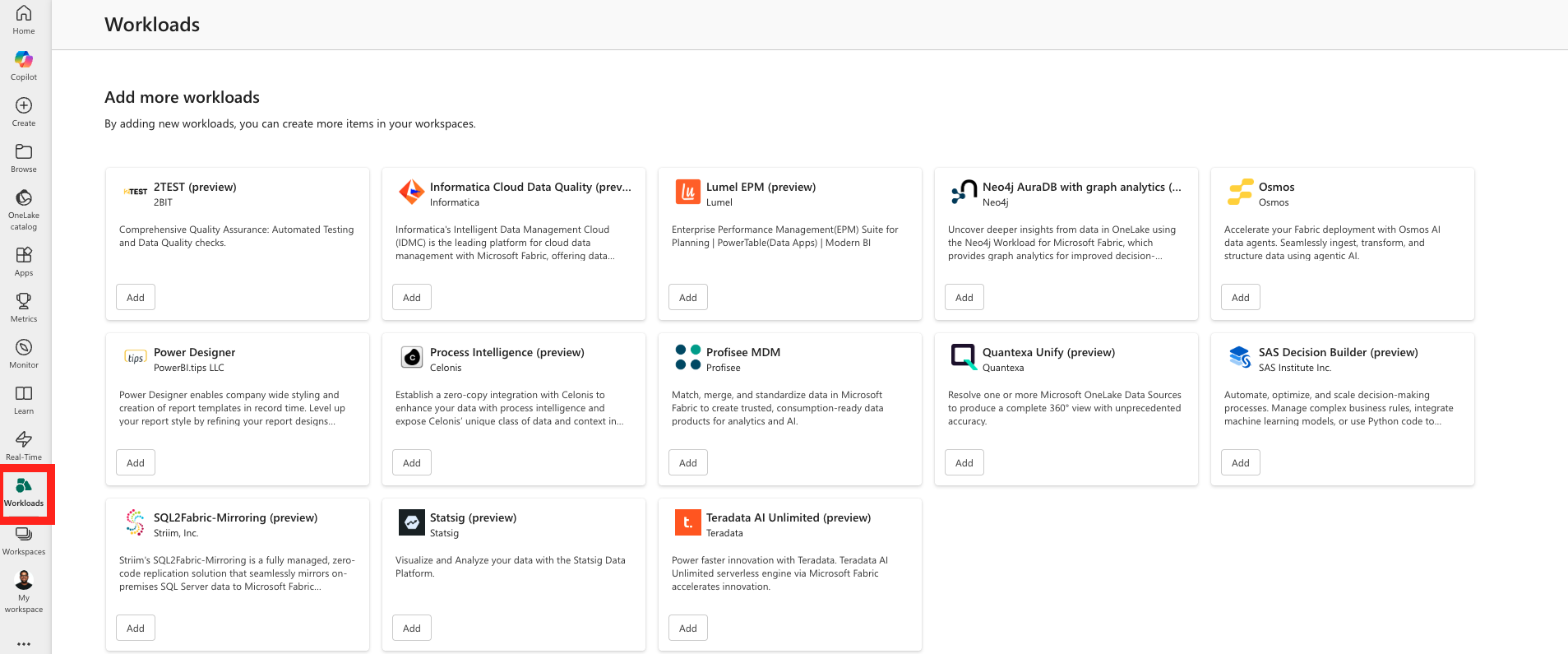

ワークロード ハブ

Microsoft Fabric の Workload Hub は、ユーザーが使用可能なすべてのワークロードを探索、管理、アクセスできる一元化されたインターフェイスとして機能します。 Fabric の各ワークロードは、Fabric ワークスペース内で作成できる特定の項目の種類に関連付けられます。 ワークロード ハブ内を移動することで、ユーザーはさまざまなワークロードを簡単に検出して操作でき、分析機能と運用機能が強化されます。

ファブリック管理者には、ワークロードの可用性を管理する権限があり、テナント全体または特定の容量内でアクセスできるようにします。 この拡張性により、Fabric は柔軟でスケーラブルなプラットフォームであり続け、組織は進化するデータとビジネス要件を満たすようにワークロード環境を調整できます。 ワークロード ハブは、Fabric のセキュリティおよびガバナンス フレームワークとシームレスに統合することで、ワークロードのデプロイと管理を簡素化します。 すべてのワークロードには、ユーザーがすぐに使い始める試用エクスペリエンスが用意されています。 使用可能なワークロードを次に示します。

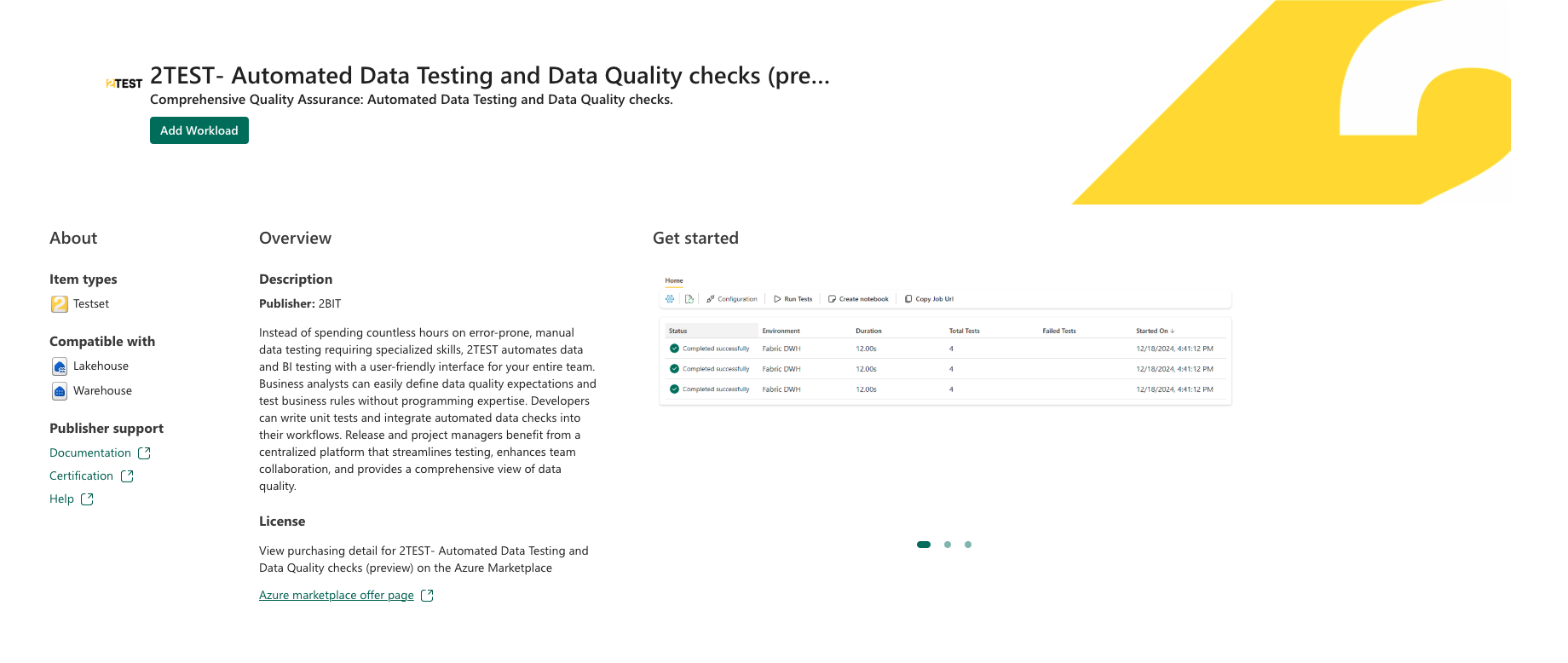

2TEST: テストとデータ品質チェックを自動化する包括的な品質保証ワークロード。

Informatica Cloud Data Quality: ファブリック環境内でデータの問題 (重複、欠損値、不整合など) を直接プロファイリング、検出、修正しましょう。

Lumel EPM: ビジネス ユーザーがセマンティック モデルの上にコードなしの Enterprise Performance Management (EPM) アプリを構築できるようにします。

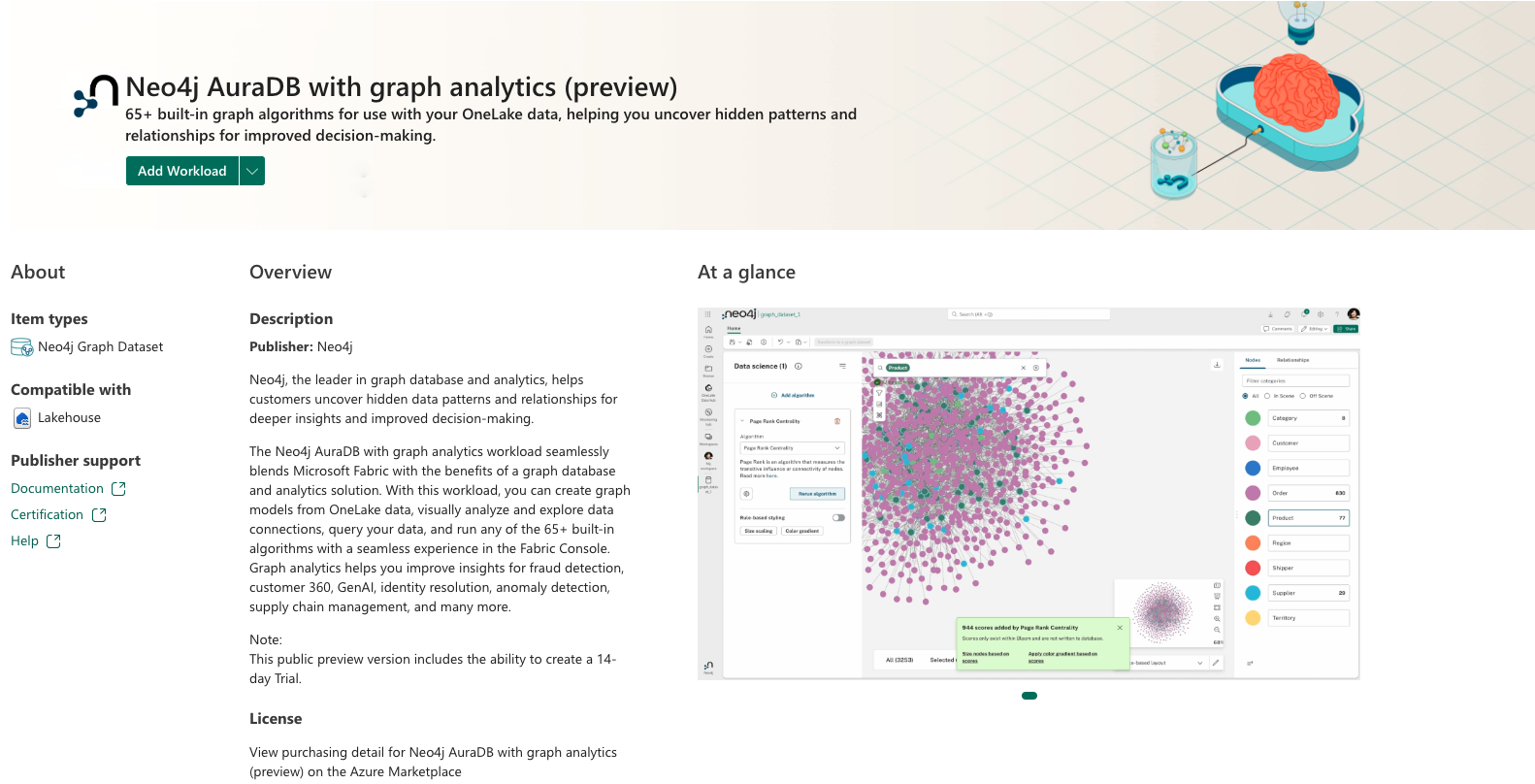

Graph Analytics を使用した Neo4j AuraDB: OneLake データからグラフ モデルを作成し、データ接続を視覚的に分析して探索し、データのクエリを実行し、Fabric コンソールでシームレスなエクスペリエンスで 65 以上の組み込みアルゴリズムを実行します。

Osmos AI Data Wrangler: AI を利用したデータ ラングラーを使用してデータ準備を自動化し、データ変換を簡単に行います。

Power Designer: 会社全体のスタイルとレポート テンプレートを作成するためのツールで、Power BI レポートのデザインを改善します。

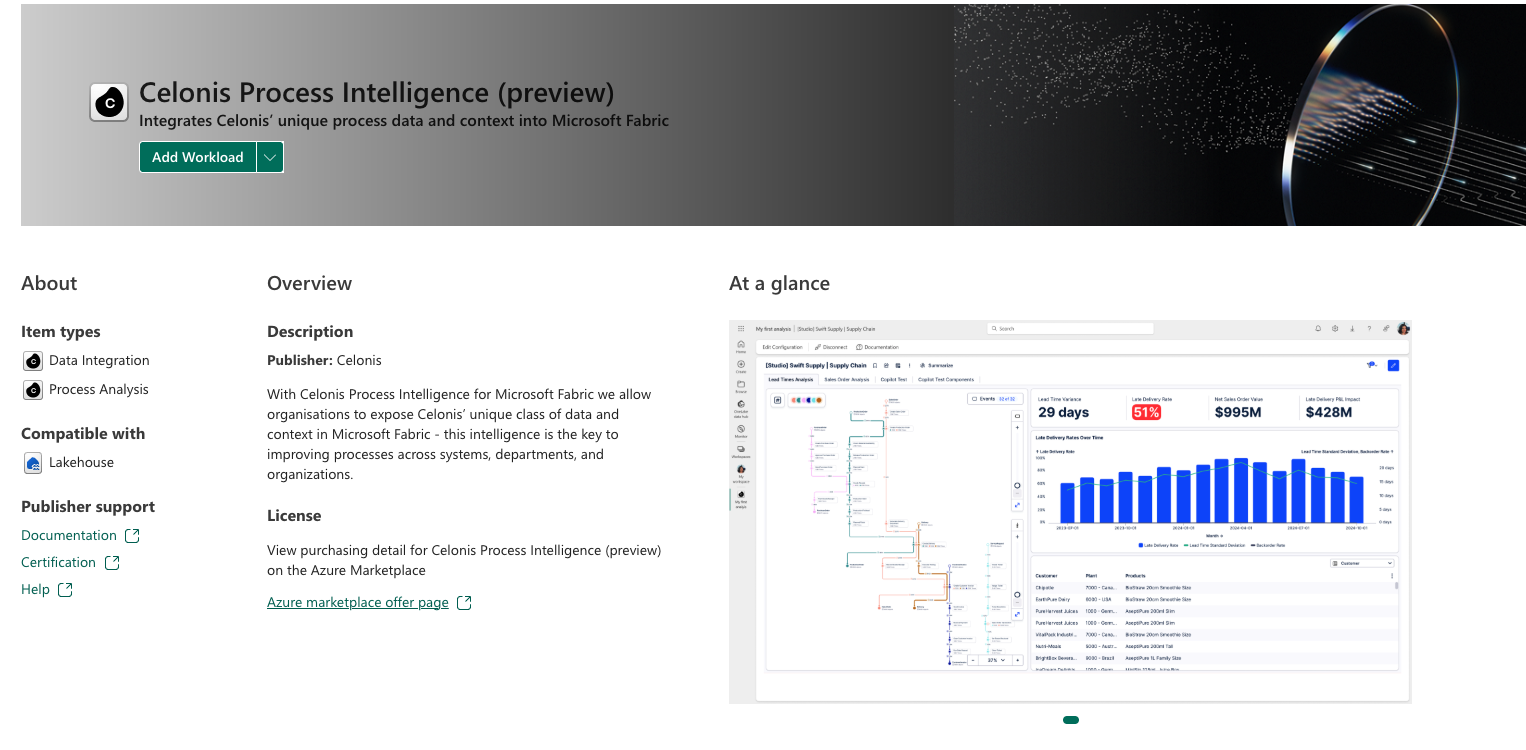

Celonis プロセス インテリジェンス: 組織は、Microsoft Fabric で Celonis 固有のデータクラスとコンテキストを公開できます。

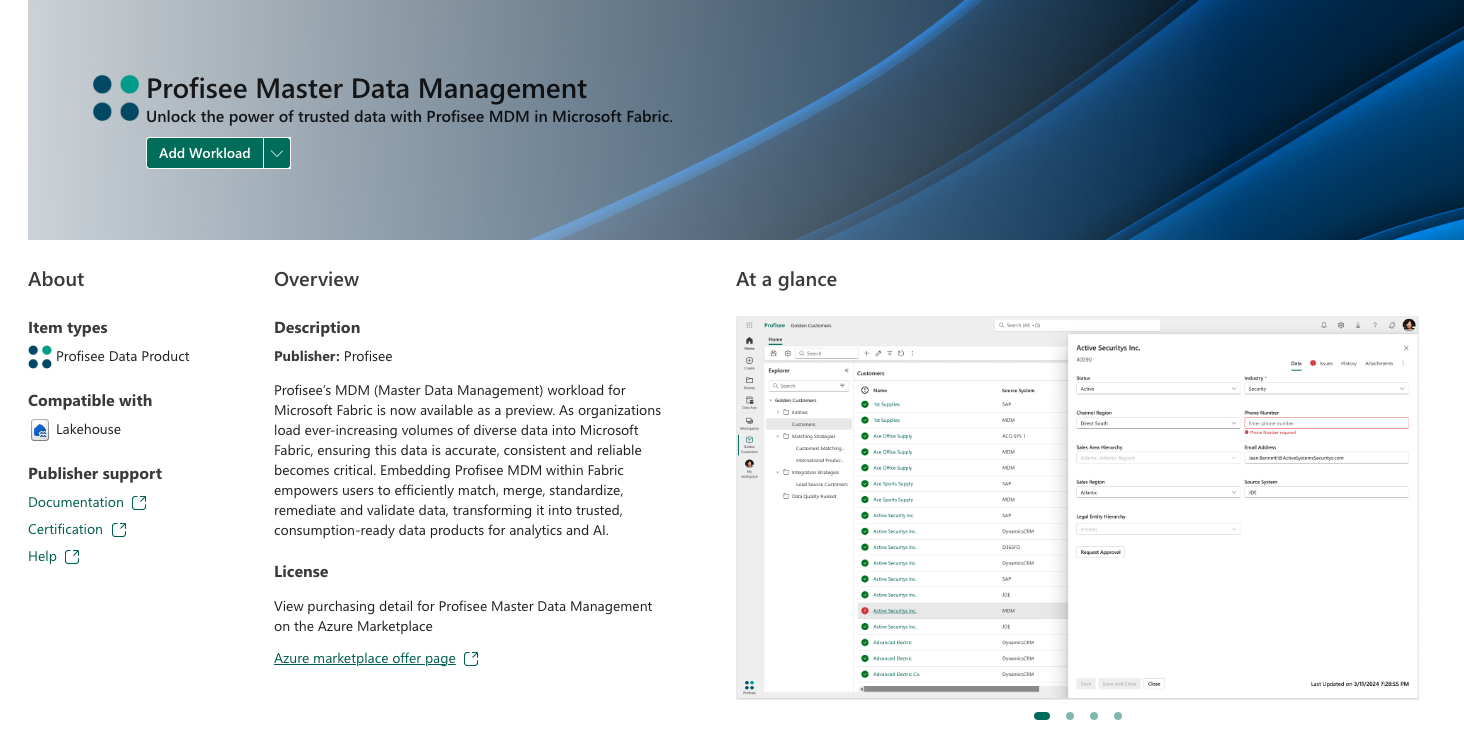

Profisee Master Data Management: ユーザーは、データの効率的な照合、マージ、標準化、修復、検証を行い、分析と AI のために信頼できる消費可能なデータ製品に変換できます。

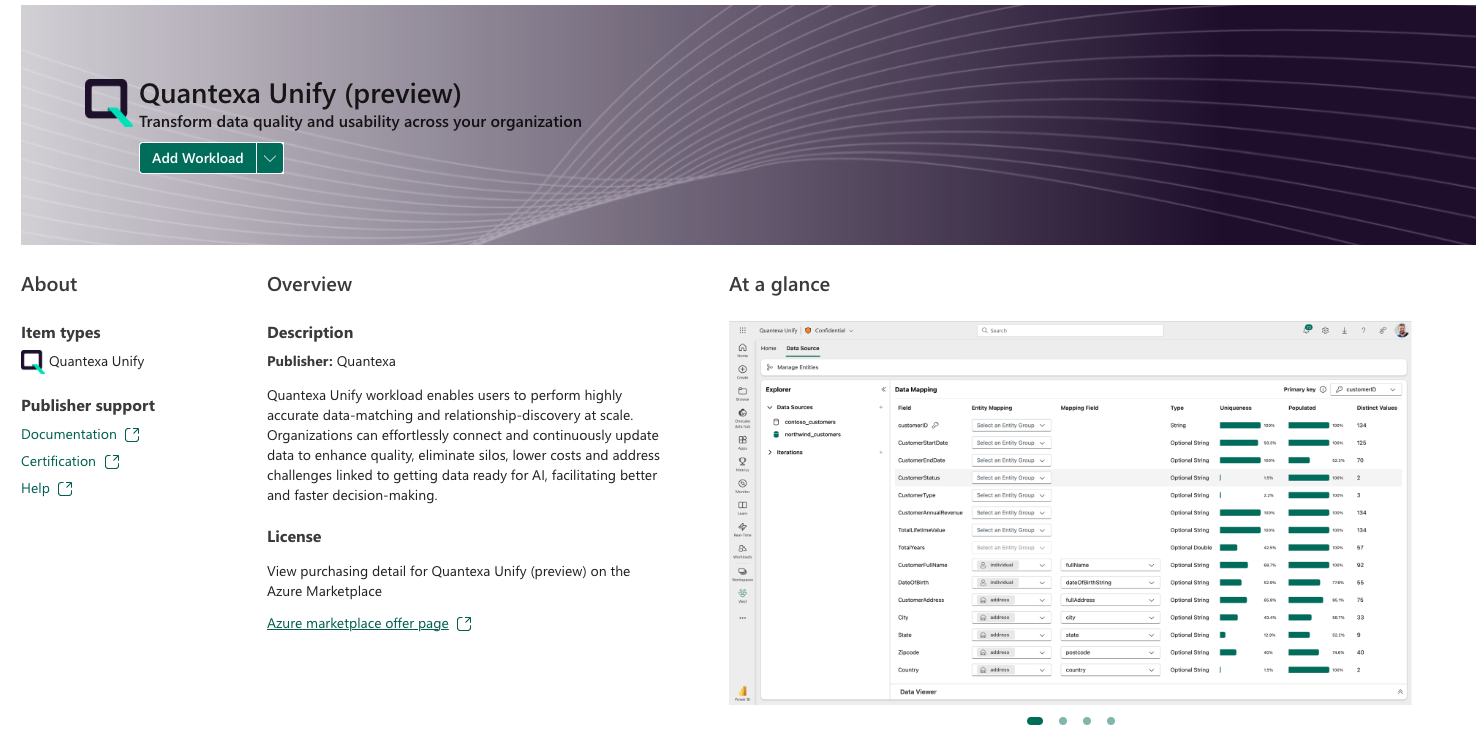

Quantexa の統合: 高度なデータ解決機能を備えた 360 度ビューを提供することで、Microsoft OneLake データ ソースを強化します。

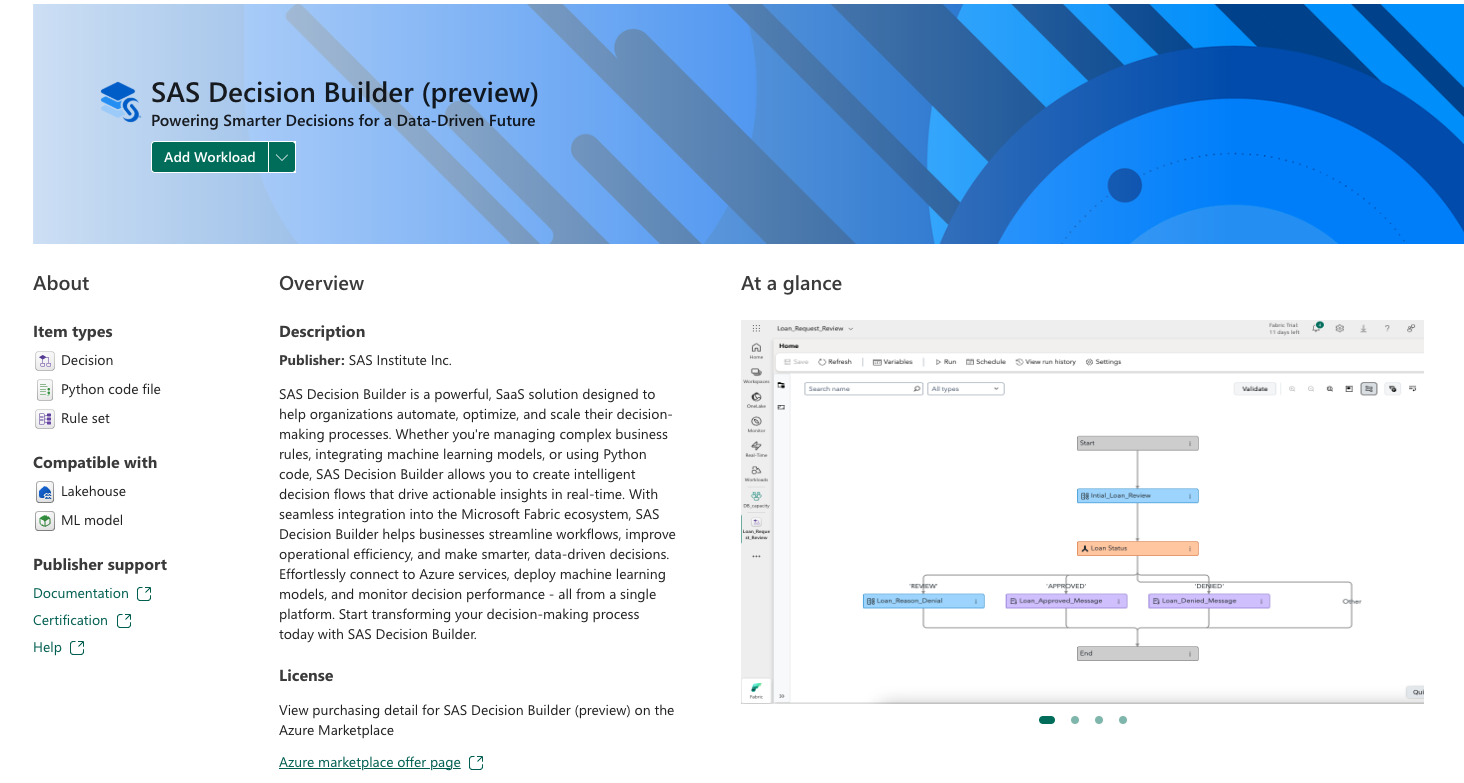

SAS Decision Builder: 組織が意思決定プロセスを自動化、最適化、スケーリングするのに役立ちます。

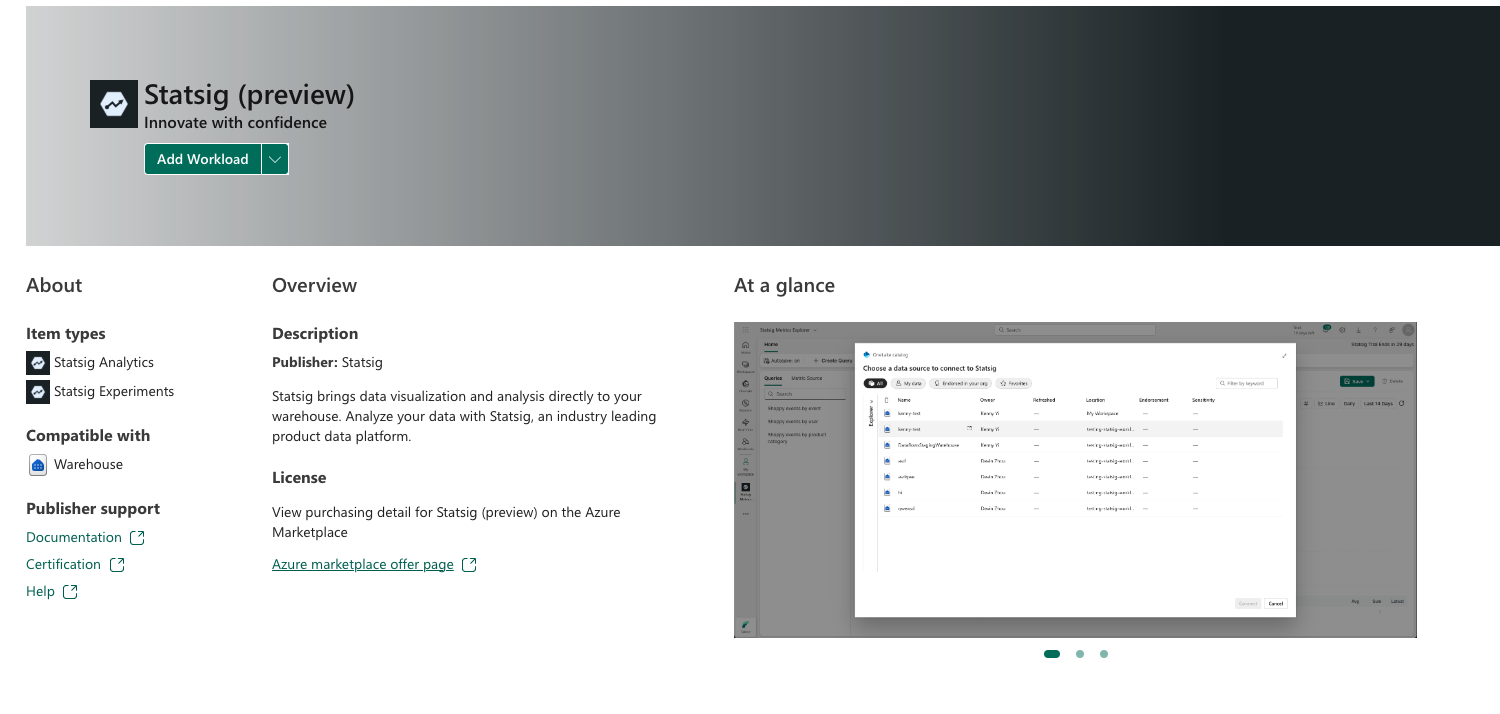

Statsig: データの視覚化と分析をウェアハウスに直接取り込みます。

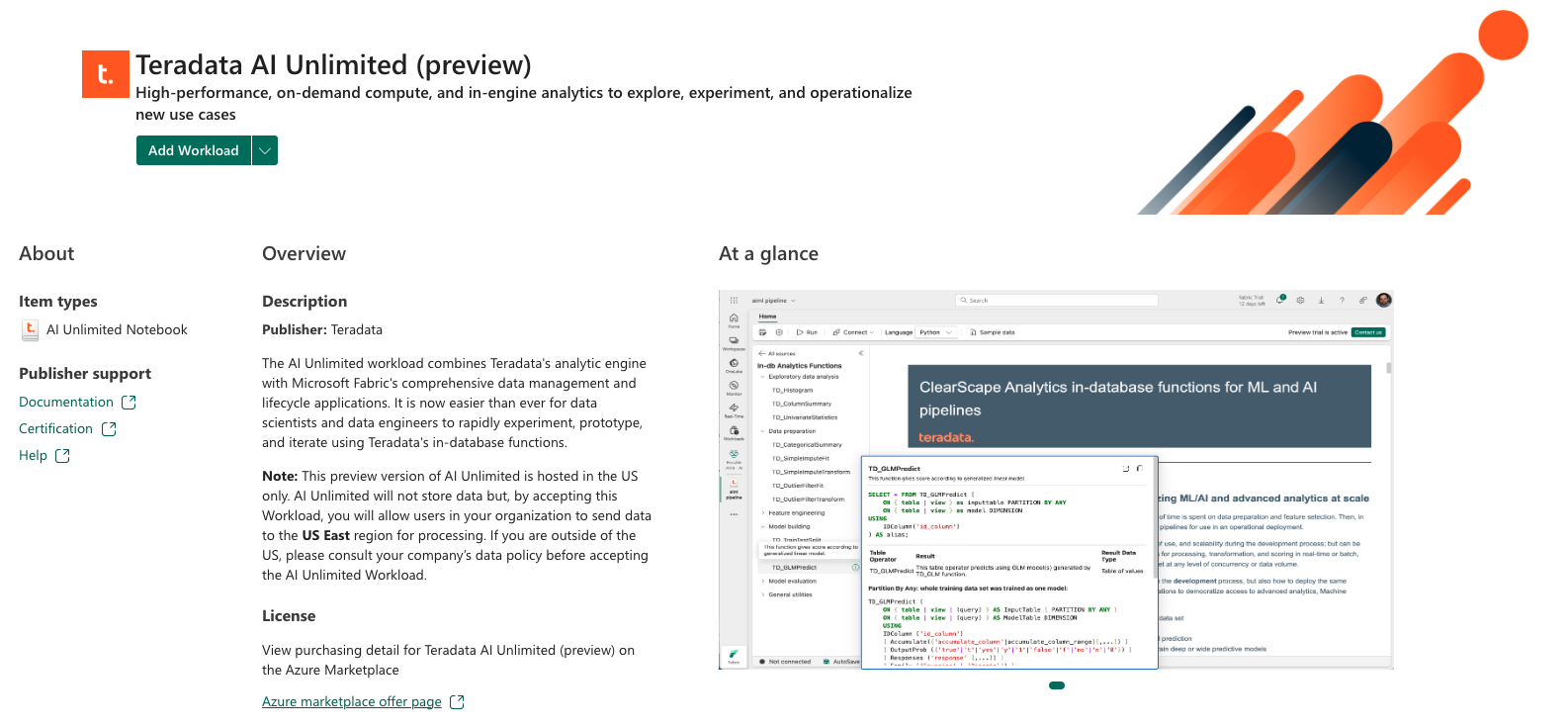

Teradata AI Unlimited: Teradata の分析エンジンと、Teradata のデータベース内関数を通じて Microsoft Fabric のデータ管理機能を組み合わせます。

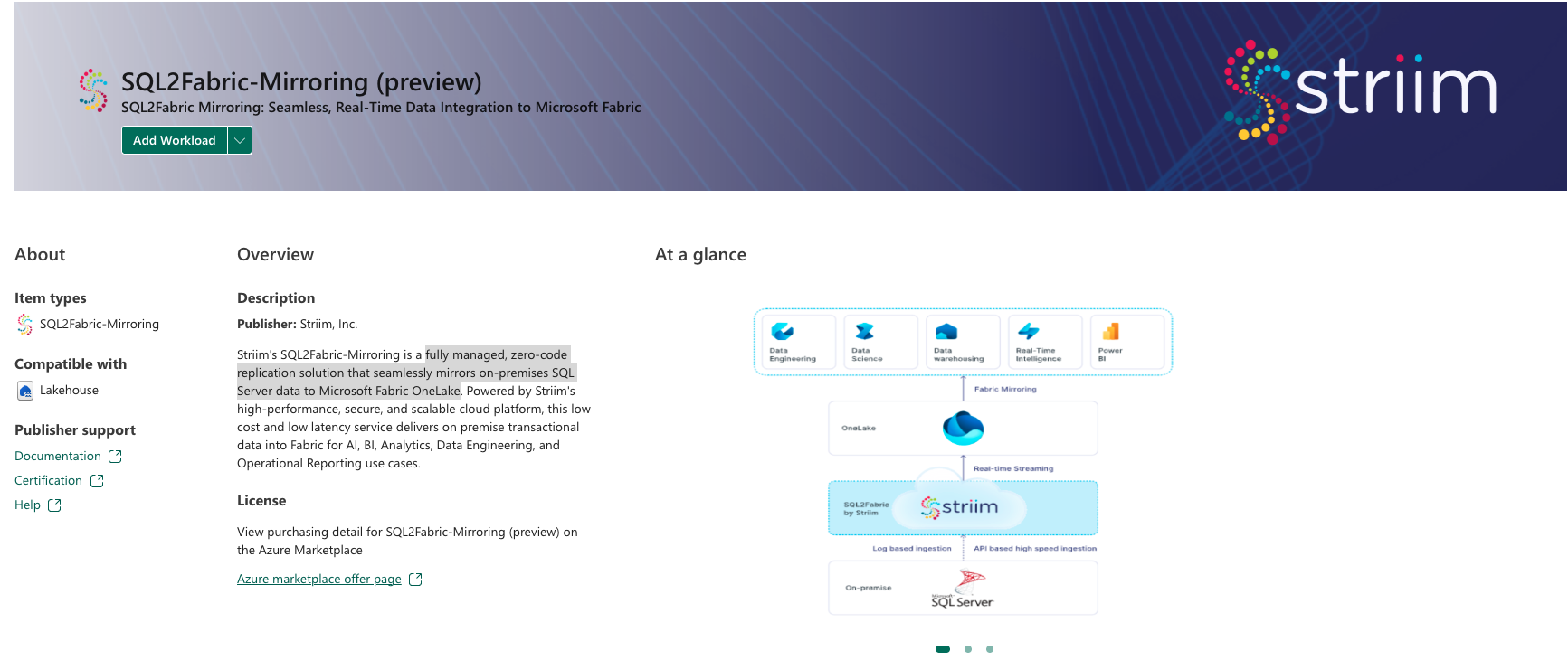

Striim によるSQL2Fabric-Mirroring: オンプレミスの SQL Server データを Microsoft Fabric OneLake にシームレスにミラーリングする、フル マネージドのゼロコード レプリケーション ソリューション

使用できるワークロードが増えるにつれて、Workload Hub は引き続き新しい機能を検出するための動的な領域として機能し、ユーザーがデータドリブン ソリューションのスケーリングと最適化に必要なツールを持っていることを確認します。