このチュートリアルでは、ノートブックを使用して Fabric Lakehouse にデータを読み書きする方法について説明します。 Fabric では Spark API がサポートされ、Pandas API はこの目標を達成することです。

Apache Spark API を使用してデータを読み込む

ノートブックのコード セルで、次のコード例を使用してソースからデータを読み込み、Lakehouse の Files、 Tables、または両方のセクションにロードします。

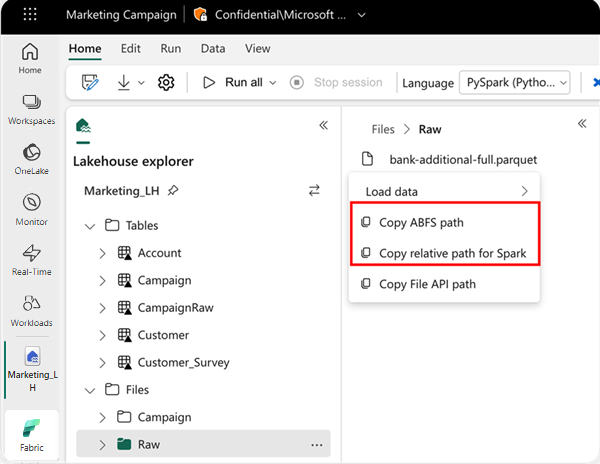

読み取る場所を指定するには、データが現在のノートブックの既定のレイクハウスからのデータである場合は、相対パスを使用します。 または、データが別のレイクハウスからのデータである場合は、絶対 Azure BLOB ファイル システム (ABFS) パスを使用できます。 データのコンテキスト メニューからこのパスをコピーします。

ABFS パスのコピー: このオプションは、ファイルの絶対パスを返します。

Spark の相対パスをコピーする: このオプションは、既定の lakehouse 内のファイルの相対パスを返します。

df = spark.read.parquet("___location to read from")

# Keep it if you want to save dataframe as CSV files to Files section of the default lakehouse

df.write.mode("overwrite").format("csv").save("Files/ " + csv_table_name)

# Keep it if you want to save dataframe as Parquet files to Files section of the default lakehouse

df.write.mode("overwrite").format("parquet").save("Files/" + parquet_table_name)

# Keep it if you want to save dataframe as a delta lake, parquet table to Tables section of the default lakehouse

df.write.mode("overwrite").format("delta").saveAsTable(delta_table_name)

# Keep it if you want to save the dataframe as a delta lake, appending the data to an existing table

df.write.mode("append").format("delta").saveAsTable(delta_table_name)

Pandas API を使用してデータを読み込む

Pandas API をサポートするために、既定の lakehouse が自動的にノートブックにマウントされます。 マウント ポイントは '/lakehouse/default/' です。 このマウント ポイントを使用して、既定の lakehouse のデータの読み取り/書き込みを行うことができます。 コンテキスト メニューの [ファイル API パスのコピー] オプションは、そのマウント ポイントからファイル API パスを返します。 [ ABFS パスのコピー] オプションから返されるパスは、Pandas API でも機能します。

ファイル API パスのコピー: このオプションは、既定の lakehouse のマウント ポイントの下のパスを返します。

# Keep it if you want to read parquet file with Pandas from the default lakehouse mount point

import pandas as pd

df = pd.read_parquet("/lakehouse/default/Files/sample.parquet")

# Keep it if you want to read parquet file with Pandas from the absolute abfss path

import pandas as pd

df = pd.read_parquet("abfss://DevExpBuildDemo@msit-onelake.dfs.fabric.microsoft.com/Marketing_LH.Lakehouse/Files/sample.parquet")

ヒント

Spark API の場合は、[ ABFS パスのコピー ] または [Spark の相対パスのコピー ] オプションを使用して、ファイルのパスを取得してください。 Pandas API の場合は、 ABFS パスのコピー または ファイルのコピー API パス のオプションを使用して、ファイルのパスを取得してください。

Spark API または Pandas API を使用するコードを使用する最も簡単な方法は、[ データの読み込み ] オプションを使用して、使用する API を選択することです。 このコードは、ノートブックの新しいコード セルに自動的に生成されます。

![[データの読み込み] オプションを選択する場所を示すスクリーンショット。](media/lakehouse-notebook-explore/load-data-menu.png)