Data Factory for Microsoft Fabric の Spark ジョブ定義アクティビティを使用すると、Spark ジョブ定義への接続を作成し、パイプラインから実行できます。

前提 条件

開始するには、次の前提条件を満たす必要があります。

- アクティブなサブスクリプションを持つテナント アカウント。 無料用のアカウントを作成します。

- ワークスペースが作成されます。

UI を使用して Spark ジョブ定義アクティビティをパイプラインに追加する

ワークスペースに新しいパイプラインを作成します。

ホーム画面カードから Spark ジョブ定義を検索し、それを選択するか、アクティビティ バーからアクティビティを選択してパイプライン キャンバスに追加します。

パイプライン エディター キャンバスで新しい Spark ジョブ定義アクティビティがまだ選択されていない場合は選択します。

全般設定 ガイダンスを参照して、[全般設定] タブにあるオプションを構成します。

Spark ジョブ定義アクティビティの設定

アクティビティのプロパティ ウィンドウで [設定] タブを選択し、実行する Spark ジョブ定義を含むファブリック ワークスペースを選択します。

パイプラインエディターウィンドウで、Sparkジョブ定義プロパティページの設定タブを示すスクリーンショット。

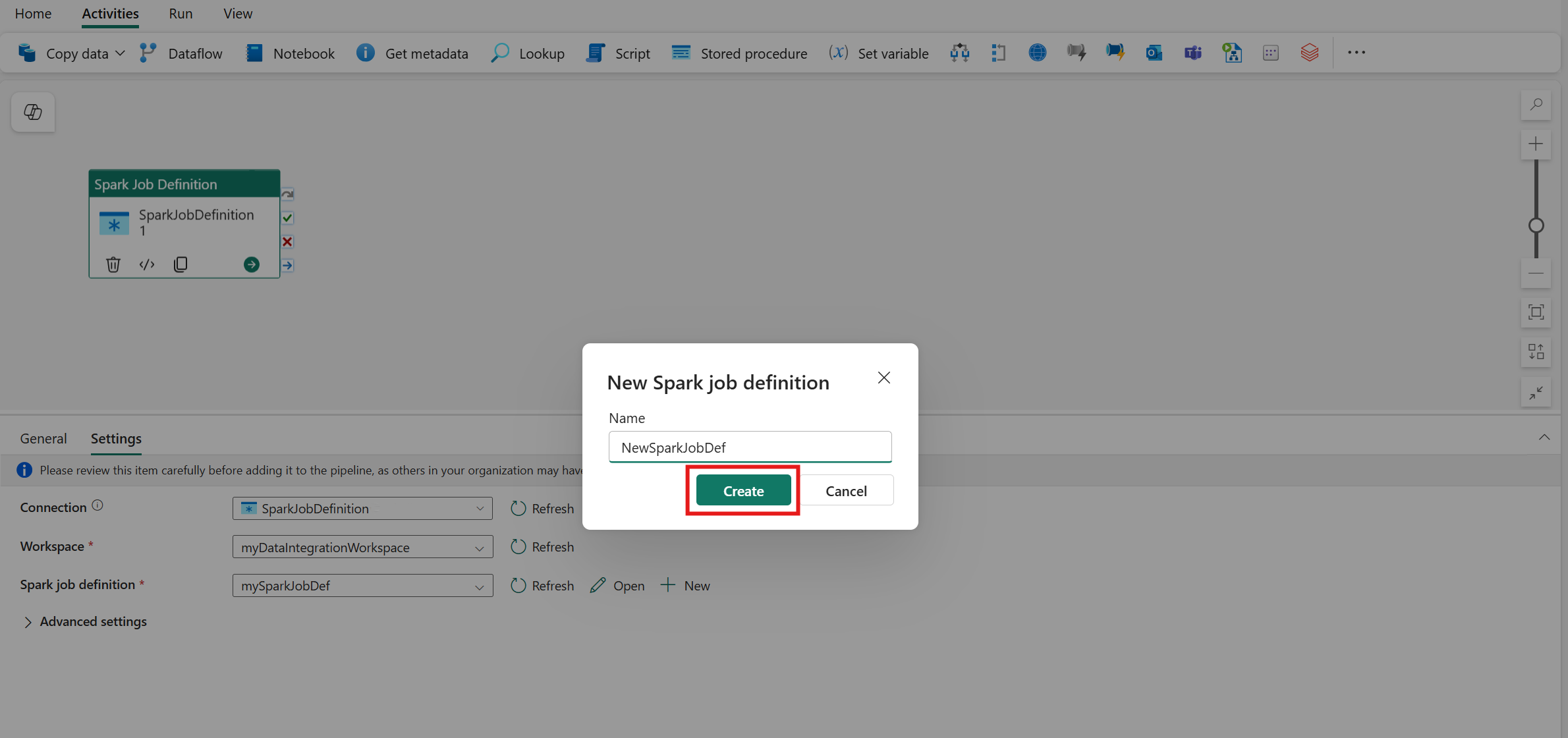

設定 タブでは、接続、ワークスペース、および Spark ジョブ定義を設定できます。 Spark ジョブ 定義がまだ存在しない場合は、パイプライン エディターで +新規 ボタンを選択して、Spark ジョブ定義 を作成できます。

パイプライン エディター ウィンドウの [Spark ジョブ定義のプロパティ] ページにある [設定] タブの [Spark ジョブ定義] 選択ボックスの横にある [+新規] ボタンを示すスクリーンショット。

名前を設定して [作成] を選択すると、Spark ジョブ定義が表示され、構成が設定されます。

設定 タブの中で、詳細設定の下でさらに設定を構成できます。

パイプラインエディターキャンバスで、Sparkジョブ定義アクティビティの詳細設定を示すスクリーンショット。

これらの設定フィールドをパラメーター化して、Spark ジョブ定義項目を調整することもできます。 渡された値は、Spark ジョブ定義の元の構成をオーバーライドします。

Spark ジョブ定義アクティビティ設定の [詳細設定] の下のメイン定義ファイルの式セットを示すスクリーンショット。

既知の制限事項

Fabric Data Factory の Spark ジョブ定義アクティビティの現在の制限事項を次に示します。 このセクションは変更される可能性があります。

- 出力タブを使用したアクティビティの監視はサポートされていますが、Spark ジョブ定義をより詳細なレベルで監視することはできません。 たとえば、監視ページ、状態、期間、および以前の Spark ジョブ定義の実行へのリンクは、Data Factory では直接使用できません。 ただし、詳細については、Spark ジョブ定義の監視ページを参照してください。

パイプラインを保存して実行またはスケジュールする

パイプラインに必要なその他のアクティビティを構成したら、パイプライン エディターの上部にある [ホーム] タブに切り替え、保存ボタンを選択してパイプラインを保存します。 [実行] を選択して直接実行する、または [スケジュール] を選択してスケジュールします。 ここで実行履歴を表示したり、他の設定を構成したりすることもできます。

![パイプライン エディターの [ホーム] タブを示すスクリーンショット。[保存]、[実行]、[スケジュール] ボタンが強調表示されています。](media/spark-job-definition-activity/save-run-schedule.png)

![パイプライン エディター ウィンドウの [アクティビティ] バーから新しい Spark ジョブ定義アクティビティを作成する場所を示すスクリーンショット。](media/spark-job-definition-activity/create-activity-from-activities-bar.png)

![[詳細設定] で動的コンテンツを追加する方法を示すスクリーンショット。](media/spark-job-definition-activity/parameterize-spark-job-definition.png)