Power Apps で使用できる高度なデータ準備を使用すると、データフローと呼ばれるデータのコレクションを作成できます。これを使用して、さまざまなソースからのビジネス データに接続し、データをクリーンアップして変換し、Microsoft Dataverse または組織の Azure Data Lake Gen2 ストレージ アカウントに読み込むことができます。

データフローは、Power Apps サービスの環境で作成および管理されるテーブルのコレクションです。 データフローにテーブルを追加および編集したり、データフローが作成された環境から直接、データ更新スケジュールを管理したりできます。

Power Apps ポータルでデータフローを作成したら、データフローの作成時に選択した宛先に応じて、Dataverse コネクタまたは Power BI Desktop Dataflow コネクタを使用してデータを取得できます。

データフローを使用するには、主に次の 3 つの手順があります。

Power Apps ポータルでデータフローを作成します。 出力データの読み込み先、データを取得するソース、Power Query の手順を選択して、簡単に行えるように設計された Microsoft ツールを使用してデータを変換します。

データフローの実行をスケジュールします。 これは、データフローが読み込んで変換するデータを Power Platform データフローが更新する頻度です。

宛先ストレージに読み込んだデータを使用します。 アプリ、フロー、Power BI レポート、ダッシュボードを構築したり、Azure Data Factory、Azure Databricks などの Azure データ サービス、または Common Data Model フォルダー標準をサポートするその他のサービスを使用して、組織のレイク内のデータフローの Common Data Model フォルダーに直接接続したりできます。

以降のセクションでは、各手順を完了するために用意されているツールを理解できるように、これらの各手順について説明します。

データフローを作成する

データフローは、1 つの環境で作成されます。 そのため、その環境からのみ表示および管理できます。 さらに、データフローからデータを取得する個人は、作成した環境にアクセスできる必要があります。

Important

- データフローの作成は、現在、Power Apps Developer Plan ライセンスでは使用できません。

- 現在、Firefox Web ブラウザーは、Power Apps データフローの "更新履歴ファイルのダウンロード" アクションではサポートされていません。 詳細情報: "データフローの更新中に問題が発生しました" というエラー メッセージが表示される

Power Apps にサインインし、使用している環境を確認し、コマンド バーの右側付近にある環境スイッチャーを見つけます。

左側のナビゲーション ウィンドウで、データフローを選択します。 項目がサイド パネル ウィンドウに表示されない場合は、…さらに表示 を選択して、目的の項目を選択します。

[ 新しいデータフロー] を選択します。 [ 新しいデータフロー ] ページで、データフローの名前を入力 します 。 既定では、データフローはテーブルを Dataverse に格納します。 「分析エンティティのみ」を選択すると、組織の Azure Data Lake ストレージ アカウントにテーブルが格納されます。 を選択してを作成します。

Important

データフローの所有者は 1 人だけです。データフローを作成したユーザーです。 データフローを編集できるのは所有者だけです。 データフローによって作成されたデータへの承認とアクセスは、データの読み込み先によって異なります。 Dataverse に読み込まれたデータは、Dataverse Connector 経由で使用でき、データにアクセスするユーザーに Dataverse への承認が必要です。 組織の Azure Data Lake Gen2 ストレージ アカウントに読み込まれたデータには、Power Platform Dataflow コネクタを介してアクセスでき、それにアクセスするには、作成された環境内のメンバーシップが必要です。

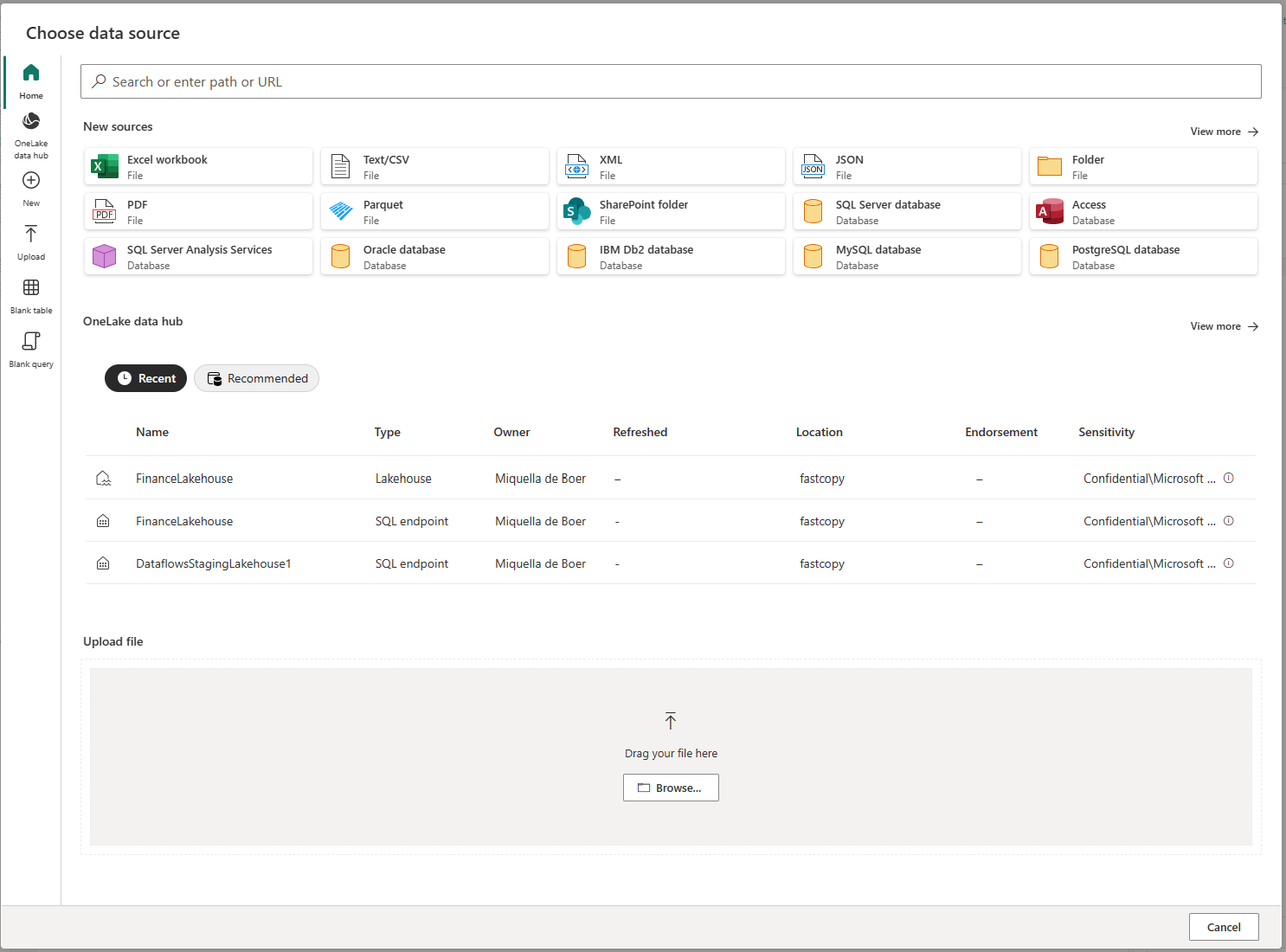

[ データ ソースの選択 ] ページで、テーブルが格納されているデータ ソースを選択します。 表示されるデータ ソースを選択すると、データフロー テーブルを作成できます。

データ ソースを選択すると、データ ソースへの接続時に使用するアカウントなど、接続設定を指定するように求められます。 [次へ] を選択します。

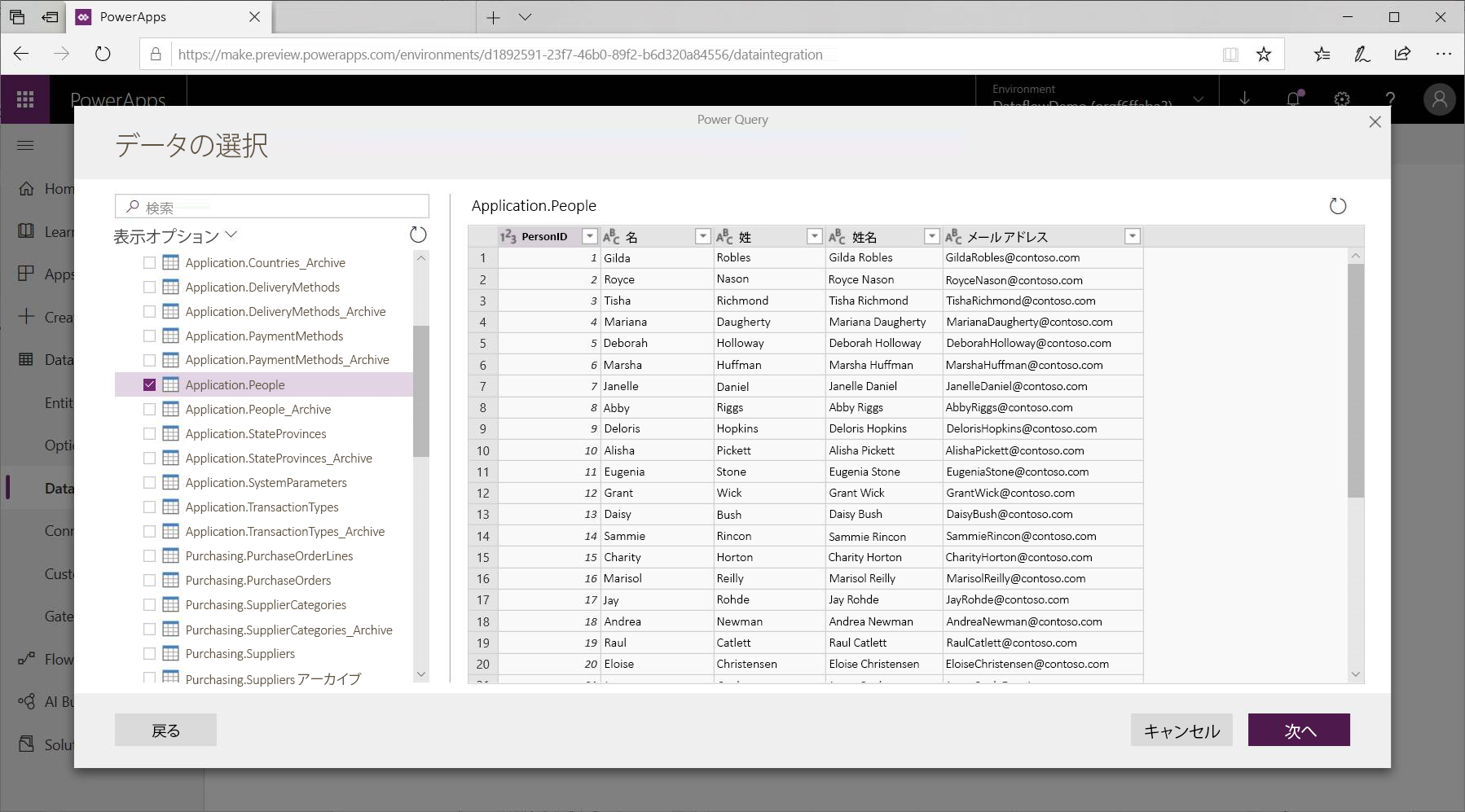

接続したら、テーブルに使用するデータを選択します。 データとソースを選択すると、Power Platform データフロー サービスは、後でセットアップ プロセスで選択した頻度で、データフロー内のデータを最新の状態に保つためにデータ ソースに再接続します。

テーブルで使用するデータを選択したので、データフロー エディターを使用して、データフローで使用するために必要な形式にそのデータを整形または変換できます。

データフロー エディターを使用してデータを整形または変換する

Power BI Desktop の Power Query エディターと同様に、Power Query 編集エクスペリエンスを使用して、データ選択をテーブルに最適なフォームに整形できます。 Power Query の詳細については、「 Power BI Desktop でのクエリの概要」を参照してください。

クエリ エディターが各ステップで作成しているコードを表示する場合、または独自の整形コードを作成する場合は、高度なエディターを使用できます。

データフローと共通データ モデル

データフロー テーブルには、ビジネス データを Common Data Model に簡単にマップし、Microsoft および Microsoft 以外のデータで強化し、機械学習への簡単なアクセスを得るための新しいツールが含まれています。 これらの新機能を活用して、ビジネス データに対するインテリジェントで実用的な分析情報を提供できます。 以下で説明するクエリの編集手順で変換を完了したら、共通データ モデルで定義されている標準テーブル列にデータ ソース テーブルの列をマップできます。 標準テーブルには、共通データ モデルによって定義された既知のスキーマがあります。

この方法と共通データ モデルの詳細については、「 共通データ モデル」を参照してください。

データフローで Common Data Model を活用するには、[クエリの編集] ダイアログで [標準にマップ] 変換を選択します。 表示される [テーブルのマップ ] 画面で、マップする標準テーブルを選択します。

ソース列を標準列にマップすると、次の処理が行われます。

ソース列は標準列名を使用します (名前が異なる場合は列の名前が変更されます)。

ソース列は、標準列のデータ型を取得します。

Common Data Model 標準テーブルを保持するために、マップされていないすべての標準列は Null 値を取得します。

マッピングされていないすべてのソース列はそのまま残り、マッピングの結果がカスタム列を含む標準テーブルであることを確認します。

選択が完了し、テーブルとそのデータ設定が完了したら、次の手順に進み、データフローの更新頻度を選択します。

更新頻度を設定する

テーブルが定義されたら、接続されている各データ ソースの更新頻度をスケジュールする必要があります。

データフローでは、データ更新プロセスを使用してデータを最新の状態に保ちます。 Power Platform データフロー作成ツールでは、選択したスケジュールされた間隔でデータフローを手動または自動で更新することを選択できます。

更新を自動的にスケジュールする

[ 自動的に更新] を選択します。

データフローの頻度を入力します。

頻度ベースの更新。 30 分単位の増分、開始日、時刻 (UTC) の頻度を設定します。

特定の日と時刻に更新します。 タイム ゾーン、頻度 (毎日または毎週) と時刻を 30 分単位で選択します。

![[自動的に更新] オプション。](media/refresh-automatically.png)

発行を選択します。

組織によっては、データフローの作成と管理に独自のストレージを使用したい場合があります。 要件に従ってストレージ アカウントを適切に設定する場合は、データフローを Azure Data Lake Storage Gen2 と統合できます。 詳細情報: データフロー ストレージ用に Azure Data Lake Storage Gen2 を接続する

データ接続のトラブルシューティング

データフローのデータ ソースに接続すると、問題が発生する場合があります。 このセクションでは、問題が発生した場合のトラブルシューティングのヒントを示します。

Salesforce コネクタ。 データフローで Salesforce の試用版アカウントを使用すると、情報が提供されない接続エラーが発生します。 これを解決するには、実稼働 Salesforce アカウントまたは開発者アカウントを使用してテストします。

SharePoint コネクタ。 サブフォルダーやドキュメントを含めずに、SharePoint サイトのルート アドレスを指定してください。 たとえば、

https://microsoft.sharepoint.com/teams/ObjectModelのようなリンクを使用します。JSON ファイル コネクタ。 現時点では、基本認証のみを使用して JSON ファイルに接続できます。 たとえば、

https://XXXXX.blob.core.windows.net/path/file.json?sv=2019-01-01&si=something&sr=c&sig=123456abcdefgのような URL は現在サポートされていません。Azure Synapse Analytics。 データフローでは現在、Azure Synapse Analytics の Microsoft Entra 認証はサポートされていません。 このシナリオでは基本認証を使用します。

注

データ損失防止 (DLP) ポリシーを使用して Microsoft Entra (事前認証) コネクタで HTTP をブロックすると、 SharePoint コネクタと OData コネクタは失敗します。 Microsoft Entra (事前認証済み) コネクタを使用する HTTP は、SharePoint コネクタと OData コネクタが機能するための DLP ポリシーで許可されている必要があります。

エラーのトラブルシューティング: Dataverse への接続に失敗しました。 この問題を解決する方法については、以下のリンクを参照してください

エクスポートに使用している接続に修正が必要な場合、ユーザーにエラー メッセージが表示されることがあります。 この場合、ユーザーは Dataverse への接続に失敗したことを示すエラー メッセージを受け取ります。この問題を解決する方法については、以下のリンクを参照してください。

この問題を解決するには、次の手順を実行します。

- Power Apps (make.powerapps.com) で、左側のナビゲーション ウィンドウから [接続 ] を選択します。 項目がサイド パネル ウィンドウに表示されない場合は、…さらに表示 を選択して、目的の項目を選択します。

- Microsoft Dataverse (レガシー) 接続を見つけます。

- [状態] 列の [接続の修正] リンクを選択し、画面の指示に従います。

修正が完了したら、エクスポートを再試行します。

"データフローの更新中に問題が発生しました" というエラー メッセージが表示される

このエラーは、Firefox Web ブラウザーの使用中にデータフローを更新しようとすると発生します。 この問題を回避するには、Microsoft Edge や Google Chrome などの別の Web ブラウザーを使用します。

次のステップ

次の記事は、データフローを使用する場合の詳細情報とシナリオに役立ちます。

Common Data Model の詳細については、以下を参照してください。