Jupyter Notebook은 Microsoft Sentinel 데이터 레이크에서 데이터를 탐색, 분석 및 시각화하기 위한 대화형 환경을 제공합니다. Notebook을 사용하면 코드를 작성하고 실행하고, 워크플로를 문서화하고, 결과를 한 곳에서 볼 수 있습니다. 이렇게 하면 데이터 탐색을 쉽게 수행하고, 고급 분석 솔루션을 빌드하고, 다른 사용자와 인사이트를 공유할 수 있습니다. Visual Studio Code 내에서 Python 및 Apache Spark를 활용하여 Notebook을 사용하면 원시 보안 데이터를 실행 가능한 인텔리전스로 변환할 수 있습니다.

이 문서에서는 Visual Studio Code에서 Jupyter Notebook을 사용하여 데이터 레이크 데이터를 탐색하고 상호 작용하는 방법을 보여 줍니다.

필수 조건

Microsoft Sentinel 데이터 레이크에 등록하기

Microsoft Sentinel 데이터 레이크에서 Notebook을 사용하려면 먼저 데이터 레이크에 온보딩해야 합니다. Sentinel 데이터 레이크에 온보딩하지 않은 경우 Microsoft Sentinel 데이터 레이크에 온보딩을 참조하세요. 최근에 데이터 레이크에 온보딩한 경우 Notebook을 사용하여 의미 있는 분석을 수행하기 전에 충분한 양의 데이터가 수집될 때까지 어느 정도 시간이 필요할 수 있습니다.

권한

Microsoft Entra ID 역할은 데이터 레이크의 모든 작업 영역에서 광범위한 액세스를 제공합니다. 또는 Azure RBAC 역할을 사용하여 개별 작업 영역에 대한 액세스 권한을 부여할 수 있습니다. Microsoft Sentinel 작업 영역에 대한 Azure RBAC 권한이 있는 사용자는 데이터 레이크 계층의 해당 작업 영역에 대해 Notebook을 실행할 수 있습니다. 자세한 내용은 Microsoft Sentinel의 역할 및 권한을 참조하세요.

분석 계층에서 새 사용자 지정 테이블을 만들려면 데이터 레이크 관리 ID에 Log Analytics 작업 영역에서 Log Analytics 기여자 역할이 할당되어야 합니다.

역할을 할당하려면 다음 단계를 수행합니다.

- Azure Portal에서 역할을 할당하려는 Log Analytics 작업 영역으로 이동합니다.

- 왼쪽 탐색 창에서 액세스 제어(IAM)를 선택합니다.

- 역할 할당 추가를 선택합니다.

- 역할 테이블에서 Log Analytics 기여자를 선택한 다음, 다음을 선택합니다.

- 관리 ID를 선택한 다음 멤버 선택을 선택합니다.

- 귀하의 데이터 레이크 관리 ID는

msg-resources-<guid>라는 이름이 지정된 시스템 할당 관리 ID입니다. 관리 ID를 선택한 다음, 선택을 선택합니다. - 검토 및 할당을 선택합니다.

관리 ID에 역할을 할당하는 방법에 대한 자세한 내용은 Azure Portal을 사용하여 Azure 역할 할당을 참조하세요.

Visual Studio Code 및 Microsoft Sentinel 확장 설치

Visual Studio Code가 아직 없는 경우 Mac, Linux 또는 Windows용 Visual Studio Code를 다운로드하여 설치 합니다.

VS Code(Visual Studio Code)용 Microsoft Sentinel 확장은 확장 마켓플레이스에서 설치됩니다. 확장을 설치하려면 다음 단계를 수행합니다.

- 왼쪽 도구 모음에서 확장 마켓플레이스를 선택합니다.

- Sentinel을 검색합니다.

- Microsoft Sentinel 확장을 선택하고 설치를 선택합니다.

- 확장이 설치되면 왼쪽 도구 모음에 Microsoft Sentinel 방패 아이콘이 나타납니다.

Visual Studio Code용 GitHub Copilot 확장을 설치하여 Notebook에서 코드 완성 및 제안을 사용하도록 설정합니다.

- 확장 마켓플레이스에서 GitHub Copilot 를 검색하여 설치합니다.

- 설치 후 GitHub 계정을 사용하여 GitHub Copilot에 로그인합니다.

데이터 레이크 계층 테이블 탐색

Microsoft Sentinel 확장을 설치한 후 데이터 레이크 계층 테이블을 탐색하고 Jupyter Notebook을 만들어 데이터를 분석할 수 있습니다.

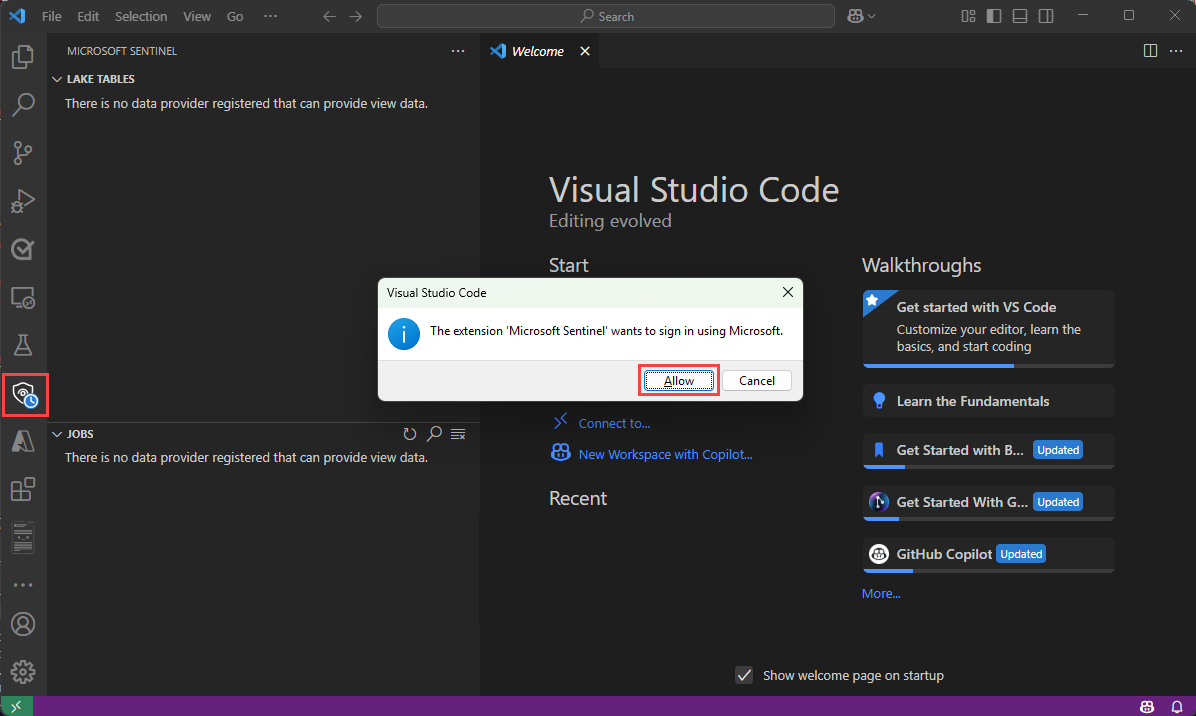

Microsoft Sentinel 확장에 로그인

왼쪽 도구 모음에서 Microsoft Sentinel 방패 아이콘을 선택합니다.

다음 텍스트와 함께 대화 상자가 나타납니다. "Microsoft Sentinel" 확장은 Microsoft를 사용하여 로그인하려고 합니다. 허용을 선택합니다.

계정 이름을 선택하여 로그인을 완료합니다.

데이터 레이크 테이블 및 작업 보기

로그인하면 Sentinel 확장의 왼쪽 창에 Lake 테이블과 작업 목록이 표시됩니다. 테이블은 데이터베이스 및 범주별로 그룹화됩니다. 테이블을 선택하여 열 정의를 확인합니다.

작업에 대한 자세한 내용은 작업 및 예약을 참조하세요.

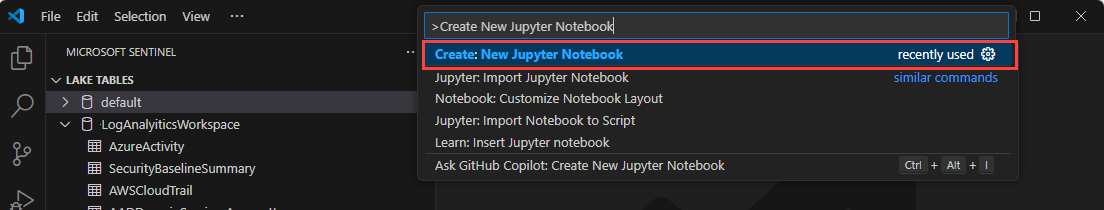

새 Notebook 만들기

새 Notebook을 만들려면 다음 방법 중 하나를 사용합니다.

검색 상자에 입력 > 하거나 Ctrl+Shift+P 를 누른 다음 새 Jupyter Notebook 만들기를 입력합니다.

새 Notebook에서 다음 코드를 첫 번째 셀에 붙여넣습니다.

from sentinel_lake.providers import MicrosoftSentinelProvider data_provider = MicrosoftSentinelProvider(spark) table_name = "EntraGroups" df = data_provider.read_table(table_name) df.select("displayName", "groupTypes", "mail", "mailNickname", "description", "tenantId").show(100, truncate=False)

편집기에서는 데이터 레이크의 MicrosoftSentinelProvider 클래스와 테이블 이름 모두에 대한 intellisense 코드 완성을 제공합니다.

실행 삼각형을 선택하여 Notebook에서 코드를 실행합니다. 결과는 코드 셀 아래의 출력 창에 표시됩니다.

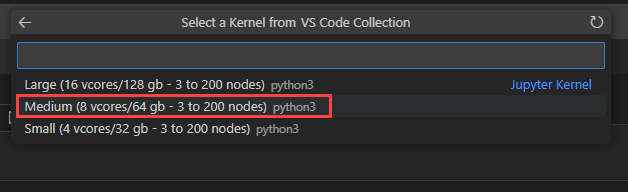

보통을 선택하여 중간 크기의 런타임 풀에서 Notebook을 실행합니다. 다른 런타임에 대한 자세한 내용은 적절한 Microsoft Sentinel 런타임 선택을 참조하세요.

비고

커널을 선택하면 Spark 세션이 시작되고 Notebook에서 코드가 실행됩니다. 풀을 선택한 후 세션을 시작하는 데 3-5분이 걸릴 수 있습니다. 세션이 이미 활성화되어 있으므로 후속 실행 속도가 더 빨라집니다.

세션이 시작되면 Notebook의 코드가 실행되고 결과가 코드 셀 아래의 출력 창에 표시됩니다(예:

Microsoft Sentinel 데이터 레이크와 상호 작용하는 방법을 보여 주는 샘플 노트북은 Microsoft Sentinel 데이터 레이크에 대한 샘플 노트북을 참조하세요.

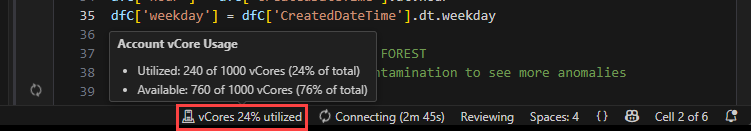

상태 표시줄

Notebook 아래쪽의 상태 표시줄은 Notebook의 현재 상태 및 Spark 세션에 대한 정보를 제공합니다. 상태 표시줄에는 다음 정보가 포함됩니다.

선택한 Spark 풀의 vCore 사용률 비율입니다. 사용된 vCore 수와 풀에서 사용할 수 있는 총 vCore 수를 보려면 백분율을 마우스로 가리킵니다. 백분율은 로그인한 계정에 대한 대화형 및 작업 워크로드의 현재 사용량을 나타냅니다.

Spark 세션의 연결 상태(예

Connecting: 또는ConnectedNot Connected.

세션 시간 제한 설정

대화형 Notebook에 대한 세션 시간 제한 및 시간 제한 경고를 설정할 수 있습니다. 시간 제한을 변경하려면 전자 필기장 아래쪽의 상태 표시줄에서 연결 상태를 선택합니다. 다음 옵션 중에서 선택합니다.

세션 제한 시간 설정: 세션 제한 시간(분)을 설정합니다. 기본값은 30분입니다.

세션 시간 제한 기간 다시 설정: 세션 시간 제한을 기본값인 30분으로 다시 설정합니다.

세션 제한 시간 경고 기간 설정: 세션 시간이 초과될 것이라는 경고가 표시되는 시간 제한(분)을 설정합니다. 기본값은 5분입니다.

세션 시간 제한 경고 기간 다시 설정: 세션 제한 시간 경고를 기본값인 5분으로 다시 설정합니다.

Notebook에서 GitHub Copilot 사용

GitHub Copilot를 사용하여 Notebook에서 코드를 작성할 수 있습니다. GitHub Copilot는 코드 컨텍스트에 따라 코드 제안 및 자동 완성을 제공합니다. GitHub Copilot를 사용하려면 Visual Studio Code에 GitHub Copilot 확장 이 설치되어 있는지 확인합니다.

Microsoft Sentinel 데이터 레이크용 샘플 노트북에서 코드를 복사하여 노트북 폴더에 저장하면 GitHub Copilot에 대한 문맥을 제공합니다. 그러면 GitHub Copilot는 Notebook의 컨텍스트에 따라 코드 완성을 제안할 수 있습니다.

다음 예제에서는 코드 검토를 생성하는 GitHub Copilot를 보여줍니다.

Microsoft Sentinel 공급자 클래스

Microsoft Sentinel 데이터 레이크에 연결하려면 클래스를 SentinelLakeProvider 사용합니다.

이 클래스는 모듈의 access_module.data_loader 일부이며 데이터 레이크와 상호 작용하는 메서드를 제공합니다. 이 클래스를 사용하려면 해당 클래스를 가져오고 세션을 사용하여 클래스의 인스턴스를 만듭니다 spark .

from sentinel_lake.providers import MicrosoftSentinelProvider

data_provider = MicrosoftSentinelProvider(spark)

사용 가능한 메서드에 대한 자세한 내용은 Microsoft Sentinel Provider 클래스 참조를 참조하세요.

적절한 런타임 풀 선택

Microsoft Sentinel 확장에서 Jupyter Notebook을 실행할 수 있는 세 개의 런타임 풀이 있습니다. 각 풀은 다양한 워크로드 및 성능 요구 사항을 위해 설계되었습니다. 런타임 풀 선택은 Spark 작업의 성능, 비용 및 실행 시간에 영향을 줍니다.

| 런타임 풀 | 권장 사용 사례 | 특징 |

|---|---|---|

| 소형 | 개발, 테스트 및 간단한 예비 분석. 간단한 변환을 사용하는 소규모 워크로드. 비용 효율성이 우선 순위가 지정되었습니다. |

소규모 워크로드에 적합 간단한 변환. 더 낮은 비용, 더 긴 실행 시간. |

| 중간 | 조인, 집계 및 ML 모델 학습을 사용하는 ETL 작업입니다. 복잡한 변환을 사용하여 워크로드를 조정합니다. |

Small보다 성능이 향상되었습니다. 병렬 처리 및 메모리를 많이 사용하는 작업을 처리합니다. |

| 대형 | 딥 러닝 및 ML 워크로드. 광범위한 데이터 이동, 대규모 결합 또는 실시간 처리 중요한 실행 시간입니다. |

높은 메모리 및 컴퓨팅 능력. 최소 지연. 크고 복잡하거나 시간이 중요한 워크로드에 가장 적합합니다. |

비고

처음 액세스할 때 커널 옵션을 로드하는 데 약 30초가 걸릴 수 있습니다.

런타임 풀을 선택한 후 세션을 시작하는 데 3~5분이 걸릴 수 있습니다.

메시지, 로그 및 오류 보기

메시지 로그 및 오류 메시지는 Visual Studio Code의 세 가지 영역에 표시됩니다.

출력 창입니다.

- 출력 창의 드롭다운에서 Microsoft Sentinel을 선택합니다.

- 자세한 로그 항목을 포함하려면 디버그 를 선택합니다.

Notebook의 인라인 메시지는 코드 셀 실행에 대한 피드백과 정보를 제공합니다. 이러한 메시지에는 이전 셀의 코드와 관련된 실행 상태 업데이트, 진행률 표시기 및 오류 알림이 포함됩니다.

알림 메시지라고도 하는 Visual Studio Code의 오른쪽 아래 모서리에 있는 알림 팝업은 Notebook 및 Spark 세션 내의 작업 상태에 대한 실시간 경고 및 업데이트를 제공합니다. 이러한 알림에는 Spark 세션에 대한 연결 성공, 시간 제한 경고와 같은 메시지, 경고 및 오류 경고가 포함됩니다.

작업 및 일정

Visual Studio Code용 Microsoft Sentinel 확장을 사용하여 특정 시간 또는 간격으로 작업을 실행하도록 예약할 수 있습니다. 작업을 사용하면 데이터 처리 작업을 자동화하여 Microsoft Sentinel 데이터 레이크의 데이터를 요약, 변환 또는 분석할 수 있습니다. 작업은 데이터 레이크 계층 또는 분석 계층의 사용자 지정 테이블에 데이터를 처리하고 결과를 쓰는 데도 사용됩니다. 작업을 만들고 관리하는 방법에 대한 자세한 내용은 Jupyter Notebook 작업 만들기 및 관리를 참조하세요.

VS Code Notebook에 대한 서비스 매개 변수 및 제한

다음 섹션에서는 VS Code Notebook을 사용할 때 Microsoft Sentinel 데이터 레이크에 대한 서비스 매개 변수 및 제한을 나열합니다.

| 카테고리 | 매개 변수/제한 |

|---|---|

| 분석 계층의 사용자 지정 테이블 | 분석 계층의 사용자 지정 테이블은 Notebook에서 삭제할 수 없습니다. Log Analytics를 사용하여 이러한 테이블을 삭제합니다. 자세한 내용은 Azure Monitor 로그에서 테이블 및 열 추가 또는 삭제를 참조하세요. |

| 게이트웨이 웹 소켓 시간 제한 | 2시간 |

| 대화형 쿼리 시간 제한 | 2시간 |

| 대화형 세션 비활성 시간 제한 | 20분 |

| 언어 | 파이썬 |

| Notebook 작업 시간 제한 | 8시간 |

| 최대 동시 Notebook 작업 | 3, 후속 작업이 큐에 대기됨 |

| 대화형 쿼리에서 최대 동시 사용자 수 | 큰 풀에서 8-10 |

| 세션 시작 시간 | Spark 컴퓨팅 세션을 시작하는 데 약 5-6분이 걸립니다. VS Code Notebook 아래쪽에서 세션의 상태를 볼 수 있습니다. |

| 지원되는 라이브러리 | 추상화된 함수에 대한 Azure Synapse 라이브러리 3.4 및 Microsoft Sentinel 공급자 라이브러리만 데이터 레이크 쿼리에 지원됩니다. Pip 설치 또는 사용자 지정 라이브러리는 지원되지 않습니다. |

| 레코드를 표시하는 VS Code UX 제한 | 100,000개 행 |

문제 해결

다음 표에서는 Notebook을 사용할 때 발생할 수 있는 일반적인 오류, 근본 원인 및 해결을 위한 제안된 작업을 나열합니다.

| 오류 범주 | 오류 이름 | 오류 코드 | 오류 메시지 | 권장 조치 |

|---|---|---|---|---|

| DatabaseError | 데이터베이스를 찾을 수 없음 (DatabaseNotFound) | 2001 | 데이터베이스 {DatabaseName}을(를) 찾을 수 없습니다. | 데이터베이스가 있는지 확인합니다. 데이터베이스가 새 데이터베이스인 경우 메타데이터 새로 고침을 기다립니다. |

| DatabaseError | 모호한데이터베이스이름 | 2002 | 여러 데이터베이스(ID: {DatabaseID1}, {DatabaseID2}, ...)는 이름 {DatabaseName}을(를) 공유합니다. 특정 데이터베이스 ID를 제공합니다. | 여러 데이터베이스의 이름이 같은 경우 데이터베이스 ID를 지정합니다. |

| DatabaseError | DatabaseIdMismatch | 2003 | 데이터베이스({DatabaseName}, ID {DatabaseID})를 찾을 수 없습니다. | 데이터베이스 이름과 ID를 모두 확인합니다. 데이터베이스 ID를 가져오려면 모든 데이터베이스를 나열합니다. |

| DatabaseError | 데이터베이스목록실패 | 2004 | 데이터베이스를 가져올 수 없습니다. 세션을 다시 시작하고 다시 시도합니다. | 세션을 다시 시작하고 몇 분 후에 작업을 다시 시도합니다. |

| TableError | 테이블이 존재하지 않습니다. | 2100 | 데이터베이스 {DatabaseName}에서 {TableName}을(를) 찾을 수 없습니다. | 테이블이 데이터베이스에 있는지 확인합니다. 테이블 또는 데이터베이스가 새로 추가된 경우 몇 분 정도 기다렸다가 다시 시도하세요. |

| 테이블 오류 | 프로비저닝 미완료 | 2101 | 테이블 {TableName}이(가) 준비되지 않았습니다. 몇 분 후에 다시 시도하십시오. | 테이블이 프로비전되고 있습니다. 몇 분 후에 다시 시도하십시오. |

| TableError | DeltaTableMissing | 2102 | 테이블 {TableName}이(가) 비어 있습니다. 새 테이블을 준비하는 데 최대 몇 시간이 걸릴 수 있습니다. | 분석 테이블을 데이터 레이크에 완전히 동기화하는 데 몇 시간이 걸릴 수 있습니다. 데이터 레이크에만 있는 테이블의 경우 데이터를 로드하거나 복원해야 하는지 확인합니다. |

| 테이블 오류 | 삭제를 위한 테이블이 존재하지 않음 | 2103 | 테이블을 삭제할 수 없습니다. 테이블 {TableName}을(를) 찾을 수 없습니다. | 테이블이 데이터베이스에 있는지 확인합니다. 테이블 또는 데이터베이스가 새로 추가된 경우 몇 분 정도 기다렸다가 다시 시도하세요. |

| 인증 실패 | SASToken 누락 | 2201 | 테이블에 액세스할 수 없습니다. 세션을 다시 시작하고 다시 시도합니다. | 테이블에 대한 액세스 토큰을 가져오는 동안 권한 부여에 실패했습니다. 세션을 다시 시작하고 다시 시도합니다. |

| 인증 실패 | InvalidSASToken | 2202 | 테이블에 액세스할 수 없습니다. 세션을 다시 시작하고 다시 시도합니다. | 테이블에 대한 액세스 토큰을 가져오는 동안 권한 부여에 실패했습니다. 세션을 다시 시작하고 다시 시도합니다. |

| 인증 실패 | 토큰 만료 | 2203 | 테이블에 액세스할 수 없습니다. 세션을 다시 시작하고 다시 시도합니다. | 테이블에 대한 액세스 토큰을 가져오는 동안 권한 부여에 실패했습니다. 세션을 다시 시작하고 다시 시도합니다. |

| 인증 실패 | 테이블_권한_부족 | 2204 | 데이터베이스 {DatabaseName}의 테이블 {TableName}에 필요한 액세스 권한입니다. | 테이블 또는 데이터베이스(작업 영역)에 대한 액세스를 요청하려면 관리자에게 문의하세요. |

| 인증 실패 | 내부 테이블 액세스 거부 | 2205 | {TableName} 테이블에 대한 액세스가 제한됩니다. | 시스템 또는 사용자가 정의한 테이블만 Notebook에서 액세스할 수 있습니다. |

| 인증 실패 | 테이블 인증 실패 | 2206 | 테이블에 데이터를 저장할 수 없습니다. 세션을 다시 시작하고 다시 시도합니다. | 테이블에 데이터를 저장하는 동안 권한 부여에 실패했습니다. 세션을 다시 시작하고 다시 시도합니다. |

| 구성 오류 (ConfigurationError) | Hadoop 설정 실패 | 2301 | 세션 구성을 업데이트할 수 없습니다. 세션을 다시 시작하고 다시 시도합니다. | 이 문제는 일시적이며 세션을 다시 시작하고 다시 시도하여 해결할 수 있습니다. 이 문제가 지속되면 지원에 문의하세요. |

| DataError | Json 파싱 오류 | 2302 | 테이블 메타데이터가 손상되었습니다. 지원 서비스에 문의하세요. | 지원 서비스에 문의하세요. 테넌트 ID, 테이블 이름 및 데이터베이스 이름을 제공합니다. |

| 테이블 스키마 오류 | 테이블스키마불일치 | 2401 | 대상 테이블에 열이 없습니다. DataFrame 스키마와 대상 테이블을 정렬하거나 덮어쓰기 모드를 사용합니다. | 대상 데이터베이스의 테이블과 일치하도록 DataFrame 스키마를 업데이트합니다. 테이블을 완전히 덮어쓰기 모드로 바꿀 수도 있습니다. |

| TableSchemaError | MissingRequiredColumns | 2402 | 데이터 프레임에서 {ColumnName} 열이 없습니다. DataFrame 스키마를 확인하고 대상 테이블과 정렬합니다. | 대상 데이터베이스의 테이블과 일치하도록 DataFrame 스키마를 업데이트합니다. 테이블을 완전히 덮어쓰기 모드로 바꿀 수도 있습니다. |

| 테이블 스키마 오류 | 열 유형 변경 불가 | 2403 | {ColumnName}열의 데이터 형식을 변경할 수 없습니다. | 열에는 데이터 형식 변경이 허용되지 않습니다. 대상 테이블의 기존 열을 확인하고 DataFrame의 모든 데이터 형식을 정렬합니다. |

| 테이블스키마오류 | ColumnNullabilityChangeNotAllowed | 2404 | {ColumnName}열의 null 허용 가능성을 변경할 수 없습니다. | 열의 Null 허용 여부 설정을 업데이트할 수 없습니다. 대상 테이블을 확인하고 설정을 DataFrame에 맞춥니다. |

| 데이터 삽입 오류 | 폴더 생성 실패 | 2501 | {TableName}테이블에 대한 스토리지를 만들 수 없습니다. | 이 문제는 일시적이며 세션을 다시 시작하고 다시 시도하여 해결할 수 있습니다. 이 문제가 지속되면 지원에 문의하세요. |

| 데이터 삽입 오류 | 하위 작업 요청 실패 | 2502 | {TableName}테이블에 대한 수집 작업을 만들 수 없습니다. | 이 문제는 일시적이며 세션을 다시 시작하고 다시 시도하여 해결할 수 있습니다. 이 문제가 지속되면 지원에 문의하세요. |

| 데이터 삽입 오류 | 서브 작업 생성 실패 | 2503 | {TableName}테이블에 대한 수집 작업을 만들 수 없습니다. | 이 문제는 일시적이며 세션을 다시 시작하고 다시 시도하여 해결할 수 있습니다. 이 문제가 지속되면 지원에 문의하세요. |

| InputError | 잘못된쓰기모드 | 2601 | 쓰기 모드가 잘못되었습니다. 추가 또는 덮어쓰기를 사용합니다. | DataFrame을 저장하기 전에 유효한 쓰기 모드(추가 또는 덮어쓰기)를 지정합니다. |

| InputError | PartitioningNotAllowed | 2602 | 분석 테이블을 분할할 수 없습니다. | 분석 테이블의 모든 열에 대한 분할을 제거합니다. |

| InputError | MissingTableSuffixLake | 2603 | 사용자 지정 테이블 이름이 잘못되었습니다. 데이터 레이크에 있는 사용자 지정 테이블의 모든 이름은 _SPRK 끝나야 합니다. | _SPRK 데이터 레이크에 쓰기 전에 테이블 이름에 접미사로 추가합니다. |

| InputError | MissingTableSuffixLA | 2604 | 사용자 지정 테이블 이름이 잘못되었습니다. 사용자 지정 분석 테이블의 모든 이름은 _SPRK_CL 끝나야 합니다. | 분석 스토리지에 쓰기 전에 테이블 이름에 접미사로 _SPRK_CL 추가합니다. |

| 알 수 없는 오류 | 내부 서버 오류 | 2901 | 오류가 발생했습니다. 세션을 다시 시작하고 다시 시도합니다. | 이 문제는 일시적이며 세션을 다시 시작하고 다시 시도하여 해결할 수 있습니다. 이 문제가 지속되면 지원에 문의하세요. |