Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Hinweis

Dieses Feature ist zurzeit als öffentliche Preview verfügbar. Diese Vorschauversion wird ohne Vereinbarung zum Servicelevel (SLA) bereitgestellt und ist nicht für Produktionsworkloads vorgesehen. Manche Features werden möglicherweise nicht unterstützt oder sind nur eingeschränkt verwendbar. Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

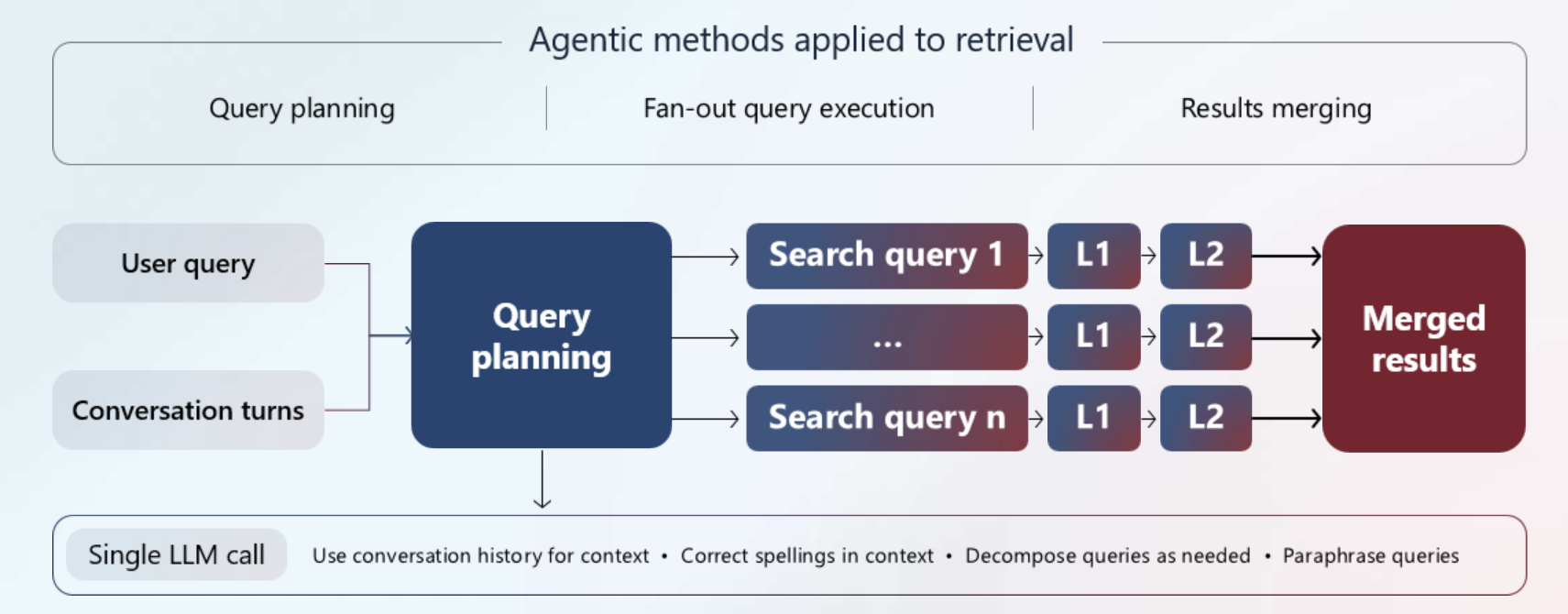

In Azure KI-Suche ist der Agent-Abruf eine neue Pipeline mit mehreren Abfragen, die für komplexe Fragen konzipiert ist, die von Benutzenden oder Agents in Chat- und Copilot-Apps gestellt werden. Es ist für Retrieval-Augmented-Generation (RAG) Muster vorgesehen. So funktioniert es:

Verwendet ein großes Sprachmodell (LLM), um eine komplexe Abfrage in kleinere, fokussierte Unterabfragen aufzuteilen, um eine bessere Abdeckung über Ihre indizierten Inhalte zu gewährleisten. Unterabfragen können den Chatverlauf für zusätzlichen Kontext enthalten.

Führt Unterabfragen parallel aus. Jede Unterabfrage wird semantisch neu bewertet, um die relevantesten Übereinstimmungen höherzustufen.

Kombiniert die besten Ergebnisse in einer einheitlichen Antwort, die ein LLM verwenden kann, um Antworten mit Ihren proprietären Inhalten zu generieren.

Diese leistungsstarke Pipeline hilft Ihnen, qualitativ hochwertige Grundlagendaten für Ihre Chatanwendung zu generieren, die es ermöglicht, komplexe Fragen schnell zu beantworten.

Programmgesteuert wird der agentische Abruf über ein neues Knowledge Agents-Objekt in der 2025-08-01-Preview und 2025-05-01-Preview-Datenebene REST-APIs und in Azure SDK-Vorschaupaketen unterstützt, die das Feature bereitstellen. Ein Wissen vom Agent-Abruf ist für die nachgelagerte Nutzung durch andere Agents und Chat-Apps vorgesehen.

Gründe für die Verwendung des Agent-Abrufs

Sie sollten den agentischen Abruf verwenden, wenn Sie Agents und Apps mit den relevantesten Inhalten für die Beantwortung schwierigerer Fragen bereitstellen möchten, den Chatkontext und Ihre proprietären Inhalte nutzen.

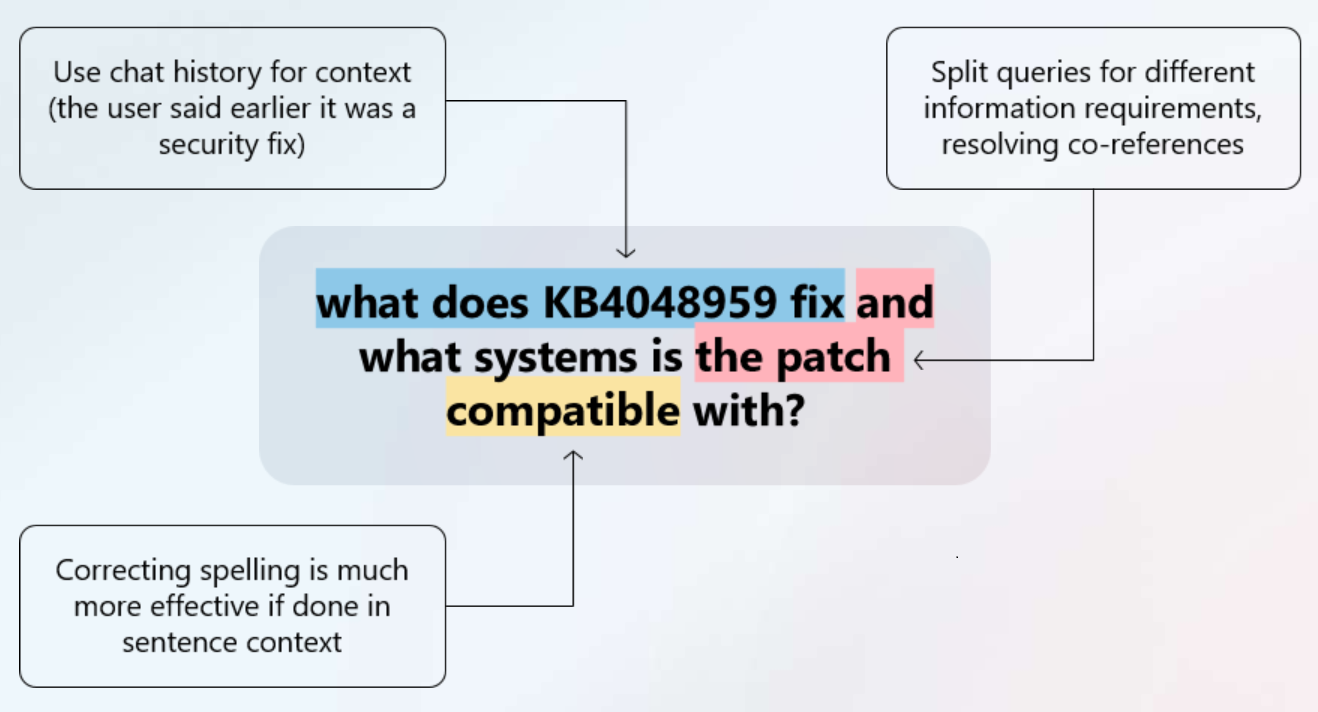

Der agentische Aspekt ist ein Schritt des logischen Denkens in der Verarbeitung der Abfrageplanung, der von einem unterstützten großangelegten Sprachmodell (LLM) ausgeführt wird, das Sie bereitstellen. Die LLM analysiert den gesamten Chatthread, um die zugrunde liegende Informationsanforderung zu identifizieren. Anstelle einer einzelnen Abfrage vom Typ „Alles erfassen“ unterteilt das LLM zusammengesetzte Fragen in fokussierte Unterabfragen basierend auf Benutzerfragen, Chatverlauf und Parameter der Anforderung. Die Unterabfragen zielen auf Ihre indizierten Dokumente (Nur-Text und Vektoren) in Azure AI Search ab. Dieser Hybridansatz stellt sicher, dass sowohl Schlüsselwortübereinstimmungen als auch semantische Ähnlichkeiten gleichzeitig angezeigt werden, was den Rückruf erheblich verbessert.

Die Abrufkomponente ist die Möglichkeit, Unterabfragen gleichzeitig auszuführen, Ergebnisse zusammenzuführen, ergebnisse semantisch zu rangieren und eine dreiteilige Antwort zurückzugeben, die Die Basisdaten für die nächste Unterhaltung umfasst, Referenzdaten, sodass Sie den Quellinhalt überprüfen können, und einen Aktivitätsplan, der Abfrageausführungsschritte anzeigt.

Abfrageerweiterung und parallele Ausführung sowie die Abrufantwort sind die wichtigsten Funktionen des agentischen Abrufs, die es zur besten Wahl für generative KI-Anwendungen (RAG) machen.

Der agentische Abruf fügt der Abfrageverarbeitung Latenz hinzu, macht dies jedoch durch Hinzufügen dieser Funktionen aus:

- Liest den Chatverlauf als Eingabe für die Abrufpipeline vor.

- Zerlegt eine komplexe Anfrage, die mehrere Anforderungen enthält, in ihre einzelnen Bestandteile. Beispiel: "Finde mir ein Hotel in der Nähe des Strandes, mit Flughafentransfer und das sich zu Fuß zu vegetarischen Restaurants befindet."

- Die ursprüngliche Abfrage wird mithilfe von Synonymzuordnungen (optional) und LLM-generierten Paraphrasierungen in mehrere Unterabfragen umgeschrieben.

- Korrigiert Rechtschreibfehler.

- Führt alle Unterabfragen gleichzeitig aus.

- Gibt ein einheitliches Ergebnis als einzelne Zeichenfolge aus. Alternativ können Sie Teile der Antwort für Ihre Lösung extrahieren. Metadaten zur Abfrageausführung und Referenzdaten sind in der Antwort enthalten.

Der Agent-Abruf ruft die gesamte Abfrageverarbeitungspipeline mehrmals für jede Unterabfrage auf. Dies geschieht jedoch parallel, wodurch Effizienz und Leistung beibehalten werden, die für ein akzeptables Benutzererlebnis erforderlich sind.

Hinweis

Das Einschließen eines LLM in die Abfrageplanung fügt einer Abfragepipeline Latenz hinzu. Sie können die Effekte verringern, indem Sie schnellere Modelle wie gpt-4o-mini verwenden und die Nachrichtenthreads zusammenfassen. Dennoch sollten Sie längere Abfragezeiten mit dieser Pipeline erwarten.

Architektur und Workflow

Der Agent-Abruf ist für Unterhaltungssuchumgebungen konzipiert, die ein LLM nutzen, um komplexe Abfragen intelligent zu unterteilen. Das System koordiniert mehrere Azure-Dienste, um umfassende Suchergebnisse bereitzustellen.

Funktionsweise

Der Agent-Abruf umfasst drei Hauptphasen:

Abfrageplanung: Ein Wissens-Agent sendet Ihren Abfrage- und Unterhaltungsverlauf an ein LLM (gpt-4o- oder gpt-4.1-Serie), das den Kontext analysiert und komplexe Fragen in fokussierte Unterabfragen unterteilt. Dieser Schritt ist automatisiert und kann nicht angepasst werden. Die Anzahl der Unterabfragen hängt davon ab, was die LLM entscheidet und ob der

maxDocsForRerankerParameter höher als 50 ist. Für jede Gruppe von 50 Dokumenten, die an den semantischen Rangierer gesendet wird, wird eine neue Unterabfrage definiert.Abfrageausführung: Alle Unterabfragen werden gleichzeitig für Ihre Wissensquellen mit Schlüsselwort, Vektor und Hybridsuche ausgeführt. Jede Unterabfrage durchläuft die semantische Neusortierung, um die relevantesten Übereinstimmungen zu finden. Verweise werden für Zitatzwecke extrahiert und für Zitate aufbewahrt.

Ergebnissynthese: Das System führt alle Ergebnisse zusammen, bewertet sie und gibt dann eine einheitliche Antwort zurück, die Groundingdaten, Quellverweise und Ausführungsmetadaten enthält.

Ihr Suchindex bestimmt die Abfrageausführung und alle Optimierungen, die während der Abfrageausführung auftreten. Insbesondere wenn Ihr Index durchsuchbare Text- und Vektorfelder enthält, wird eine Hybridabfrage ausgeführt. Die Indexsemantikkonfiguration sowie optionale Bewertungsprofile, Synonymzuordnungen, Analysemodule und Normalisierungsfunktionen (wenn Sie Filter hinzufügen) werden während der Abfrageausführung verwendet. Sie müssen benannte Standardwerte für eine semantische Konfiguration und ein Bewertungsprofil haben.

Erforderliche Komponenten

| Komponente | Dienstleistung | Rolle |

|---|---|---|

| LLM | Azure OpenAI | Erstellt Unterabfragen aus dem Unterhaltungskontext und verwendet später Groundingdaten für die Antwortgenerierung. |

| Wissens-Agent | Azure KI-Suche | Orchestriert die Pipeline und stellt dabei eine Verbindung mit Ihrem LLM her und verwaltet Abfrageparameter. |

| Suchindex | Azure KI-Suche | Speichert Ihre durchsuchbaren Inhalte (Text und Vektoren) mit semantischer Konfiguration. |

| Semantischer Sortierer | Azure KI-Suche | Erforderliche Komponente, die Ergebnisse nach Relevanz neu sortiert (L2-Neusortierung) |

| Wissensquelle | Azure KI-Suche | Umschließt den Suchindex mit Eigenschaften, die sich auf die Verwendung von Wissens-Agent beziehen |

Integrationsanforderungen

Ihre Anwendung steuert die Pipeline, indem sie den Wissens-Agent aufruft und die Antwort verarbeitet. Die Pipeline gibt Groundingdaten zurück, die Sie zur Antwortgenerierung in Ihrer Unterhaltungsschnittstelle an ein LLM übergeben. Details zur Implementierung finden Sie unter Erstellen einer Agent-zu-Agent-Abruflösung.

Hinweis

Für die Abfrageplanung werden nur Modelle der gpt-4o- und gpt-4.1-Serie unterstützt. Sie können ein beliebiges Modell für die endgültige Antwortgenerierung verwenden.

Einstieg

Sie müssen die Vorschau-REST-APIs oder ein Vorabversions-Azure SDK-Paket verwenden, das die Funktionalität bereitstellt. Derzeit gibt es keine Azure-Portal- oder Azure AI Foundry-Portalunterstützung.

Wählen Sie eine dieser Optionen für den nächsten Schritt aus.

Schnellstartartikel: Ausführen des agentischen Abrufs in Azure AI Search. Lernen Sie den grundlegenden Workflow mithilfe von Beispieldaten und einem vorbereiteten Index und Abfragen kennen.

Beispielcode:

Anleitungen für einen fokussierten Blick auf Entwicklungsaufgaben:

REST-API-Referenz:

Azure OpenAI Demo, aktualisiert für die Verwendung des agentischen Abrufs.

Verfügbarkeit und Preise

Agentisches Abrufen ist in allen Regionen, die einen semantischen Ranker bereitstellen, verfügbar, für alle Stufen außer der kostenlosen Stufe.

Die Abrechnung für den Agent-Abruf besteht aus zwei Teilen:

Die Abrechnung für die Abfrageplanung und Antwortsynthese (optional) ist pay-as-you-go in Azure OpenAI. Es ist tokenbasiert für Eingabe- und Ausgabetoken. Das Modell, das Sie dem Wissens-Agent zuweisen, wird für die Tokenverwendung abgerechnet. Wenn Sie beispielsweise gpt-4o verwenden, wird die Tokengebühr in der Rechnung für gpt-4o angezeigt.

Die Abrechnung für die semantische Sortierung erfolgt während der Abfrageausführung. Die Abrechnung wird während der Einführungsphase ausgesetzt. Anschließend erfolgt ein Wechsel auf die nutzungsbasierte Bezahlung über den semantischen Sortierer aufseiten von Azure KI-Suche. Der semantische Sortierer ist ein Feature, das nach dem Premium-Tarif abgerechnet wird und ein integraler Bestandteil des Agent-Abrufs ist. Ihnen werden aufseiten von Azure KI-Suche die Tokeneingaben für die Modelle des semantischen Sortierers in Rechnung gestellt.

Die semantische Rangfolge wird für jede Unterabfrage im Plan ausgeführt. Semantische Ranglisten-Gebühren richten sich nach der Anzahl der Token, die jede Unterabfrage zurückgibt.

| Aspekt | Klassische Pipeline mit einer Abfrage | Pipeline mit Agent-Abruf und mehreren Abfragen |

|---|---|---|

| Einheit | Abfragebasiert (1.000 Abfragen) pro Währungseinheit | Tokenbasiert (1 Millionen Token pro Währungseinheit) |

| Kosten pro Einheit | Einheitliche Kosten pro Abfrage | Einheitliche Kosten pro Token |

| Cost Estimation (Kostenvorkalkulation) | Anzahl der Geschätzten Abfragen | Tokenverbrauch schätzen |

| Kostenlose Stufe | 1.000 kostenlose Abfragen | 50 Millionen kostenlose Token |

Hinweis

Die derzeitige Abrechnung des semantischen Sortierers bleibt unverändert, wenn Sie ihn außerhalb des Agent-Abrufs verwenden. Informationen zum Preis ohne Agent-Abruf finden Sie auf der Azure AI Search-Preisseite.

Beispiel: Schätzen der Kosten

Agentischer Abruf verfügt über zwei Abrechnungsmodelle: Abrechnung von Azure OpenAI (Abfrageplanung und, wenn aktiviert, Antwortsynthese) und Abrechnung von Azure AI Search für semantische Rangfolge (Abfrageausführung).

In diesem Beispiel wird die Antwortsynthese weggelassen und hypothetische Preise verwendet, um den Schätzungsprozess zu veranschaulichen. Ihre Kosten können niedriger ausfallen. Informationen zum tatsächlichen Preis von Transaktionen finden Sie unter Azure OpenAI-Preise. Für die Abfrageausführung fallen während der Public Preview keine Gebühren für den semantischen Sortierer beim Agent-Abruf an.

Geschätzte Abrechnungskosten für die Abfrageplanung

Um die Kosten für den Abfrageplan bei nutzungsbasierter Bezahlung in Azure OpenAI zu schätzen, wird im Folgenden von gpt-4o-mini ausgegangen:

- 15 Cent für 1 Millionen Eingabetoken.

- 60 Cent für 1 Mio. Ausgabetoken

- 2.000 Eingabetoken für die durchschnittliche Chat-Gesprächsgröße.

- 350 Token für die durchschnittliche Ausgabeplangröße

Geschätzte Abrechnungskosten für die Abfrageausführung

Um die mit dem agentischen Abruf verbundenen semantischen Bewertungskosten zu schätzen, beginnen Sie mit einer Vorstellung davon, wie ein durchschnittliches Dokument in Ihrem Index aussieht. Beispielsweise kann Folgendes angenommen werden:

- 10.000 Blöcke, wobei jeder Block ein bis zwei Absätze einer PDF-Datei ist.

- 500 Token pro Block.

- Jede Unterabfrage bewertet bis zu 50 Datenblöcke neu.

- Im Durchschnitt gibt es drei Unterabfragen pro Abfrageplan.

Berechnung des Preises der Ausführung

Nehmen wir an, wir führen 2.000 agentenbasierte Abfragen mit drei Unterabfragen pro Plan durch. Dies gibt uns ca. 6.000 Gesamtabfragen.

Neusortierung in 50 Blöcken pro Unterabfrage, also 300.000 Blöcke insgesamt

Der durchschnittliche Teil besteht aus 500 Token, sodass die Gesamttoken für die Neusortierung 150 Millionen betragen.

Angesichts eines hypothetischen Preises von 0,022 pro Token beträgt der Gesamtkostenbetrag für das Reranking 3,30 US-Dollar.

Die Kosten für den Abfrageplan: 2.000 Eingabetoken multipliziert mit 2.000 agentischen Abrufen entsprechen 4 Millionen Eingabetoken für insgesamt 60 Cent.

Schätzen Sie die Ausgabekosten basierend auf einem Durchschnitt von 350 Token. Wenn wir 350 mit 2.000 agentischen Abrufen multiplizieren, erhalten wir insgesamt 700.000 Ausgabetoken für insgesamt 42 Cent.

Insgesamt zahlen Sie etwa 3,30 $ für die semantische Rangfolge in Azure AI Search, 60 Cent für Eingabetoken in Azure OpenAI und 42 Cent für Ausgabetoken in Azure OpenAI, was insgesamt 1,02 $ für die gesamte Abfrageplanung ergibt. Die kombinierten Kosten für die vollständige Ausführung betragen 4,32 $.