Azure AI Foundry リソースで推論に使用できるモデルを決定して構成できます。 特定のモデルが構成されたら、要求でそのモデル名またはデプロイ名を指定することで、そこから予測を生成できます。 これを使用するためにコードをさらに変更する必要はありません。

この記事では、Azure AI Foundry に新しいモデルを追加する方法について説明します。

[前提条件]

この記事を完了するには、以下が必要です。

Azure サブスクリプション。 GitHub モデルを使用している場合は、エクスペリエンスをアップグレードし、プロセスで Azure サブスクリプションを作成できます。 その場合は、 GitHub モデルから Azure AI Foundry モデルへのアップグレード に関するページを参照してください。

Azure AI Foundry リソース (旧称 Azure AI Services)。 詳細については、「 Azure AI Foundry Models のすべてのリソースを作成して構成する」を参照してください。

パートナーとコミュニティのモデルには、Azure Marketplace へのアクセスが必要です。 モデル オファリングをサブスクライブするために必要なアクセス許可があることを確認します。 Azure によって直接販売されるモデル には、この要件はありません。

Azure AI Foundry Models サービスにモデルをデプロイする機能を使用 して、Azure AI Foundry リソースに 接続されている AI プロジェクト。

- Azure AI Foundry のプロジェクトの Foundry Models サービスの構成に関する ページの手順に従うことができます。

モデルの追加

次の手順を使用して、Foundry Models エンドポイントにモデルを追加できます。

Azure AI Foundry ポータル内の [モデルカタログ] セクションに移動します。

関心のあるモデルまでスクロールして選択します。

モデル カードでモデルの詳細を確認できます。

[デプロイ] を選択します。

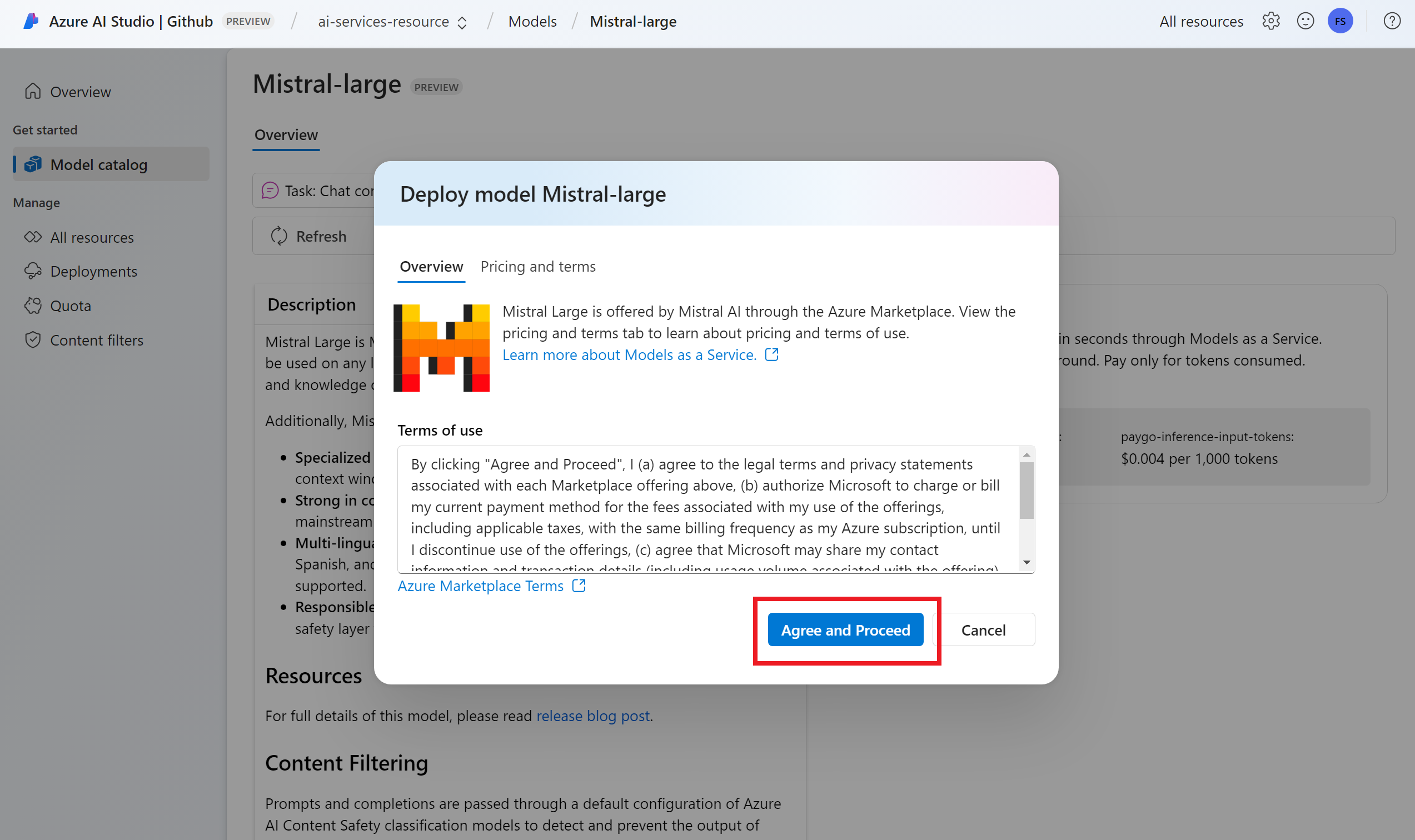

追加の契約条件が必要なモデル プロバイダーの場合は、それらの条件に同意するように求められます。 たとえば、Mistral モデルがこのケースです。 [サブスクリプションとデプロイ] を選択して、これらのケースの使用条件に同意します。

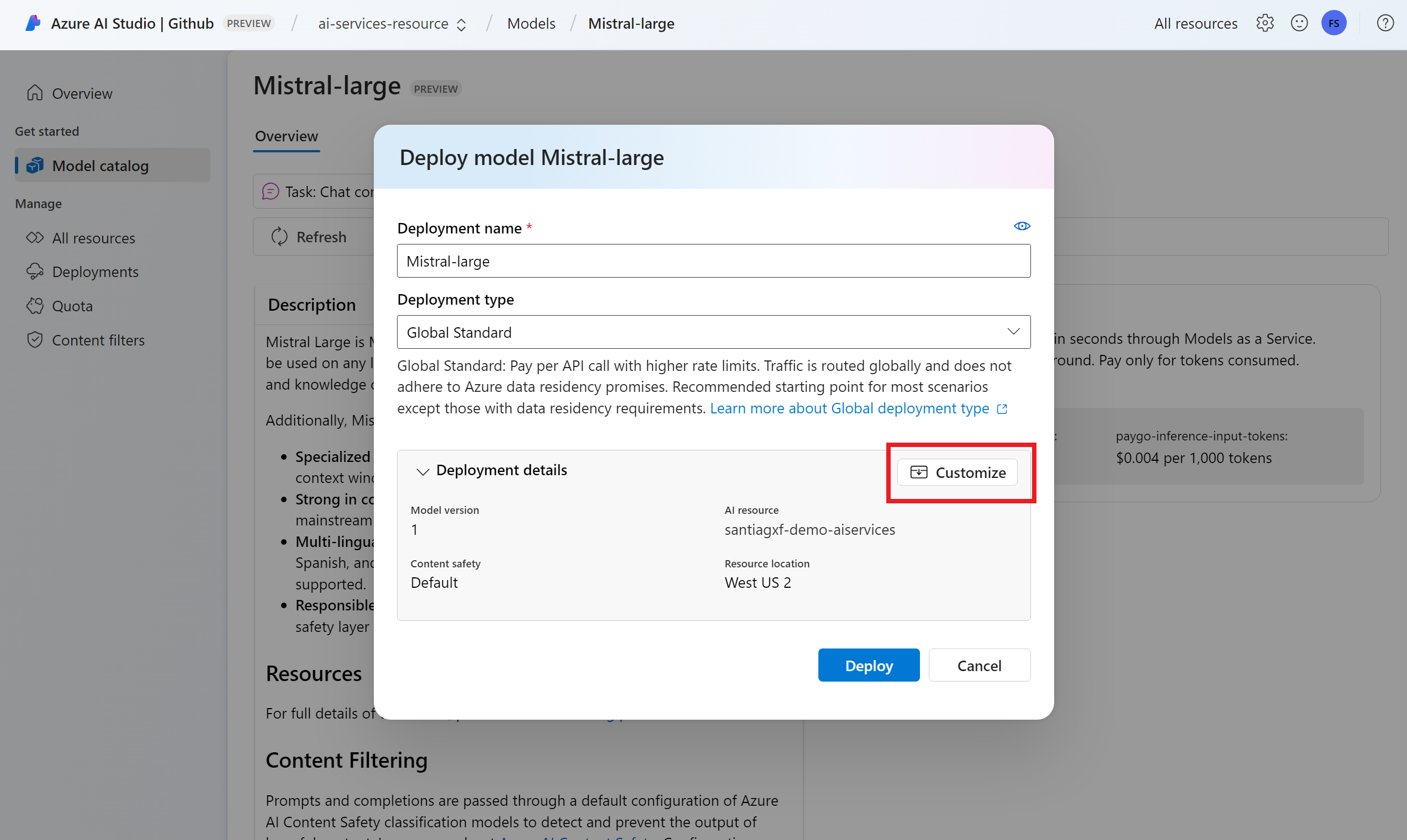

この時点でデプロイ設定を構成できます。 既定では、デプロイはデプロイするモデルの名前を受け取ります。 デプロイ名は、この特定のモデル デプロイにルーティングする要求の

modelパラメーターで使用されます。 これにより、特定の構成をアタッチする際に、そのモデルに特定の名前を構成することもできます。 たとえば、厳密なコンテンツ フィルターを使用するモデルのo1-preview-safe。ヒント

各モデルはさまざまな種類のデプロイをサポートでき、異なるデータ所在地またはスループットの保証が提供されます。 詳細については、デプロイの種類に関するページを参照してください。

プロジェクトに応じて、Azure AI Foundry 接続が自動的に選択されます。 [カスタマイズ] オプションを使用し、ニーズに基づいて接続を変更します。 サーバーレス API デプロイの種類でデプロイする場合は、Azure AI Foundry リソースのリージョンでモデルを使用できる必要があります。

ヒント

目的のリソースが一覧にない場合は、それへの接続の作成が必要になることがあります。 Azure AI Foundry ポータルのプロジェクトで Azure AI Foundry モデルを構成するを参照してください。

[デプロイ] を選択します。

デプロイが完了すると、新しいモデルがページ内の一覧に表示され、使用する準備が整います。

モデルを管理する

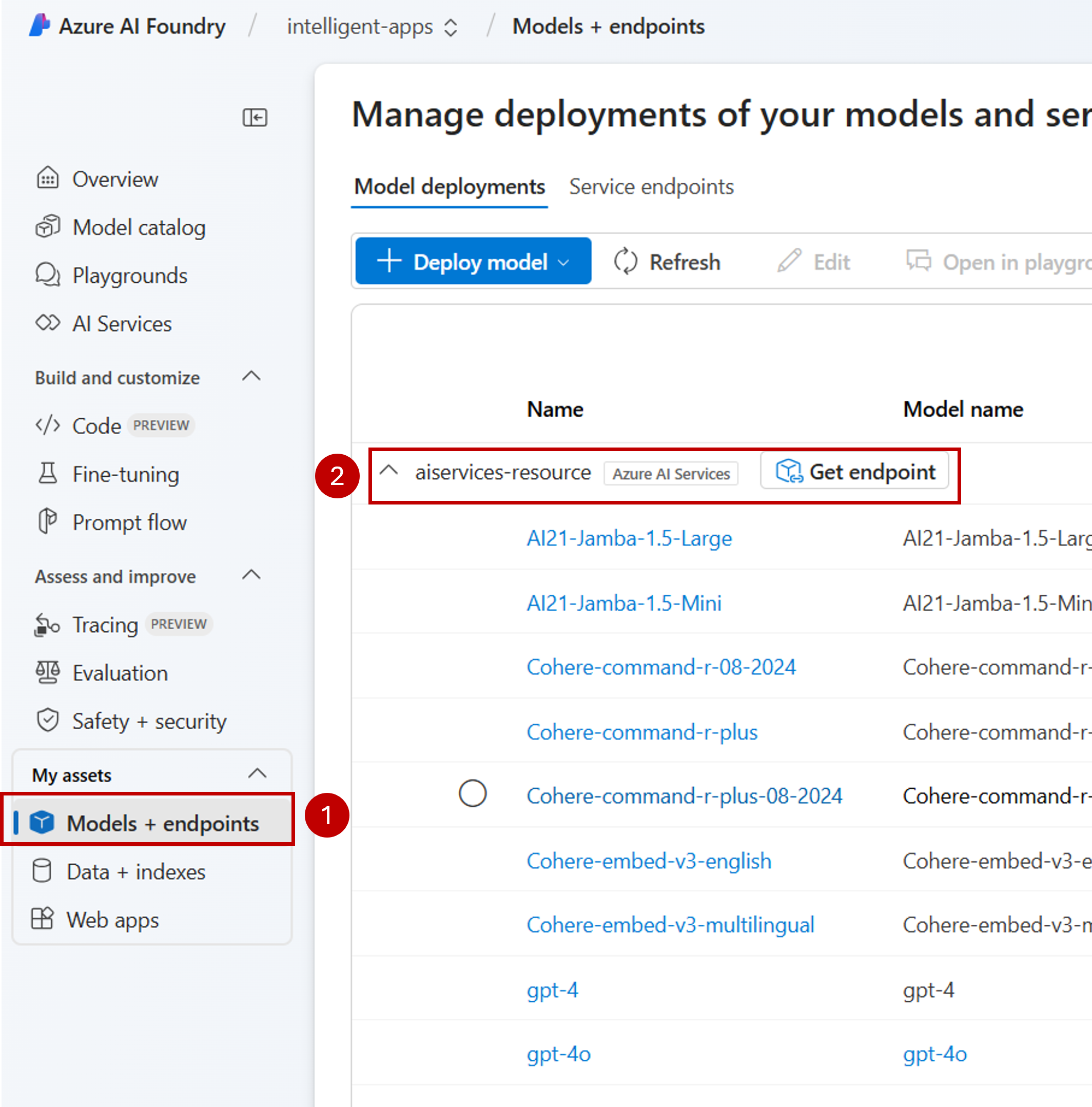

Azure AI Foundry ポータルを使用して、リソース内の既存のモデル デプロイを管理できます。

Azure AI Foundry ポータル内の [モデル + エンドポイント] セクションに移動します。

Azure AI Foundry リソースへの接続までスクロールします。 モデル デプロイは、接続ごとにグループ化され、表示されます。

各接続で使用可能なモデルの一覧が表示されます。 関心のあるモデル デプロイを選択します。

必要に応じて、デプロイを [編集] または [削除] します。

プレイグラウンドでデプロイをテストする

プレイグラウンドを使用して、Azure AI Foundry ポータルで新しいモデルを操作できます。

注

プレイグラウンドは、Azure AI Foundry で AI プロジェクトを操作する場合にのみ使用できます。 Azure AI Foundry のすべての機能へのフル アクセスを取得するための AI プロジェクトを作成します。

Azure AI Foundry ポータルの [プレイグランド] セクションに移動します。

デプロイしたモデルの種類に応じて、必要なプレイグラウンドを選択します。 この場合は、[チャット プレイグラウンド] を選択します。

[デプロイ] ドロップダウンの [設定] の下で、作成したモデル デプロイの名前を選択します。

プロンプトを入力し、出力を表示します。

さらに、[コードの表示] を使用できるため、プログラムでモデル デプロイにアクセスする方法の詳細を確認することができます。

Azure AI Foundry リソースで推論に使用できるモデルを決定して構成できます。 特定のモデルが構成されたら、要求でそのモデル名またはデプロイ名を指定することで、そこから予測を生成できます。 これを使用するためにコードをさらに変更する必要はありません。

この記事では、Azure AI Foundry に新しいモデルを追加する方法について説明します。

[前提条件]

この記事を完了するには、以下が必要です。

Azure サブスクリプション。 GitHub モデルを使用している場合は、エクスペリエンスをアップグレードし、プロセスで Azure サブスクリプションを作成できます。 その場合は、 GitHub モデルから Azure AI Foundry モデルへのアップグレード に関するページを参照してください。

Azure AI Foundry リソース (旧称 Azure AI Services)。 詳細については、「 Azure AI Foundry Models のすべてのリソースを作成して構成する」を参照してください。

パートナーとコミュニティのモデルには、Azure Marketplace へのアクセスが必要です。 モデル オファリングをサブスクライブするために必要なアクセス許可があることを確認します。 Azure によって直接販売されるモデル には、この要件はありません。

Azure AI サービスの Azure CLI と

cognitiveservices拡張機能をインストールします。az extension add -n cognitiveservicesこのチュートリアル内の一部のコマンドでは、ユーザーのシステムにインストールされていない場合がある

jqツールを使用します。 インストール手順については、ダウンロードjqを参照してください。次の情報を特定します。

Azure のサブスクリプション ID。

Azure AI サービス リソース名。

Azure AI サービス リソースがデプロイされているリソース グループ。

モデルの追加

モデルを追加するには、まずデプロイするモデルを特定する必要があります。 使用可能なモデルに対しては、次のようにクエリを実行できます。

Azure サブスクリプションにログインします。

az login複数のサブスクリプションがある場合は、リソースが配置されているサブスクリプションを選択します。

az account set --subscription $subscriptionId使用する予定の Azure AI サービス リソースとリソース グループの名前を使用して、次の環境変数を設定します。

accountName="<ai-services-resource-name>" resourceGroupName="<resource-group>" ___location="eastus2"Azure AI サービス アカウントをまだ作成していない場合は、次のように作成できます。

az cognitiveservices account create -n $accountName -g $resourceGroupName --custom-___domain $accountName --___location $___location --kind AIServices --sku S0まず、使用可能なモデルと、どの SKU かを見てみましょう。 SKU ( デプロイの種類とも呼ばれます) は、Azure インフラストラクチャを使用して要求を処理する方法を定義します。 モデルでは、さまざまなデプロイの種類が提供される場合があります。 次のコマンドは、使用可能なすべてのモデル定義を一覧表示します。

az cognitiveservices account list-models \ -n $accountName \ -g $resourceGroupName \ | jq '.[] | { name: .name, format: .format, version: .version, sku: .skus[0].name, capacity: .skus[0].capacity.default }'出力は次のようになります。

{ "name": "Phi-3.5-vision-instruct", "format": "Microsoft", "version": "2", "sku": "GlobalStandard", "capacity": 1 }デプロイするモデルを特定します。 必要なプロパティは

name、format、version、skuです。 プロパティformatは、モデルを提供するプロバイダーを示します。 デプロイの種類によっては、容量も必要になる場合があります。モデル デプロイをリソースに追加します。 次の例では、

Phi-3.5-vision-instructを追加します。az cognitiveservices account deployment create \ -n $accountName \ -g $resourceGroupName \ --deployment-name Phi-3.5-vision-instruct \ --model-name Phi-3.5-vision-instruct \ --model-version 2 \ --model-format Microsoft \ --sku-capacity 1 \ --sku-name GlobalStandardモデルを実行する準備ができました。

別のデプロイ名を付ける限り、必要に応じて、同じモデルを複数回デプロイできます。 この機能は、コンテンツ フィルターなど、特定のモデルのさまざまな構成をテストする場合に役立ちます。

モデルを使用する

デプロイされたモデルは、リソースに対する Azure AI モデルの推論エンドポイント を使用して使用できます。 要求を作成する際に、パラメーター model を指定し、作成したモデル デプロイ名を挿入します。 次のコードを使用して、推論エンドポイントの URI をプログラムで取得できます。

推論エンドポイント

az cognitiveservices account show -n $accountName -g $resourceGroupName | jq '.properties.endpoints["Azure AI Model Inference API"]'

Azure AI Foundry Models エンドポイントに要求を行うには、ルート models ( https://<resource>.services.ai.azure.com/modelsなど) を追加します。 エンドポイントの API リファレンスについては、 Azure AI モデル推論 API リファレンス ページを参照してください。

推論キー

az cognitiveservices account keys list -n $accountName -g $resourceGroupName

展開を管理する

CLI を使用すると、使用可能なすべてのデプロイを表示できます。

次のコマンドを実行して、アクティブなすべてのデプロイを表示します。

az cognitiveservices account deployment list -n $accountName -g $resourceGroupName特定のデプロイの詳細を表示できます。

az cognitiveservices account deployment show \ --deployment-name "Phi-3.5-vision-instruct" \ -n $accountName \ -g $resourceGroupName特定のデプロイは次のように削除できます。

az cognitiveservices account deployment delete \ --deployment-name "Phi-3.5-vision-instruct" \ -n $accountName \ -g $resourceGroupName

Azure AI Foundry リソースで推論に使用できるモデルを決定して構成できます。 特定のモデルが構成されたら、要求でそのモデル名またはデプロイ名を指定することで、そこから予測を生成できます。 これを使用するためにコードをさらに変更する必要はありません。

この記事では、Azure AI Foundry に新しいモデルを追加する方法について説明します。

[前提条件]

この記事を完了するには、以下が必要です。

Azure サブスクリプション。 GitHub モデルを使用している場合は、エクスペリエンスをアップグレードし、プロセスで Azure サブスクリプションを作成できます。 その場合は、 GitHub モデルから Azure AI Foundry モデルへのアップグレード に関するページを参照してください。

Azure AI Foundry リソース (旧称 Azure AI Services)。 詳細については、「 Azure AI Foundry Models のすべてのリソースを作成して構成する」を参照してください。

パートナーとコミュニティのモデルには、Azure Marketplace へのアクセスが必要です。 モデル オファリングをサブスクライブするために必要なアクセス許可があることを確認します。 Azure によって直接販売されるモデル には、この要件はありません。

Azure CLI をインストールします。

次の情報を特定します。

Azure のサブスクリプション ID。

あなたの Azure AI Foundry (旧称 Azure AI Services) リソース名。

Azure AI Foundry リソースがデプロイされているリソース グループ。

デプロイするモデル名、プロバイダー、バージョン、SKU。 これは、Azure AI Foundry ポータルまたは Azure CLI を使用して特定できます。 この例では、次のモデルをデプロイします。

- モデル名::

Phi-3.5-vision-instruct - プロバイダー:

Microsoft - バージョン:

2 - デプロイの種類: グローバル標準

- モデル名::

このチュートリアルについて

この記事の中の例は、Azure-Samples/azureai-model-inference-bicep リポジトリに含まれるサンプル コードに基づいています。 ファイル内容のコピーや貼り付けをする必要なく、ローカル環境でコマンドを実行するには、次のコマンドを使用してリポジトリをクローンし、そのコーディング言語のフォルダーに移動します。

git clone https://github.com/Azure-Samples/azureai-model-inference-bicep

この例のファイルは、次の場所にあります。

cd azureai-model-inference-bicep/infra

パートナーやコミュニティからモデルを購読するために必要なアクセス許可

デプロイに使用できるパートナーとコミュニティのモデル (Cohere モデルなど) には、Azure Marketplace が必要です。 モデル プロバイダーは、ライセンス条項を定義し、Azure Marketplace を使用してモデルを使用するための価格を設定します。

サード パーティ製モデルをデプロイする場合は、アカウントに次のアクセス許可があることを確認します。

- Azure サブスクリプションで次の手順を実行します。

Microsoft.MarketplaceOrdering/agreements/offers/plans/readMicrosoft.MarketplaceOrdering/agreements/offers/plans/sign/actionMicrosoft.MarketplaceOrdering/offerTypes/publishers/offers/plans/agreements/readMicrosoft.Marketplace/offerTypes/publishers/offers/plans/agreements/readMicrosoft.SaaS/register/action

- リソース グループで、SaaS リソースを作成して使用するには、次の手順を実行します。

Microsoft.SaaS/resources/readMicrosoft.SaaS/resources/write

モデルの追加

テンプレート

ai-services-deployment-template.bicepを使用して、モデル デプロイについて説明します。ai-services-deployment-template.bicep

@description('Name of the Azure AI services account') param accountName string @description('Name of the model to deploy') param modelName string @description('Version of the model to deploy') param modelVersion string @allowed([ 'AI21 Labs' 'Cohere' 'Core42' 'DeepSeek' 'Meta' 'Microsoft' 'Mistral AI' 'OpenAI' ]) @description('Model provider') param modelPublisherFormat string @allowed([ 'GlobalStandard' 'Standard' 'GlobalProvisioned' 'Provisioned' ]) @description('Model deployment SKU name') param skuName string = 'GlobalStandard' @description('Content filter policy name') param contentFilterPolicyName string = 'Microsoft.DefaultV2' @description('Model deployment capacity') param capacity int = 1 resource modelDeployment 'Microsoft.CognitiveServices/accounts/deployments@2024-04-01-preview' = { name: '${accountName}/${modelName}' sku: { name: skuName capacity: capacity } properties: { model: { format: modelPublisherFormat name: modelName version: modelVersion } raiPolicyName: contentFilterPolicyName == null ? 'Microsoft.Nill' : contentFilterPolicyName } }デプロイを実行します。

RESOURCE_GROUP="<resource-group-name>" ACCOUNT_NAME="<azure-ai-model-inference-name>" MODEL_NAME="Phi-3.5-vision-instruct" PROVIDER="Microsoft" VERSION=2 az deployment group create \ --resource-group $RESOURCE_GROUP \ --template-file ai-services-deployment-template.bicep \ --parameters accountName=$ACCOUNT_NAME modelName=$MODEL_NAME modelVersion=$VERSION modelPublisherFormat=$PROVIDER

モデルを使用する

デプロイされたモデルは、リソースに対する Azure AI モデルの推論エンドポイント を使用して使用できます。 要求を作成する際に、パラメーター model を指定し、作成したモデル デプロイ名を挿入します。