データフローは、コードを記述せずにデータを準備および変換するのに役立つクラウドベースのツールです。 数百のデータ ソースからデータを取り込み、300 以上のデータ変換を使用してデータを変換し、結果のデータを複数の変換先に読み込むためのローコード インターフェイスが用意されています。 何百もの異なるデータ ソースに接続し、乱雑なデータをクリーンアップし、必要な場所に正確に配信できる個人データ アシスタントと考えてください。 市民でもプロの開発者でも、データフローは、データベース、データ ウェアハウス、Lakehouse、リアルタイム データなどの豊富なデータ ソースからデータを取り込み、準備し、変換するための最新のデータ統合エクスペリエンスを提供します。

Dataflow Gen2 は、元の Power BI データフロー (現在は Gen1 と呼ばれる) と共に動作する、より新しい、より強力なバージョンです。 Excel、Power BI、Power Platform、Dynamics 365 など、Microsoft の複数の製品やサービスで利用できる使い慣れた Power Query エクスペリエンスを使用して構築された Dataflow Gen2 では、データを迅速に取り込んで変換するための強化された機能、パフォーマンスの向上、高速コピー機能が提供されます。 新たに開始する場合は、強化された機能とパフォーマンスを向上させるために、Dataflow Gen2 をお勧めします。

データフローでできること

データフローを使用すると、次のことができます。

- データに接続する: データベース、ファイル、Web サービスなどの情報をプルします。

- データを変換する: ビジュアル インターフェイスを使用して、データのクリーンアップ、フィルター処理、結合、整形を行います。

- 任意の場所にデータを読み込む: 変換されたデータをデータベース、データ ウェアハウス、またはクラウド ストレージに送信します。

- プロセスを自動化する: データが最新で up-toされるようにスケジュールを設定します。

データフロー機能

データフロー Gen2 と Gen1 の間で使用できる機能を次に示します。

| 特徴 | データフロー Gen2 | データフロー Gen1 |

|---|---|---|

| Power Query を使用してデータフローを作成する | ✓ | ✓ |

| よりシンプルな作成プロセス | ✓ | |

| 自動保存とバックグラウンド発行 | ✓ | |

| 複数の出力先 | ✓ | |

| モニタリングと更新追跡の改善 | ✓ | |

| パイプラインを使用する | ✓ | |

| ハイ パフォーマンス コンピューティング | ✓ | |

| データフロー コネクタ経由で接続する | ✓ | ✓ |

| データフロー コネクタを使用した直接クエリ | ✓ | |

| 変更されたデータのみを更新する | ✓ | ✓ |

| AI を利用した分析情報 | ✓ |

Dataflow Gen2 へのアップグレード

次のセクションでは、データ準備タスクをより簡単かつ効率的にするために、Dataflow Gen2 の主要な機能強化の一部を Gen1 と比較します。

Gen2 は簡単に作成して使用できます

データフロー Gen2 は、以前に Power Query を使用したことがあればよく知られています。 迅速に稼働を開始できるように、プロセスを簡素化しました。 データフローにデータを取り込む際に、手順を追って説明し、データフローの作成に必要な手順の数を減らしました。

自動保存によって作業の安全性が維持される

Dataflow Gen2 では、作業中に変更が自動的に保存されます。 コンピューターから離れるか、ブラウザーを閉じるか、進行状況を失うことを心配せずにインターネット接続を失うことができます。 あなたが戻ってきた時に、すべてがそのままです。

データフローの構築が完了したら、変更を発行できます。 発行すると作業が保存され、バックグラウンド検証が実行されるため、次のタスクに進む前に、すべてがチェックアウトされるのを待つ必要はありません。

保存のしくみの詳細については、「 データフローの下書きを保存する」を参照してください。

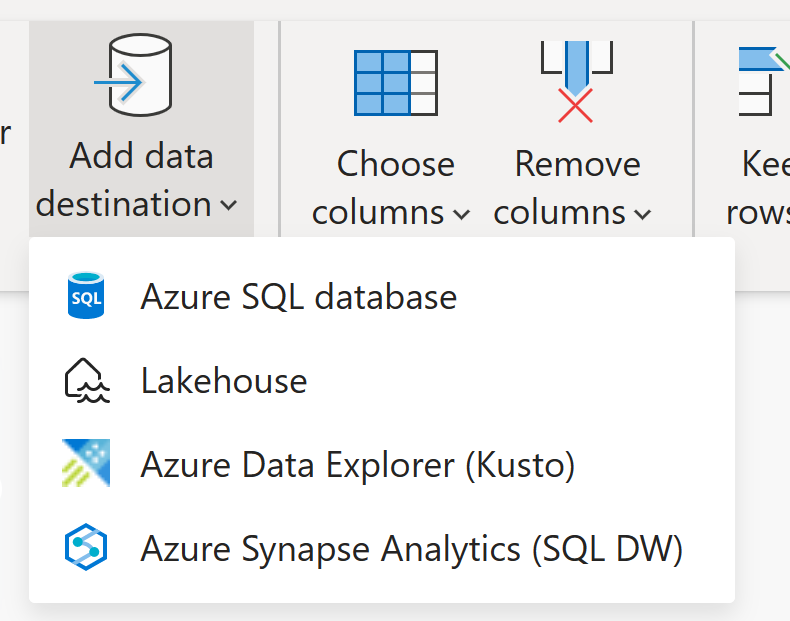

必要な場所にデータを送信する

Dataflow Gen1 は変換されたデータを独自の内部ストレージ (Dataflow コネクタ経由でアクセス可能) に格納しますが、Dataflow Gen2 では、そのストレージを使用したり、さまざまな宛先にデータを送信したりする柔軟性が得られます。

この柔軟性によって、新しい可能性が開かれます。 例えば、あなたは次のことができます:

- データフローを使用してレイクハウスにデータを読み込み、ノートブックで分析する

- Azure SQL データベースにデータを読み込み、パイプラインを使用してデータ ウェアハウスに移動する

Dataflow Gen2 では現在、次の変換先がサポートされています。

- Azure SQL データベース

- Azure Data Explorer (Kusto)

- Azure Datalake Gen2 (プレビュー)

- ファブリック レイクハウス テーブル

- Fabric Lakehouse Files (プレビュー)

- Fabric Warehouse

- Fabric KQL データベース

- Fabric SQL データベース

- SharePoint ファイル

使用可能なデータ変換先の詳細については、「 Dataflow Gen2 データ変換先と管理設定」を参照してください。

モニタリングと更新追跡の改善

Dataflow Gen2 を使用すると、データ更新で何が起こっているのかをより明確に把握できます。 監視ハブと統合され、更新履歴エクスペリエンスが向上しました。そのため、データフローの状態とパフォーマンスを追跡できます。

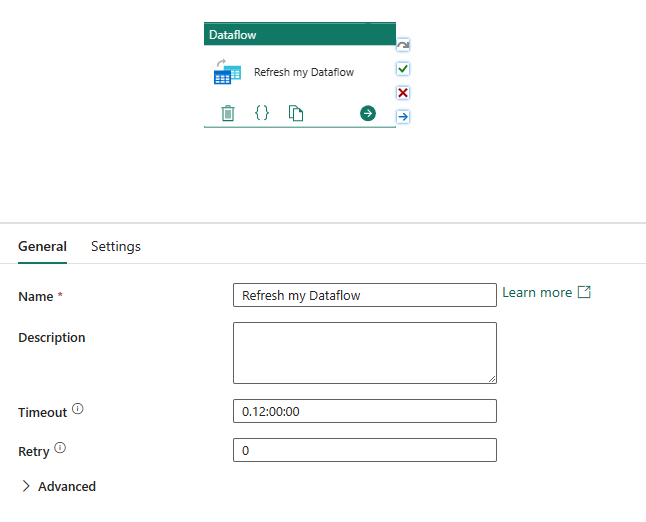

パイプラインとシームレスに連携

パイプラインを使用すると、アクティビティをグループ化して、より大きなタスクを完了できます。 データのコピー、SQL クエリの実行、ストアド プロシージャの実行、または Python ノートブックの実行を行うことができるワークフローと考えてください。

パイプライン内の複数のアクティビティを接続し、スケジュールに従って実行するように設定できます。 たとえば、毎週月曜日にパイプラインを使用して Azure BLOB からデータをプルしてクリーンアップし、Dataflow Gen2 をトリガーしてログ データを分析できます。 または、月末に Azure BLOB から Azure SQL データベースにデータをコピーし、そのデータベースでストアド プロシージャを実行することもできます。

データフローとパイプラインの接続の詳細については、 データフロー アクティビティに関するページを参照してください。

ハイ パフォーマンス コンピューティング

Dataflow Gen2 では、高度なコンピューティング ファブリック SQL コンピューティング エンジンを使用して、大量のデータを効率的に処理します。 この作業を行うために、Dataflow Gen2 はワークスペースに Lakehouse と Warehouse の両方の項目を作成し、それらを使用してデータの格納とアクセスを行い、すべてのデータフローのパフォーマンスを向上させます。

データフロー Gen2 の Copilot

Dataflow Gen2 は Fabric の Microsoft Copilot と統合され、自然言語プロンプトを使用してデータ統合ソリューションを作成するための AI を活用した支援を提供します。 Copilot は、会話言語を使用してデータ変換と操作を実行できるようにすることで、データフロー開発プロセスを効率化するのに役立ちます。

- ソースからデータを取得する: "データの取得元" スターター プロンプトを使用して、OData、データベース、ファイルなどのさまざまなデータ ソースに接続します

-

自然言語でデータを変換する: 次のような会話型プロンプトを使用して変換を適用します。

- "ヨーロッパの顧客のみを維持する"

- "市区町村別の従業員の合計数をカウントする"

- "数量が中央値を超えている注文のみを保持する"

- サンプル データの作成: Azure OpenAI を使用してテストおよび開発用のサンプル データを生成する

- 元に戻す操作: "元に戻す" を入力または選択して、最後に適用した手順を削除します

- 検証と確認: 各 Copilot アクションが応答カードとして表示され、[適用されたステップ] リストに対応するステップが表示されます

詳細については、「 データフロー Gen2 の Copilot」を参照してください。

データフローを使用するには何が必要ですか?

データフロー Gen2 には、Fabric 容量または Fabric 試用版容量が必要です。 データフローのライセンスのしくみを理解するには、 Microsoft Fabric の概念とライセンスを確認してください。

データフロー Gen1 から Gen2 への移行

Gen1 で構築されたデータフローが既にある場合は、心配する必要はありません。Gen2 に簡単に移行できます。 切り替えを行う際に役立つオプションがいくつかあります。

クエリのエクスポートとインポート

Dataflow Gen1 クエリをエクスポートして PQT ファイルに保存し、それらを Dataflow Gen2 にインポートできます。 詳細な手順については、「 エクスポート テンプレート機能を使用する」を参照してください。

Power Query でコピーして貼り付ける

Power BI または Power Apps にデータフローがある場合は、クエリをコピーして Dataflow Gen2 エディターに貼り付けることができます。 この方法を使用すると、クエリを最初から再構築しなくても移行できます。 詳細情報: 既存の Dataflow Gen1 クエリをコピーして貼り付けます。

[名前を付けて保存] 機能を使用する

任意の種類のデータフロー (Gen1、Gen2、または Gen2 CI/CD) が既にある場合、Data Factory には名前を付けて保存機能が含まれるようになりました。 これにより、既存のデータフローを 1 つのアクションだけで新しい Dataflow Gen2 (CI/CD) 項目として保存できます。 詳細については: 『名前を付けて保存』を使用して Dataflow Gen2 (CI/CD) に移行します。

関連コンテンツ

さらに詳しい情報については、 次の役に立つリソースを確認してください。

- データフローを監視する - 更新履歴とパフォーマンスを追跡する

- 作業中に下書きを保存 する - 自動保存機能について

- Gen1 から Gen2 への移行 - ステップ バイ ステップ移行ガイド