중요합니다

Azure Data Lake Analytics는 2024년 2월 29일에 사용 중지되었습니다. 에 대해 더 알고 싶다면 이 공지을 확인하세요.

데이터 분석을 위해 조직은 Azure Synapse Analytics 또는 Microsoft Fabric을 사용할 수 있습니다.

Azure Data Lake Analytics 서비스는 쿼리 저장소에서 제출된 작업을 보관합니다. 이 문서에서는 Azure Data Lake Tools for Visual Studio에서 작업 브라우저 및 작업 보기를 사용하여 기록 작업 정보를 찾는 방법을 알아봅니다.

기본적으로 Data Lake Analytics 서비스는 30일 동안 작업을 보관합니다. 만료 기간은 사용자 지정된 만료 정책을 구성하여 Azure Portal에서 구성할 수 있습니다. 만료 후에는 작업 정보에 액세스할 수 없습니다.

필수 조건

Data Lake Tools for Visual Studio 필수 구성 요소참조하세요.

작업 브라우저 열기

Visual Studio에서 Server Explorer,>Azure,>Data Lake Analytics,>작업를 통해 작업 브라우저에 접근합니다. 작업 브라우저를 사용하여 Data Lake Analytics 계정의 쿼리 저장소에 액세스할 수 있습니다. 작업 브라우저는 왼쪽에 쿼리 저장소를 표시하고, 기본 작업 정보를 표시하고, 오른쪽에는 자세한 작업 정보를 보여 주는 작업 보기가 표시됩니다.

작업 보기

작업 보기에는 작업의 자세한 정보가 표시됩니다. 작업을 열려면 작업 브라우저에서 작업을 두 번 클릭하거나 작업 보기를 클릭하여 Data Lake 메뉴에서 작업을 열 수 있습니다. 작업 URL로 채워진 대화 상자가 표시됩니다.

작업 보기에는 다음이 포함됩니다.

작업 요약

작업 보기를 새로 고쳐 실행 작업에 대한 최신 정보를 확인합니다.

작업 상태(그래프):

작업 상태는 작업 단계를 간략하게 설명합니다.

Azure Data Lake Analytics 작업 단계를 보여 주는

준비: 컴파일 서비스를 사용하여 스크립트를 컴파일하고 최적화하여 클라우드에 스크립트를 업로드합니다.

대기 중: 작업이 충분한 리소스를 기다리거나 계정 제한당 최대 동시 작업을 초과할 때 큐에 대기합니다. 우선 순위 설정은 대기 중인 작업의 순서를 결정합니다. 숫자가 낮을수록 우선 순위가 높습니다.

실행 중: 작업이 실제로 Data Lake Analytics 계정에서 실행되고 있습니다.

완료: 작업이 완료됩니다(예: 파일 완료).

작업은 모든 단계에서 실패할 수 있습니다. 예를 들어 준비 단계의 컴파일 오류, 대기 중인 단계의 시간 제한 오류 및 실행 단계의 실행 오류 등이 있습니다.

기본 정보

기본 작업 정보는 작업 요약 패널의 아래쪽 부분에 표시됩니다.

텍스트 상자에 설명이 포함된 작업 요약을 보여 주는

- 작업 결과: 성공 또는 실패. 작업은 모든 단계에서 실패할 수 있습니다.

- 총 기간: 제출 시간과 종료 시간 사이의 벽시계 시간(기간)입니다.

- 총 컴퓨팅 시간: 모든 꼭짓점 실행 시간의 합계로, 작업이 하나의 꼭짓점에서만 실행되는 시간으로 간주할 수 있습니다. 꼭짓점에 대한 자세한 내용은 '총 꼭짓점'이라는 항목을 참조하세요.

- 제출/시작/종료 시간: Data Lake Analytics 서비스가 작업 제출을 받거나 작업을 실행하기 시작/작업을 성공적으로 종료하는 시간입니다.

- 컴파일/큐 대기/실행: 준비 중/대기 중/실행 중인 단계에서 소요된 경과 시간입니다.

- 계정: 작업을 실행하는 데 사용되는 Data Lake Analytics 계정입니다.

- 작성자: 작업을 제출한 사용자는 실제 사용자의 계정 또는 시스템 계정일 수 있습니다.

- 우선 순위: 작업의 우선 순위입니다. 숫자가 낮을수록 우선 순위가 높습니다. 큐에서 작업의 순서에만 영향을 줍니다. 더 높은 우선 순위를 설정해도 실행 중인 작업이 선점되지 않습니다.

- 병렬 처리: 정점이라고도 하는 동시 Azure Data Lake Analytics 단위(ADLAUs)의 요청된 최대 수입니다. 현재 하나의 꼭짓점은 두 개의 가상 코어와 6GB RAM이 있는 하나의 VM과 동일하지만 향후 Data Lake Analytics 업데이트에서 업그레이드할 수 있습니다.

- 남은 바이트: 작업이 완료될 때까지 처리해야 하는 바이트입니다.

- 읽기/쓰기 바이트: 작업이 실행되기 시작한 이후 읽거나 쓴 바이트입니다.

- 전체 꼭짓점: 작업은 여러 개의 작업으로 나뉘며, 각 작업을 꼭짓점이라고 합니다. 이 값은 작업이 구성되는 작업 수를 설명합니다. 꼭짓점을 ADLAU(Azure Data Lake Analytics Unit)라고도 하는 기본 프로세스 단위로 간주할 수 있으며 꼭짓점은 병렬 처리로 실행할 수 있습니다.

- 완료/실행/실패: 완료된/실행 중인/실패한 꼭짓점의 수. 사용자 코드와 시스템 오류로 인해 꼭짓점이 실패할 수 있지만, 시스템에서는 실패한 꼭짓점을 자동으로 여러 번 다시 시도합니다. 다시 시도 후 꼭짓점이 여전히 실패하면 전체 작업이 실패합니다.

작업 그래프

U-SQL 스크립트는 입력 데이터를 출력 데이터로 변환하는 논리를 나타냅니다. 스크립트는 준비 단계에서 실제 실행 계획으로 컴파일되고 최적화됩니다. 작업 그래프는 실제 실행 계획을 표시하는 것입니다. 아래 다이어그램은 이 프로세스를 보여 줍니다.

Azure Data Lake Analytics 작업 단계 상태

Azure Data Lake Analytics job phases status

Azure Data Lake Analytics job phases status작업은 여러 작업으로 나뉩니다. 각 작업은 Vertex(꼭짓점)이라고 불립니다. 꼭짓점은 슈퍼 꼭짓점(스테이지라고도 함)으로 그룹화되고 작업 그래프로 시각화됩니다. 작업 그래프의 녹색 스테이지 플래카드는 스테이지를 보여 줍니다.

단계의 모든 꼭짓점은 동일한 데이터의 여러 조각으로 동일한 종류의 작업을 수행합니다. 예를 들어, 1TB 데이터가 있는 파일에서 수백 개의 컴퓨팅 노드가 각각 청크를 읽는 경우입니다. 이러한 꼭짓점은 동일한 단계에서 그룹화되고 동일한 입력 파일의 다른 부분에서 동일한 작업을 수행합니다.

-

특정 단계에서는 일부 숫자가 플래카드에 표시됩니다.

Azure Data Lake Analytics 작업 그래프 단계

Azure Data Lake Analytics job graph stage

Azure Data Lake Analytics job graph stageSV1 추출: 숫자와 작업 메서드로 명명된 스테이지의 이름입니다.

84개의 꼭짓점: 이 단계의 총 꼭짓점 수입니다. 이 그림은 이 단계에서 분할된 작업의 수를 나타냅니다.

12.90 s/꼭짓점: 이 단계의 평균 꼭짓점 실행 시간입니다. 이 수치는 SUM(모든 꼭짓점 실행 시간) /(총 꼭짓점 수)로 계산됩니다. 즉, 병렬 처리로 실행되는 모든 꼭짓점을 할당할 수 있으면 전체 단계가 12.90초 안에 완료됩니다. 또한 이 단계의 모든 작업이 순차적으로 수행되면 비용은 #vertices * AVG 시간이 됩니다.

850,895개의 행이 작성되었습니다. 이 단계에서 작성된 총 행 수입니다.

R/W: 이 단계에서 읽거나 쓴 데이터의 양(바이트)입니다.

색: 단계에서 색이 다른 꼭짓점 상태를 나타내는 데 사용됩니다.

- 녹색은 꼭짓점이 성공했음을 나타냅니다.

- 주황색은 꼭짓점이 다시 시도됨을 나타냅니다. 다시 시도된 꼭짓점이 실패했지만 시스템에 의해 자동으로 성공적으로 다시 시도되고 전체 단계가 성공적으로 완료됩니다. 꼭짓점이 다시 시도되었지만 여전히 실패하면 색이 빨간색으로 바뀌고 전체 작업이 실패합니다.

- 빨간색은 실패를 나타냅니다. 즉, 특정 꼭짓점이 시스템에서 몇 번 다시 시도되었지만 여전히 실패했음을 의미합니다. 이 시나리오에서는 전체 작업이 실패합니다.

- 파란색은 특정 꼭짓점이 작동 중임을 의미합니다.

- 흰색은 꼭짓점이 대기 중임을 나타냅니다. ADLAU를 사용할 수 있게 되면 꼭짓점이 예약되기를 기다리거나, 입력 데이터가 준비되지 않았기 때문에 입력을 기다리고 있을 수 있습니다.

특정 상태에 마우스 커서를 올리면 스테이지에 대한 자세한 내용을 확인할 수 있습니다.

Azure Data Lake Analytics 작업 그래프 단계 세부 정보

Azure Data Lake Analytics job graph stage details

Azure Data Lake Analytics job graph stage details

꼭짓점: 꼭짓점 세부 정보(예: 총 꼭짓점 수, 완료된 꼭짓점 수, 실패했거나 여전히 실행 중/대기 중)를 설명합니다.

데이터 읽기 크로스/인트라 포드: 파일과 데이터는 분산 파일 시스템의 여러 포드에 저장됩니다. 이 값은 동일한 Pod 또는 크로스 Pod에서 읽은 데이터의 양을 설명합니다.

총 컴퓨팅 시간: 단계의 모든 꼭짓점 실행 시간의 합계로, 단계의 모든 작업이 하나의 꼭짓점에서만 실행되는 경우 걸리는 시간으로 간주할 수 있습니다.

데이터 및 행 작성/읽기: 읽거나 읽어야 하는 데이터 또는 행의 양을 나타냅니다.

꼭짓점 읽기 실패: 데이터를 읽는 동안 실패한 꼭짓점 수를 설명합니다.

꼭짓점 중복 삭제: 꼭짓점이 너무 느리게 실행되면 시스템에서 동일한 작업을 실행하도록 여러 꼭짓점을 예약할 수 있습니다. 꼭짓점 중 하나가 성공적으로 완료되면 중복 꼭짓점이 삭제됩니다. 꼭짓점 중복 삭제 단계에서는 중복으로 인해 삭제된 꼭짓점의 수를 기록합니다.

버텍스 해지: 버텍스가 성공적으로 완료되었지만, 여러 가지 이유로 나중에 다시 실행됩니다. 예를 들어 다운스트림 꼭짓점에서 중간 입력 데이터가 손실되면 업스트림 꼭짓점에서 다시 실행하도록 요청합니다.

꼭짓점 스케줄 실행: 꼭짓점이 계획되었던 총 시간입니다.

최소/평균/최대 꼭짓점 데이터 읽기: 모든 꼭짓점 읽기 데이터의 최소/평균/최대값입니다.

기간: 단계에 소요되는 경과 시간입니다. 값을 보려면 프로필을 로드하세요.

작업 재생

Data Lake Analytics는 작업을 실행하며, 꼭짓점의 시작, 중지, 실패 및 재시도를 포함한 실행 정보를 보관합니다. 모든 정보는 쿼리 저장소에 자동으로 기록되고 작업 프로필에 저장됩니다. 작업 보기에서 "프로필 로드"를 통해 작업 프로필을 다운로드할 수 있으며 작업 프로필을 다운로드한 후 작업 재생을 볼 수 있습니다.

작업 재생은 클러스터에서 발생한 작업을 시각화하는 전형입니다. 작업 실행 진행 상황을 확인하고 매우 짧은 시간(일반적으로 30초 미만)에 성능 이상 현상과 병목 현상을 시각적으로 감지하는 데 도움이 됩니다.

작업 열 지도 표시

작업 히트맵은 작업 그래프의 표시 드롭다운을 통해 선택할 수 있습니다.

Azure Data Lake Analytics 작업 그래프 힙맵 표시

작업의 I/O, 시간 및 처리량 열 지도를 보여 줍니다. 이를 통해 작업이 대부분의 시간을 소비하는 위치 또는 작업이 I/O 경계 작업인지 여부를 확인할 수 있습니다.

- 진행률: 작업 실행 진행률, 단계 정보의 정보를 참조하세요.

- 읽기/쓰기 데이터: 각 단계에서 읽거나 쓴 총 데이터의 열 지도입니다.

- 컴퓨팅 시간: SUM의 열 지도(모든 꼭짓점 실행 시간)는 단계의 모든 작업이 하나의 꼭짓점만 사용하여 실행되는 경우 걸리는 시간으로 간주할 수 있습니다.

- 노드당 평균 실행 시간: SUM(모든 꼭짓점 실행 시간)/(꼭짓점 번호)의 열 지도입니다. 즉, 병렬 처리로 실행되는 모든 꼭짓점을 할당할 수 있으면 이 시간 프레임에서 전체 단계가 수행됩니다.

- 입력/출력 처리량: 각 단계의 입력/출력 처리량의 열 지도입니다. 이를 통해 작업이 I/O 바인딩된 작업인지 확인할 수 있습니다.

-

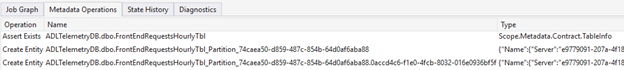

메타데이터 작업

데이터베이스 만들기, 테이블 삭제 등 U-SQL 스크립트에서 일부 메타데이터 작업을 수행할 수 있습니다. 이러한 작업은 컴파일 후 메타데이터 작업에 표시됩니다. 어설션을 찾고, 엔터티를 만들고, 엔터티를 여기에 삭제할 수 있습니다.

Azure Data Lake Analytics 작업 보기 메타데이터 작업

국가 역사

상태 기록은 작업 요약에서도 시각화되지만 자세한 내용은 여기에서 확인할 수 있습니다. 작업이 준비, 큐에 대기, 실행 시작, 종료되는 경우와 같은 자세한 정보를 찾을 수 있습니다. 또한 작업이 컴파일된 횟수(CcsAttempts: 1), 실제로 클러스터에 디스패치된 작업(세부 정보: 클러스터에 작업 디스패치)을 찾을 수 있습니다.

Azure Data Lake Analytics 작업 보기 상태 기록

Azure Data Lake Analytics Job View state history

Azure Data Lake Analytics Job View state history진단

도구는 자동으로 작업 실행을 진단합니다. 작업에 몇 가지 오류 또는 성능 문제가 있는 경우 경고를 받게 됩니다. 여기에서 전체 정보를 얻으려면 프로필을 다운로드해야 합니다.

Azure Data Lake Analytics 작업 보기 진단

- 경고: 컴파일러 경고와 함께 경고가 여기에 표시됩니다. 경고가 나타나면 "x 문제" 링크를 선택하여 자세한 내용을 확인할 수 있습니다.

- 꼭짓점이 너무 오래 실행됩니다. 꼭짓점이 정해진 시간을 넘기면(예: 5시간), 여기서 문제가 발견됩니다.

- 리소스 사용: 필요한 것보다 더 많거나 충분하지 않은 병렬 처리를 할당한 경우 여기에서 문제를 찾을 수 있습니다. 또한 리소스 사용량을 선택하여 자세한 내용을 확인하고 가상 시나리오를 수행하여 더 나은 리소스 할당을 찾을 수 있습니다(자세한 내용은 이 가이드 참조).

- 메모리 검사: 꼭짓점에서 5GB 이상의 메모리를 사용하는 경우 여기에서 문제가 발견됩니다. 시스템 제한보다 더 많은 메모리를 사용하는 경우 시스템에서 작업 실행을 종료할 수 있습니다.

작업 세부 정보

작업 세부 정보는 스크립트, 리소스 및 꼭짓점 실행 뷰를 비롯한 작업의 자세한 정보를 보여 줍니다.

Azure Data Lake Analytics 작업 세부 정보 Azure Data Lake Analytics job detail

Azure Data Lake Analytics job detail

스크립트

작업의 U-SQL 스크립트는 쿼리 저장소에 저장됩니다. 원래 U-SQL 스크립트를 보고 필요한 경우 다시 제출할 수 있습니다.

리소스

리소스를 통해 쿼리 저장소에 저장된 작업 컴파일 출력을 찾을 수 있습니다. 예를 들어 여기에서 작업 그래프, 등록한 어셈블리 등을 표시하는 데 사용되는 "algebra.xml"를 찾을 수 있습니다.

버텍스 실행 보기

정점 실행 세부 정보를 표시합니다. 작업 프로필은 총 데이터 읽기/쓰기, 런타임, 상태 등과 같은 모든 꼭짓점 실행 로그를 보관합니다. 이 보기를 통해 작업 실행 방법에 대한 자세한 내용을 확인할 수 있습니다. 자세한 내용은 Visual Studio의 Data Lake Tools에서 꼭짓점 실행 뷰 사용하기 를 참조하세요.

다음 단계

- 진단 정보를 기록하려면 Azure Data Lake Analytics 대한 진단 로그 액세스 참조하세요.

- 더 복잡한 쿼리를 보려면 Azure Data Lake Analytics 사용하여 웹 사이트 로그 분석참조하세요.

- 꼭짓점 실행 보기를 사용하려면 Data Lake Tools for Visual Studio에서 꼭짓점 실행 보기를 참조하십시오