Nota

O acesso a esta página requer autorização. Pode tentar iniciar sessão ou alterar os diretórios.

O acesso a esta página requer autorização. Pode tentar alterar os diretórios.

APLICA-SE A: Todas as camadas de gerenciamento de API

Você pode importar endpoints de modelo de linguagem compatíveis com OpenAI para a sua instância de Gestão de API como APIs. Você também pode importar modelos de linguagem que não são compatíveis com OpenAI como APIs de passagem direta, que encaminham as solicitações diretamente para os pontos de extremidade de back-end. Por exemplo, você pode querer gerenciar um LLM que você auto-hospeda ou que está hospedado em um provedor de inferência diferente dos serviços de IA do Azure. Use políticas de gateway de IA e outros recursos no Gerenciamento de API para simplificar a integração, melhorar a observabilidade e aprimorar o controle sobre os pontos de extremidade do modelo.

Saiba mais sobre como gerenciar APIs de IA no Gerenciamento de API:

Tipos de API de modelo de linguagem

O Gerenciamento de API oferece suporte a dois tipos de APIs de modelo de linguagem para esse cenário. Escolha a opção adequada para a implantação do seu modelo. A opção determina como os clientes chamam a API e como a instância de Gerenciamento de API roteia solicitações para o serviço de IA.

Compatível com OpenAI - Pontos finais de modelo de linguagem que são compatíveis com a API da OpenAI. Os exemplos incluem certos modelos expostos por provedores de inferência, como o Hugging Face Text Generation Inference (TGI) e a API do Google Gemini.

Para um LLM compatível com OpenAI, a Gestão de API configura um endpoint de conclusão de conversas.

Passthrough - Outros pontos de extremidade de modelos de linguagem que não são compatíveis com a API da OpenAI. Os exemplos incluem modelos implantados no Amazon Bedrock ou em outros provedores.

O Gerenciamento de API configura operações curinga para verbos HTTP comuns. Os clientes podem acrescentar caminhos às operações curinga, e o Gerenciamento de API passa solicitações para o back-end.

Pré-requisitos

- Uma instância de gerenciamento de API existente. Crie um, caso ainda não o tenha feito.

- Uma implantação de modelo de linguagem auto-hospedada ou não fornecida pelo Azure com um ponto de extremidade de API.

Importar API de modelo de idioma usando o portal

Quando você importa a API LLM no portal, o Gerenciamento de API configura automaticamente:

- Um recurso de back-end e uma política set-backend-service que direcionam solicitações de API para o endpoint LLM.

- (opcionalmente) Acesso ao back-end LLM usando uma chave de acesso fornecida. A chave é protegida como um valor nomeado secreto no Gerenciamento de API.

- (opcionalmente) Políticas para ajudá-lo a monitorar e gerenciar a API.

Para importar uma API de modelo de idioma para o Gerenciamento de API:

No portal do Azure, navegue até sua instância de Gerenciamento de API.

No menu à esquerda, em APIs, selecione APIs>+ Add API.

Em Definir uma nova API, selecione Language Model API.

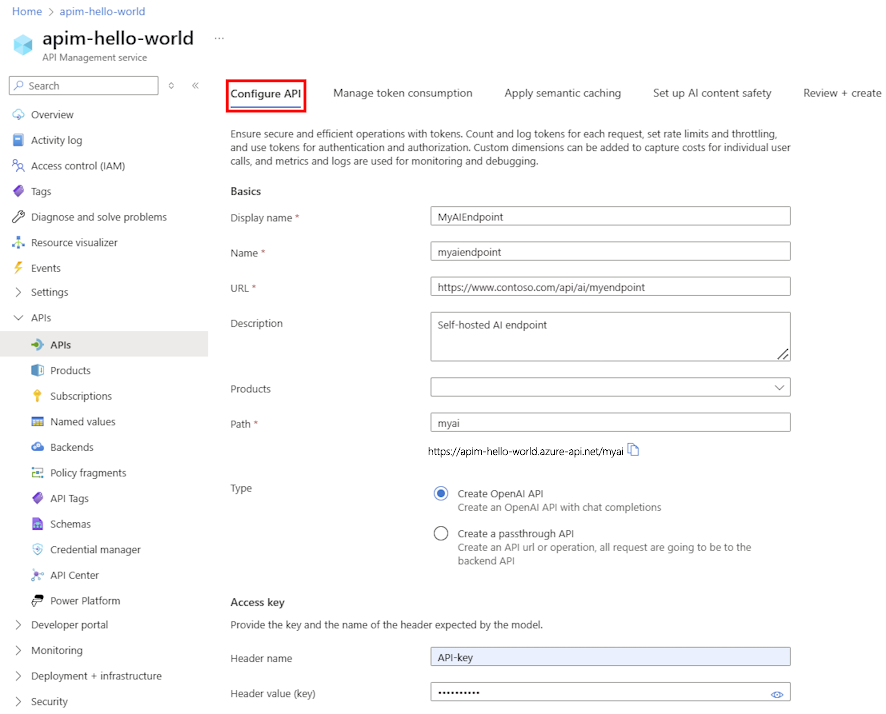

Na aba Configurar API:

- Insira um Nome para exibição e uma Descrição opcional para a API.

- Insira o URL para o endpoint da API LLM.

- Opcionalmente, selecione um ou mais Produtos para associar à API.

- Em Caminho, acrescente um caminho que sua instância de Gerenciamento de API usa para acessar os pontos de extremidade da API LLM.

- Em Tipo, selecione Criar API OpenAI ou Criar uma API de passagem. Consulte Tipos de API de modelo de linguagem para obter mais informações.

- Em Chave de acesso, insira o nome do cabeçalho de autorização e a chave da API usada para acessar a API LLM, se necessário.

- Selecione Seguinte.

Na guia Gerenciar consumo de token , opcionalmente, insira configurações ou aceite padrões que definam as seguintes políticas para ajudar a monitorar e gerenciar a API:

Na guia Aplicar cache semântico , opcionalmente, insira configurações ou aceite padrões que definem as políticas para ajudar a otimizar o desempenho e reduzir a latência da API:

Na segurança de conteúdo de IA, opcionalmente, insira configurações ou aceite padrões para configurar o serviço de Segurança de Conteúdo de IA do Azure para bloquear prompts com conteúdo não seguro:

Selecione Revisão.

Depois que as configurações forem validadas, selecione Criar.

A Gestão de API cria a API e configura operações para os endpoints LLM. Por padrão, a API requer uma assinatura de Gerenciamento de API.

Testar a LLM API

Para garantir que sua API LLM esteja funcionando conforme o esperado, teste-a no console de teste de Gerenciamento de API.

Selecione a API que criou no passo anterior.

Selecione a guia Teste .

Selecione uma operação que seja compatível com a implantação do modelo. A página exibe campos para parâmetros e cabeçalhos.

Insira parâmetros e cabeçalhos conforme necessário. Dependendo da operação, talvez seja necessário configurar ou atualizar um corpo de solicitação.

Observação

No console de teste, a Gestão de API preenche automaticamente um cabeçalho Ocp-Apim-Subscription-Key e configura a chave de subscrição da subscrição de acesso total interna. Essa chave permite o acesso a todas as APIs na instância de Gerenciamento de API. Opcionalmente, mostre o cabeçalho Ocp-Apim-Subscription-Key ao selecionar o ícone de "olho" ao lado da Solicitação HTTP.

Selecione Enviar.

Quando o teste é bem-sucedido, o back-end responde com um código de resposta HTTP bem-sucedido e alguns dados. Anexados à resposta estão dados de uso de token para ajudá-lo a monitorar e gerenciar o consumo de token do modelo de idioma.